简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文概述了Transformer模型的核心机制。首先通过分词和词嵌入将输入转换为向量,并加入位置信息。关键在于自注意力机制:使用QKV矩阵计算词间关联,通过多头注意力整合上下文信息。编码器通过残差网络和归一化处理梯度消失问题,解码器则利用掩码和交叉注意力生成输出。最终将上下文向量投影到词汇空间,预测下一个词。Transformer通过这一系列操作实现语义理解与生成,每个步骤均保持512维向量不变。

用小白都能懂的话,聊懂人工智能的理论基础

本文系统介绍了大模型微调与部署的关键技术。主要内容包括:1. 模型微调方法:监督微调(SFT)、基于人类反馈的强化学习(RLHF)、直接偏好优化(DPO)等;2. 微调加速技术:LoRA通过低秩矩阵分解降低计算量;3. 检索增强生成(RAG)技术,结合外部知识库提升模型实时性;4. 模型部署流程,包括推理引擎选择及标准化调用接口。文章详细阐述了各种微调方法的数据准备、实现原理及适用场景,特别对RL

摘要:本文系统介绍了大模型开发的核心流程和关键技术。首先阐述了预训练(获取基础能力)、微调(增强专项能力)和部署(模型服务化)的概念及相互关系。其次详细说明了基于HuggingFace标准的模型训练方法,包括代码库和可视化平台两种途径。然后列举了SFT、RLHF、DPO等主流微调技术,以及LORA、RAG等增强手段。最后对模型进行了系统分类,涵盖文本理解、生成、多模态等8大类典型任务,并指出虽然应

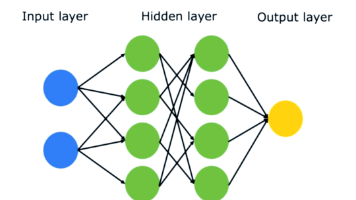

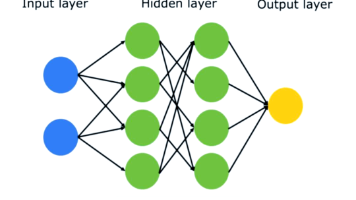

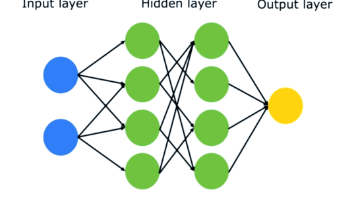

一文详解人工智能一次训练过程。

摘要:本文系统介绍了大模型开发的核心流程和关键技术。首先阐述了预训练(获取基础能力)、微调(增强专项能力)和部署(模型服务化)的概念及相互关系。其次详细说明了基于HuggingFace标准的模型训练方法,包括代码库和可视化平台两种途径。然后列举了SFT、RLHF、DPO等主流微调技术,以及LORA、RAG等增强手段。最后对模型进行了系统分类,涵盖文本理解、生成、多模态等8大类典型任务,并指出虽然应

快速讲解Prometheus+grafana实现spring boot的可视化监控。

本文概述了Transformer模型的核心机制。首先通过分词和词嵌入将输入转换为向量,并加入位置信息。关键在于自注意力机制:使用QKV矩阵计算词间关联,通过多头注意力整合上下文信息。编码器通过残差网络和归一化处理梯度消失问题,解码器则利用掩码和交叉注意力生成输出。最终将上下文向量投影到词汇空间,预测下一个词。Transformer通过这一系列操作实现语义理解与生成,每个步骤均保持512维向量不变。

都是用来存储文档的,ES和MongoDB到底有什么区别?一文聊懂。

自增主键的弊端以及常用主键生成算法生成合理主键。