简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

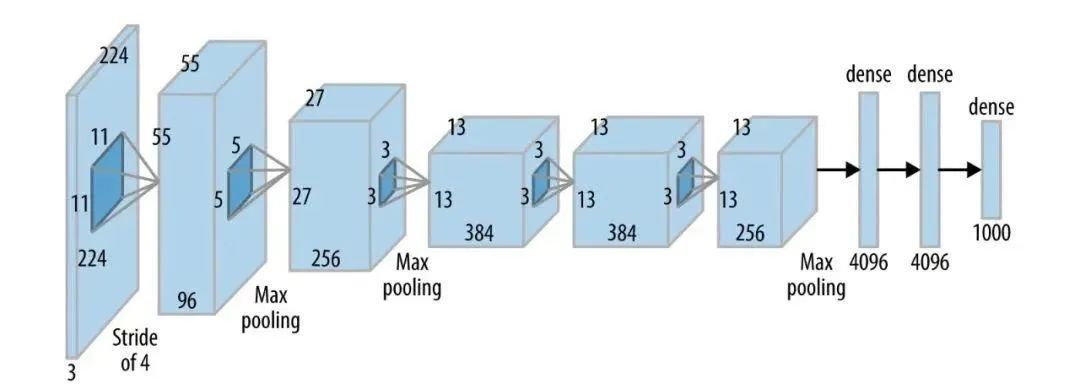

此前,我们介绍了很多深度学习基础模型,今天探讨它们各自适用的场景,让您知道在何种情况下选择何种模型;同时分析它们的优势与局限,助您全面评估这些模型的性能。

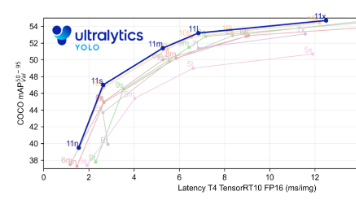

Ultralytics YOLO11是一款尖端的、最先进的模型,它在之前YOLO版本成功的基础上进行了构建,并引入了新功能和改进,以进一步提升性能和灵活性。YOLO11设计快速、准确且易于使用,使其成为各种物体检测和跟踪、实例分割、图像分类以及姿态估计任务的绝佳选择。借鉴V10 PSA结构,实现了C2PSA和C2fPSA,最终选择了基于C2的C2PSA(可能涨点更好?实现代码****ult

内容概要:包括 内网、操作系统、协议、渗透测试、安服、漏洞、注入、XSS、CSRF、SSRF、文件上传、文件下载、文件包含、XXE、逻辑漏洞、工具、SQLmap、NMAP、BP、MSF…技术文档也是我自己整理的,包括我参加大型网安行动、CTF和挖SRC漏洞的经验和技术要点,电子书也有200多本,由于内容的敏感性,我就不一一展示了。网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己录的网安

众所周知,云计算改变了整个传统IT产业的基础架构,而大数据则改变了IT业务模式。那么在云计算大数据时代,传统的Linux系统运维应该怎么顺应技术的发展呢?今天我们就来聊一聊大数据运维工程师。一图胜千言,针对运维工程师在公司都有哪些岗位,我们不妨看看下面这张图。01 根据业务规划和未来业务演进评估集群规模、存储规模、算力需求、技术选型等。02 大数据生态组件高可用部署,安全合规保障。03 开发人员使

如果不想 Ambari 管理主机到机架信息,可以使用自定义到拓扑脚本。要做到这一点,必须创建自己的拓扑脚本管理分布脚本到所有主机。注意,也因为Ambari 不能访问到主机机架信息,Ambari Web 中的 heatmaps 不能显示机架。使用自定义脚本设置 Rack ID:步骤:① 浏览到 Services > HDFS > Configs② 修改 net.topology.script.fil

*工具实战:**集中训练抓包工具(Wireshark)、渗透测试工具(Nmap)、漏洞扫描工具(Nessus 基础版)的使用,结合模拟场景练习工具应用(掌握基础扫描逻辑,为 SRC 漏扫工具进阶做准备)。实战技能训练:开展漏洞扫描、漏洞利用、电商系统渗透测试、内网渗透、权限提升(Windows、Linux)、代码审计等实战训练,结合运维中熟悉的系统环境设计测试场景(强化红蓝对抗攻击端技术能力)。红

事件名采用什么格式、什么时候开始监听事件等等。有兴趣的读者,可以看看笔者之前写的微前端框架:Mooa。不管怎样,iframe 对于我们今年的 KPI 怕是带不来一丝的好处,那么我们就去造个轮子吧。

为了准备期末考试,同时也是为了之后复习方便,特对计算机网络的知识进行了整理。本篇内容大部分是来源于我们老师上课的ppt。而我根据自己的理解,将老师的PPT整理成博文的形式以便大家复习查阅,同时对于一些不是很清楚的地方,我去查阅了相关资料进行补充,当然也会有少部分个人看法夹带其中来帮助大家理解。应评论要求这里放上本文的思维导图以供大家更好的查看网络边缘:位于互联网边缘与互联网相连的计算机和其他设备,

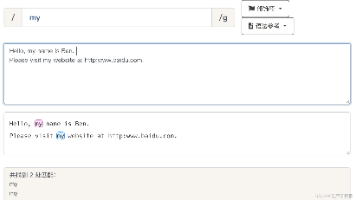

Java对正则表达式的支持是从1.4版本开始的,此前的JRE版本不支持正则表达式。Java语言中的正则表达式匹配功能主要是通过和类实现的。find():在一个字符串里寻找一个给定模式的匹配:用一个给定的模式尝试匹配一个字符串的开头matches():用一个给定的模式去尝试匹配一个完整的字符串:进行替换操作,对所有的匹配都进行替换:进行替换操作,只对第一个匹配进行替换compile():把一个正则表