简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

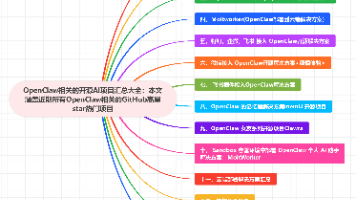

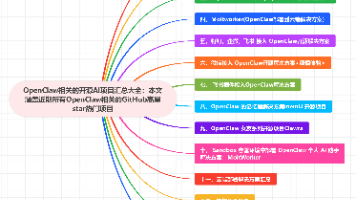

OpenClaw相关的开源AI项目汇总大全:本文涵盖近期所有OpenClaw相关的GitHub高星star热门项目导读一、OpenClawInstaller:终端一键部署方案它能帮你做什么?二、OneClaw:小白零门槛桌面版方案为什么选它而不是官方方案?功能亮点三、OpenClawSkills库|565+技能精选清单为什么必收藏?四、Moltworker|云端部署解放本地硬件解决什么痛点?五、钉

✅ 强烈推荐场景快速验证MCP应用想法(MVP阶段)非技术背景用户使用AI自动化(产品经理/运营)跨设备协作(手机/平板/电脑无缝切换)大文件分析(20MB+文档,本地内存吃紧)❌ 不建议使用场景需要自定义MCP工具(如内部API接入)数据敏感型业务(金融/医疗/政务)高频调用场景(>1000次/天,成本不可控)离线环境使用(必须联网)

OpenClaw相关的开源AI项目汇总大全:本文涵盖近期所有OpenClaw相关的GitHub高星star热门项目导读一、OpenClawInstaller:终端一键部署方案它能帮你做什么?二、OneClaw:小白零门槛桌面版方案为什么选它而不是官方方案?功能亮点三、OpenClawSkills库|565+技能精选清单为什么必收藏?四、Moltworker|云端部署解放本地硬件解决什么痛点?五、钉

VS Code插件OpenClaw-VSCode让程序员无需切换窗口即可在编辑器内直接与OpenClaw AI交互。该插件支持WebSocket连接本地或远程服务器上的OpenClaw网关,提供可视化配置界面和自动重连功能,特别适合配合VS Code远程开发功能使用。主要优势包括:侧边栏即开即聊、SSH远程无缝管理、简化配置流程。项目完全开源(MIT协议),支持WSS加密连接和Token验证,适合

VS Code插件OpenClaw-VSCode让程序员无需切换窗口即可在编辑器内直接与OpenClaw AI交互。该插件支持WebSocket连接本地或远程服务器上的OpenClaw网关,提供可视化配置界面和自动重连功能,特别适合配合VS Code远程开发功能使用。主要优势包括:侧边栏即开即聊、SSH远程无缝管理、简化配置流程。项目完全开源(MIT协议),支持WSS加密连接和Token验证,适合

Claude AI Agent开发|GitHub 7大爆款Skills开源项目:Anthropic官方Skill Creator元技能+Superpowers 27k星任务拆解+Code Review自动代码审查+Context Engineering上下文优化(附安全避坑指南)GitHub 27k星Claude Skills王炸合集|Anthropic官方7大AI Agent神器:Skill C

Clawdbot/Moltbot技术圈爆火神器安装指南 摘要: Clawdbot(现改名Moltbot)是近期在GitHub等技术平台爆火的自动化工具,其核心功能是"交代任务-自动执行"而非简单对话。文章详细介绍了该工具的安装配置流程: 推荐在虚拟机环境下运行 提供从Node.js环境搭建到一键安装的完整步骤 重点说明Discord机器人对接方法 强调安全配置注意事项 展示实际

本文介绍了如何在Linux环境下使用Docker部署Trilium Notes中文版,并结合cpolar实现远程访问。Trilium Notes是一款功能强大的开源知识管理工具,支持树形笔记结构、Markdown编辑、版本控制等。通过Docker-compose快速部署后,使用cpolar内网穿透生成公网地址,解决了局域网访问限制问题。文章详细展示了从安装Docker、配置容器到设置固定公网域名的

Whisper Web是一款基于WebGPU加速的浏览器端语音转文字工具,支持音频上传和语音录入转写,适合内容创作者和会议记录人员。本文详细介绍了其本地部署方法:通过Git克隆项目、安装Node.js环境并运行服务。针对局域网访问限制问题,推荐使用Cpolar内网穿透实现公网访问:安装Cpolar后创建隧道,生成随机或固定的公网地址(支持HTTP/HTTPS),即可随时随地访问本地部署的Whisp

摘要:本文介绍了Stable Diffusion3.5 AI绘图工具的本地部署与远程使用方法。该工具支持通过文本生成高质量图像,推荐8G以上显存配置。文章详细说明了ComfyUI的安装流程、中文语言包配置,以及Stable Diffusion3.5模型的下载步骤,重点演示了文生图功能的具体操作。通过结合cpolar实现公网访问,用户可突破局域网限制,实现随时随地远程操作。教程包含图文指引和视频链接