简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

个人开发者:优先使用Ollama(零配置)或Transformers(灵活)。企业高并发场景:选择vLLM(吞吐量)或SGLang(结构化输出)。边缘计算/实时交互:LMDeploy的低延迟特性最佳。分布式需求:DeepSpeed和ModelScope支持多节点扩展。通过合理选择框架,开发者可最大化发挥大模型的性能潜力。建议结合业务需求参考官方文档调整参数,并监控GPU显存与吞吐量指标。

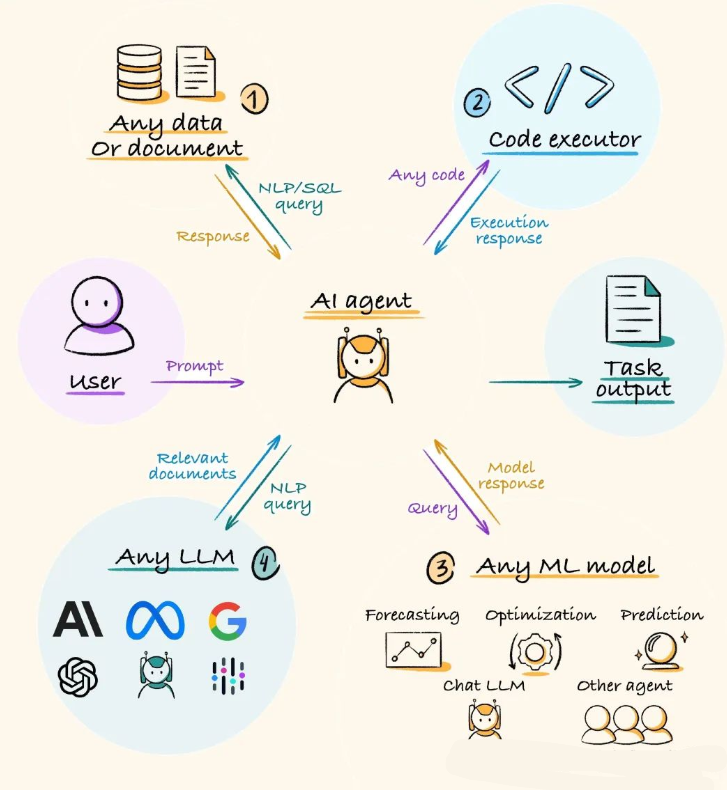

在AI技术飞速发展的今天,AI Agent已经成为了一个热门的研究和应用领域。无论是企业还是个人开发者,都希望能够借助AI Agent来提升工作效率、优化业务流程或创造全新的用户体验。然而,从零开始构建一个AI Agent并非易事,幸运的是,市面上有许多优秀的框架可以帮助我们快速入坑。今天,就让我们一起来看看2025年值得入坑的五大AI Agent框架吧!

文章详细介绍了大模型推理引擎与框架的区别,并对比了10款主流工具,按用户类型分类。LMStudio适合零基础用户,llama.cpp和MLC-LLM适合个人开发者,vLLM、TensorRT-LLM等企业级框架提供高性能部署能力。各工具支持不同硬件和优化技术,用户可根据需求选择合适方案。大模型经过漫长的训练,最终需要推理评估,走向实际应用。就像人一样,经过多年的学习,最终需要通过面试,走向社会工作

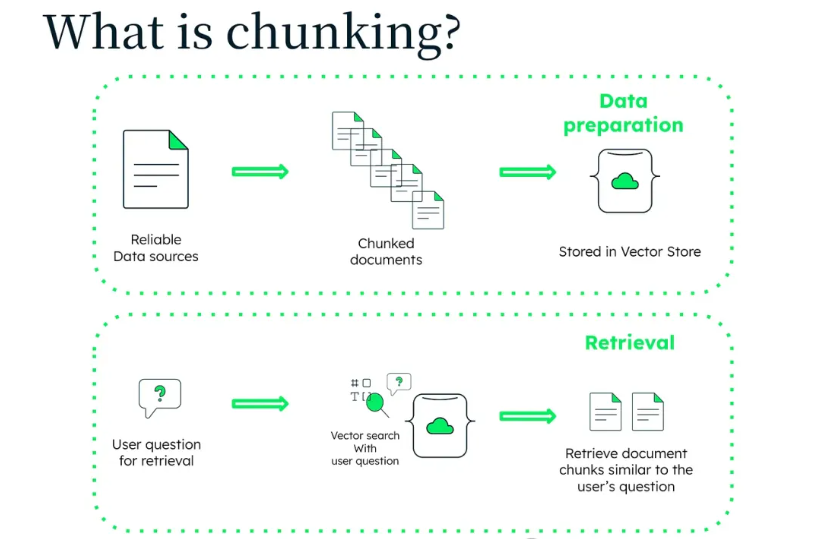

聪明人往往很“懒”,但这种“懒”其实是高效的体现。他们总能找到解决复杂问题的最佳路径,用最少的力气获得最大的成果。在RAG系统中,这种高效的实现往往是通过“分块”来实现的。你可以把它想象成把一本厚书分成几章——这样一来,阅读和理解就轻松多了。同样地,分块技术把大段复杂的文本拆分成更小、更容易处理的片段,让AI能更快、更准确地理解和处理信息。不过,在深入探讨分块之前,咱们得先聊聊它背后的“大框架”—

近年来,随着大型语言模型(LLMs)的兴起,自然语言处理技术取得了飞速发展。从GPT到Llama,这些前沿的语言模型在各个领域中展现出了令人惊叹的能力。然而,训练这些顶级模型的过程却充满了挑战。以Llama-3.1-405B为例,其训练过程中需要约3900万个GPU小时,相当于4500年单GPU计算时间。为了在几个月内完成这样的训练,工程师们采用了4D并行化的策略,跨越数据、张量、上下文和管道等多

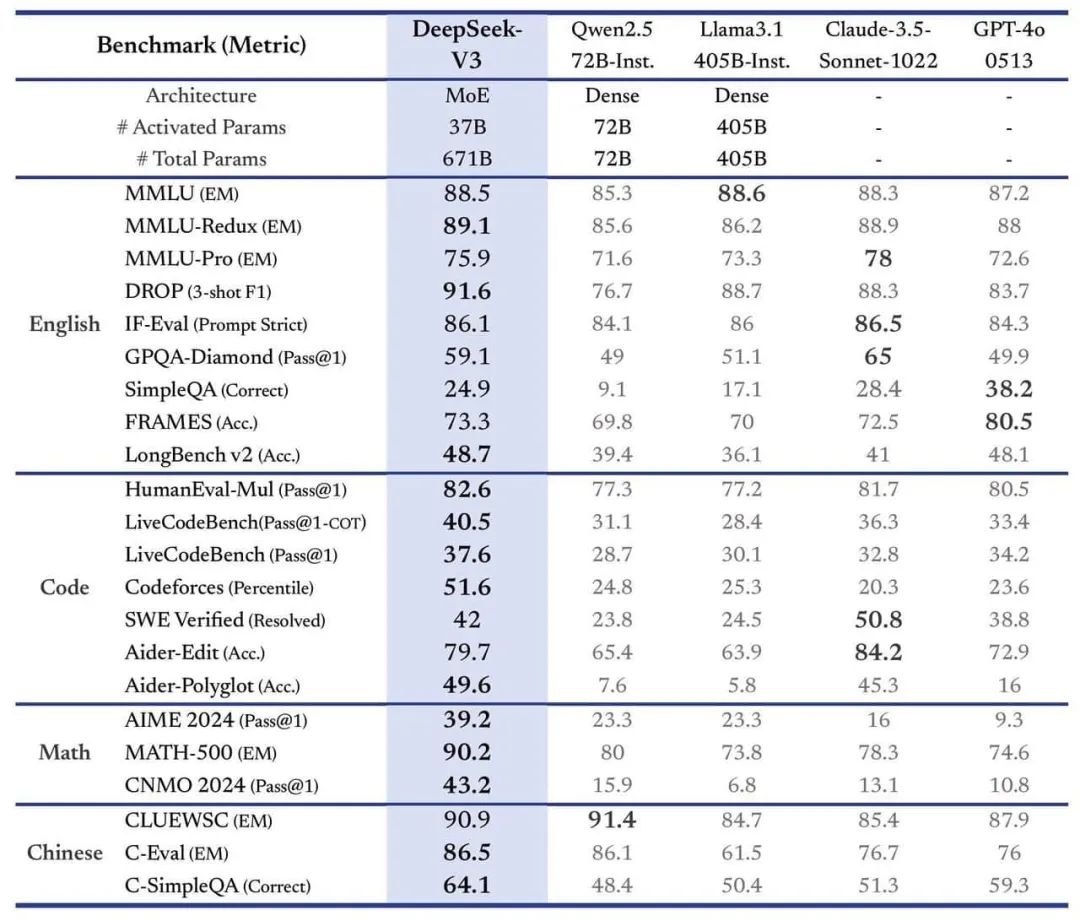

12月26日那个晚上非常不平凡,一件大事注定要被AI界写进里程碑。一夜之间,全球开源界最强模型不再是Llama了,而是中国开源界的新星DeepSeek最新研发的前沿模型V3,甚至可以比肩世界顶尖的闭源模型。根据DeeSeek披露的基准测试分数,简单来讲,八个字:开源最强,闭源比肩。DeepSeek-V3在众多其他闭源模型中脱颖而出,表现优于Meta的旗舰产品——拥有4050亿个参数的Llama 3

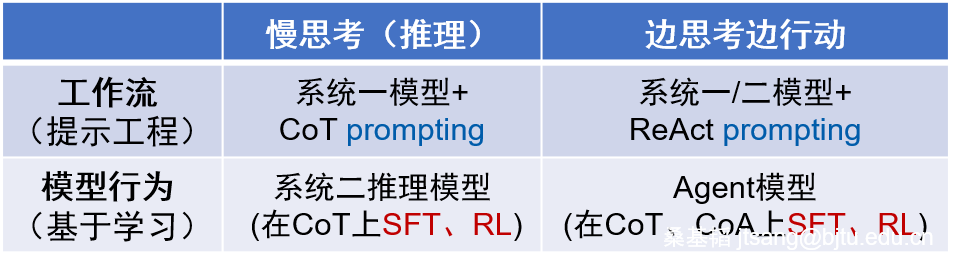

的Deep Research功能推出后,开源社区出现了很多复现工作。比较有代表性的Hugging Face官方的Open DeepResearch,通过代码规划行动步骤,实现了思考(thought)和行动(action)交互的ReAct工作流。它同时支持后台接入系统一模型(如DeepSeek-V3)和系统二推理模型(如DeepSeek-R1)。将之前总结的表格作更新。要注意的是,表中第一列的Per

本篇主要总结目前三种scaling law:Pre-train、RL、Test Time相关的内容。现在关于scaling law是否“撞墙”的讨论越来越多,Chinchilla Scaling Law推断,“即使没有新数据,也并不意味着模型效果提不上去了,很简单,只要增加基座模型尺寸,效果仍然会提高,只是从付出的算力和获得的效果提升来说很不合算,性价比过低”这也是为什么大家由Pre-train

文章系统介绍了AI Agent项目实践中Prompt设计的核心价值,详细讲解六种提示词设计方法(角色扮演、结构化模板、分步思维等)和五大主流框架(CRISPE、CARE、TAG、思维链等),同时提供实用技巧如具体大于抽象、温度值调整等。强调掌握提示词设计能力是最大化AI价值的关键,需要不断练习总结,才能让AI真正成为提升工作效率的强大工具。“最近做了一些AI Agent的项目实践,其实其中最重要的

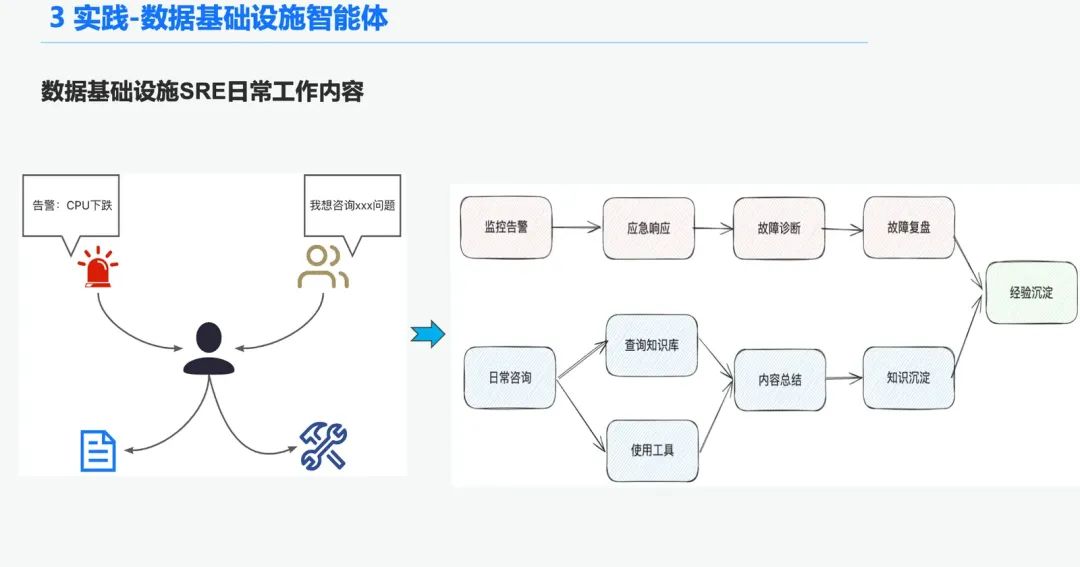

建议围绕各自领域构建属于自己的领域资产库包括,知识资产,工具资产以及知识图谱资产领域资产:领域资产包括了领域知识库,领域API,工具脚本,领域知识图谱。资产处理,整个资产数据链路涉及了领域资产加工,领域资产检索和领域资产评估。非结构化 -> 结构化:有条理地归类,正确地组织知识信息。提取更加丰富的语义信息。资产检索:希望是有层级,优先级的检索而并非单一的检索后置过滤很重要,最好能通过业务语义一些规