简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

有很多小伙伴不知道学习哪些鸿蒙开发技术?不知道需要重点掌握哪些鸿蒙应用开发知识点?而且学习时频繁踩坑,最终浪费大量时间。所以有一份实用的鸿蒙(HarmonyOS NEXT)资料用来跟着学习是非常有必要的。这份鸿蒙(HarmonyOS NEXT)资料包含了鸿蒙开发必掌握的核心知识要点,内容包含了。

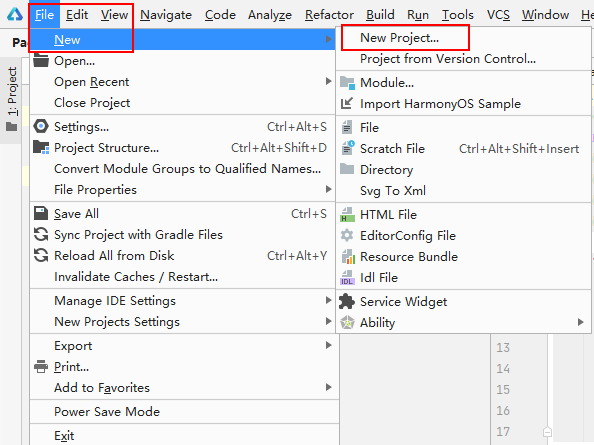

加载xml布局,打开entry -> src -> main -> java -> com -> liziba -> demo -> slice -> MainAbilitySlice,java文件,通过类的继承关系MainAbilitySlice **extends **AbilitySlice,可以看出MainAbilitySlice 是一个AbilitySlice的子类,而AbilitySl

媒体元数据主要用于媒体数据的存放和读取,包含诸如媒体资源的描述、创建日期、作者、封面图片等等。

有很多小伙伴不知道学习哪些鸿蒙开发技术?不知道需要重点掌握哪些鸿蒙应用开发知识点?而且学习时频繁踩坑,最终浪费大量时间。所以有一份实用的鸿蒙(HarmonyOS NEXT)资料用来跟着学习是非常有必要的。这份鸿蒙(HarmonyOS NEXT)资料包含了鸿蒙开发必掌握的核心知识要点,内容包含了。

新创建了一个专栏-生活,这个专栏咱们不讲技术,就给大家讲讲我的生活,讲讲什么TMD叫TMD生活。玩的就是真实,咱不整虚的。看这篇文章的开始可以先问问自己你觉得什么叫做生活?我很喜欢一句话:生活很简单,就是好好的活着。我心里的生活就是这样,简简单单的活,做好自己该做的,做自己喜欢的。不要被别人所干扰。接下来我讲讲我自己的生活。

第2,3,4,5只海豚采用了同样的方法,都是扔掉一只后,恰好可以分成5份,然后拿上自己的一份走了。已知ack函数对于m≥0和n≥0有定义: ack(0,n)=n+1、ack(m,0)=ack(m-1,1).ack(m,n)=ack(m-1,ack(m,n-1))。输入10个整型元素和一个整数N,对数组进行从小到大排序,再数组中查找N然后删除它,不改变原有的次序,输出删除后的新数组,如果没找到就原样

图中标 ① 处是表扫描操作,注意先扫描的 b 表,也就是 left join 后面的表,然后进行过滤操作(图中标 ② 处),我们 sql 语句中是对 a 表进行的过滤,但是 Hive 也会自动对 b 表进行相同的过滤操作,这样可以减少关联的数据量。我们看到 Stage-5 是根,也就是最先执行 Stage-5,Stage-2 依赖 Stage-5,Stage-0 依赖 Stage-2。8.执行 h

示例:运行一个名称为nginx,副本数为3,标签为app=test,镜像为nginx:1.11,端口为80的容器实例。可以通过具体的资源名称来进行删除,使用这个删除资源,同时删除deployment和service资源。查看已经部署了的所有应用,可以看到容器,以及容器所用的镜像,标签等信息。查看服务的详细信息,显示了服务名称,类型,集群ip,端口,时间等信息。根据yaml文件删除对应的资源,但是y

对你有帮助,可以添加VX:vip204888 (备注大数据获取)**[外链图片转存中…(img-FruYvZAL-1712876298808)]