简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本篇简要介绍深度信念网络DBN,是一个不太常见的神经网络。一、DBN概述深度信念网络(Deep Belief Nets,DBN),既可用于非监督学习,类似于一个自编码机;也可以用于监督学习,作为分类器使用。从非监督学习来讲,其目的是尽可能地保留原始特征的特点,同时降低特征的维度。从监督学习来讲,提高分类的准确率。二者都是对特征进行学习的过程,即如何得到更好的特征表达。作为神经网络,DBN由若干神经

python中生成随机数主要使用random模块和numpy库中的random函数。前者主要用于生成随机数和实现序列中随机数和随机数列的挑选,后者用来生成a*b维的随机矩阵。一、random模块random模块中将近有7个函数都是可以用来生成随机数,列举如下:1. random.random()功能:随机生成一个[0, 1)的浮点数示例:import randomnumber = random.r

本篇简要介绍深度信念网络DBN,是一个不太常见的神经网络。一、DBN概述深度信念网络(Deep Belief Nets,DBN),既可用于非监督学习,类似于一个自编码机;也可以用于监督学习,作为分类器使用。从非监督学习来讲,其目的是尽可能地保留原始特征的特点,同时降低特征的维度。从监督学习来讲,提高分类的准确率。二者都是对特征进行学习的过程,即如何得到更好的特征表达。作为神经网络,DBN由若干神经

转载,原文地址:深度学习中过拟合、欠拟合问题及解决方案 - 早起的小虫子 - 博客园 (cnblogs.com)说的很细致,大家可以去看看。在深度学习的模型建立过程中,一般都是用已经产生的数据训练,然后使用训练得到的模型去拟合未来的数据,借此来预测一些东西。在机器学习和深度学习的训练过程中,经常会出现欠拟合和过拟合的现象。训练一开始,模型通常会欠拟合,所以会对模型进行优化,等训练到一定程度后,就需

好恭喜各位找到一篇宝藏博文。本系列篇解释RNN和LSTM的参数详解和训练过程,说的较为详细。这一篇1.0先写原理和参数解释。理解RNN的结构,注意结合参数理解时间序列展开,空间序列展开。一、从MLP和CNN引起总的来说,全连接神经网络或者说MLP的训练和结构是好理解的。一个一维长度为n的输入,中间过几个全连接层,都是一维若干的长度,输出为几分类就是多少维的向量,节点到节点的参数构成weight矩阵

LSTM是RNN的升级版,加了门控装置,解决了长时记忆依赖的问题。但由于门控装置复杂,带来了计算量增加,所以引进了简化版的LSTM,即GRU。本文介绍GRU的基本原理,并将其与LSTM和RNN进行对比,分析它们各自的优劣。重点理解LSTM中h(t)和C(t)的本质,以及为什么门机制可以解决梯度问题,并且简化计算。目录一、从传统RNN说起二、改进的RNN:LSTM三、简化版的LSTM:GRU四、LS

本篇简要介绍深度信念网络DBN,是一个不太常见的神经网络。一、DBN概述深度信念网络(Deep Belief Nets,DBN),既可用于非监督学习,类似于一个自编码机;也可以用于监督学习,作为分类器使用。从非监督学习来讲,其目的是尽可能地保留原始特征的特点,同时降低特征的维度。从监督学习来讲,提高分类的准确率。二者都是对特征进行学习的过程,即如何得到更好的特征表达。作为神经网络,DBN由若干神经

以前一直知道神经网络划分数据集时要分为训练集,测试集和验证集,但不知道并且一般以6:2:2的比例划分,到头来不知道这三者各是啥,以及他们的作用是什么。本片文档解释一下三者的作用。重点在于验证集和测试集的区别以及用处。1. 三者的功能简述在机器学习中,我们的模型一般包括以下几点:(1)模型设计;(2)模型架构(模型多少层,每层神经元个数);(3)神经元内置参数;(4)模型训练的参数:超参数(模型外置

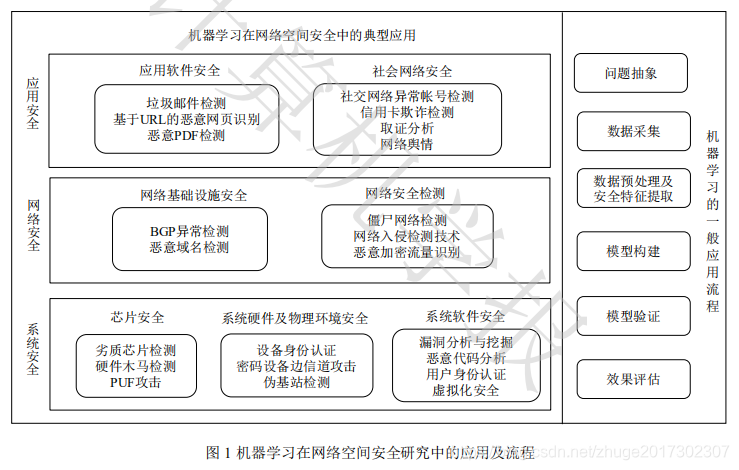

本文为清华大学计算机系团队于2017年发表于计算机学报的一篇文章,作者为张蕾,崔勇,刘静,江勇和吴建平。摘要文章首先阐述机器学习技术在网络空间安全应用研究中的应用流程,然后从系统安全,网络安全和应用安全三个层面介绍了机器学习在网络空间安全领域中的解决方案,归纳了这些解决方案的安全特征及常用的机器学习算法,最后总结。一、引言(1)随着互联网,云计算,大数据等技术的迅猛发展,网络环境日益复杂,网络空间