简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章目录线性回归快速回忆逻辑回归中的正向传播与反向传播逻辑回归中的正向传播与反向传播-代码实战神经网络的正向传播与反向传播线性回归快速回忆在线性回归(y=ax+by=ax+by=ax+b)中,使用梯度下降时的公式为:a=a−ηdJdaa = a-\eta \frac{dJ}{da}a=a−ηdadJ通过求出代价函数 JJJ 对参数 aaa 的导数,来更新 aaa ,不断重复该过程,直到某次a值的

视频地址:https://speech.ee.ntu.edu.tw/~hylee/ml/2021-spring.php作业Github: https://github.com/ga642381/ML2021-Spring数据集汇总:

前言相关链接1. Introduction1. 1 Basic Idea of GAN1.2 GAN as structured learning1.3 Generator可以自己学吗?VAE(Variational Auto-encoder)2. CGAN, Conditional Generation by GAN2.1 discriminator的架构改进2.2 Stack GAN2.3 I

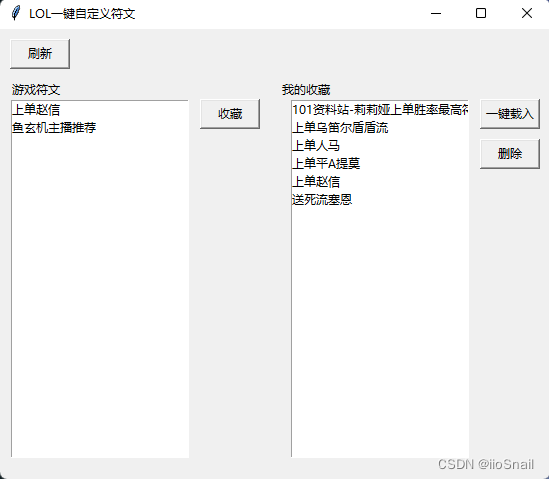

本文会介绍如何编写一个LOL一键载入自定义天赋。

文章目录线性回归快速回忆逻辑回归中的正向传播与反向传播逻辑回归中的正向传播与反向传播-代码实战神经网络的正向传播与反向传播线性回归快速回忆在线性回归(y=ax+by=ax+by=ax+b)中,使用梯度下降时的公式为:a=a−ηdJdaa = a-\eta \frac{dJ}{da}a=a−ηdadJ通过求出代价函数 JJJ 对参数 aaa 的导数,来更新 aaa ,不断重复该过程,直到某次a值的

逻辑回归的梯度下降公式逻辑回归的代价函数公式如下:J(θ)=−1m[∑i=1my(i)loghθ(x(i))+(1−y(i))log(1−hθ(x(i)))]J(\theta)=-\frac{1}{m}\left[\sum_{i=1}^{m} y^{(i)} \log h_{\theta}\left(x^{(i)}\right)+\left(1-y^{(i)}\right) \log \lef

1. Transformer各模块的逐行代码实现2. Transformer逐行代码的详细注释3. Transformer的训练和推理4. 利用Transformer进行德译中实战

说明该文章适用于之前学习过设计模式,但是基本忘了。使用该文章进行快速回忆。因为是应付面试(不是笔试),所以该文结合了自己的理解,使用大白话来解释各个模型,如有错误或不严谨的地方,欢迎在评论区指正。若之前没有学习过设计模式,可以将该文章死记硬背,然后应付面试。设计模式详细学习,可以参见 http://c.biancheng.net/view/1317.html名词解释设计模式:软件设计模式是对各种面

事件的关系与运算A−B=A−AB=AB‾B=A‾ ⟺ AB=∅ 且A∪B=Ω(1)吸收律 若A⊂B,则A∪B=B,AB=A(2)交换律 A∪B=B∪A,AB=BA(3)结合律 (A∪B)∪C=A∪(B∪C),(AB)C=A(BC)(4)分配律 A(B∪C)=AB∪AC,A∪BC=(A∪

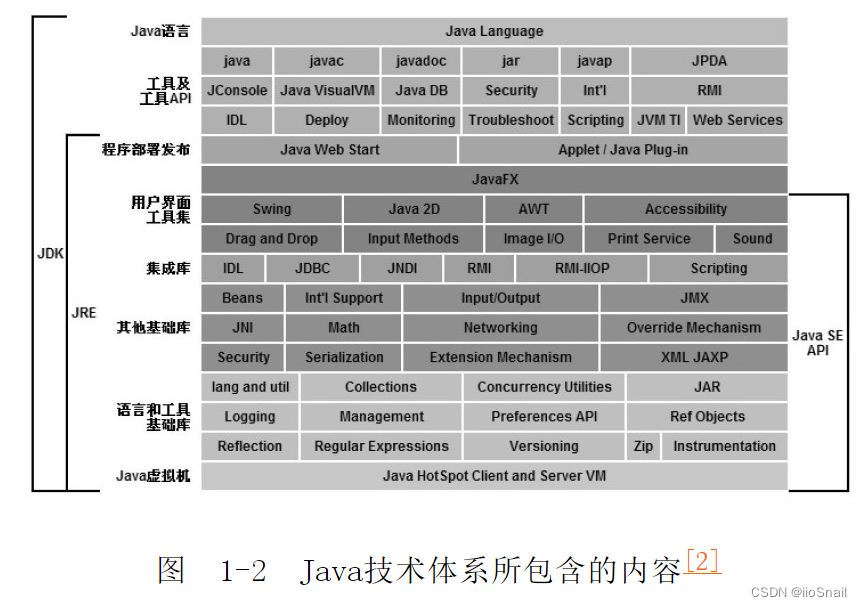

无重点学习Java虚拟机的重要原因:当出现内存泄漏时,知道怎么排查。学习垃圾收集(Garbage Collection, GC)的原因:可以帮助我们避免和解决OOM问题、由JVM引起的性能瓶颈等:调整Eden区和Survivor区的比值。默认为8:1:1。例如:我们经常要产生临时大对象时,可以将:直接晋级到老年代对象的大小。:设置CMS收集器GC时给用户留多少%的空间无重点无重点。