简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

CBAM(Convolutional Block Attention Module)是2018年被提出的,不同于ViT的Attention,CBAM是为CNN量身定做的Attention模块,实现简单、效果好,你值得拥有。

Cursor主要功能是根据用户的描述写代码或者进行对话,对话的范围仅限技术方面。优点是不用翻墙、不需要账号。Cursor基于GPT模型,具体什么版本不祥,有人说是GPT-4,但是官方没有证实,但这并不影响Cursor的强大。目前Cursor是免费的,但是偶尔会出现"Maximum Capacity",据我观察并不频繁;如果不想看见这个提示可以付费,每月20美金,具体怎么支付我就不介绍了,反正你也不

现在有很多开源的大模型,他们一般都是通用的,这就意味着这些开源大模型在特定任务上可能力不从心。为了适应我们的下游任务,就需要对预训练模型进行微调。全参数微调有两个问题:在新的数据集上训练,会破坏大模型原来的能力,使其泛化能力急剧下降;而且现在的模型参数动辄几十亿上百亿,要执行全参数微调的话,他贵啊!!于是LoRA出现了,LoRA(Low-Rank Adaptation)是微软提出的一种参数有效的微

tmp = cv2.cvtColor(crop_image, cv2.COLOR_BGR2GRAY)_, alpha = cv2.threshold(tmp, 0, 255, cv2.THRESH_BINARY)b, g, r = cv2.split(crop_image)rgba = [b, g, r, alpha]dst = cv2.merge(rgba, 4)# 注意保存成png格式!!!j

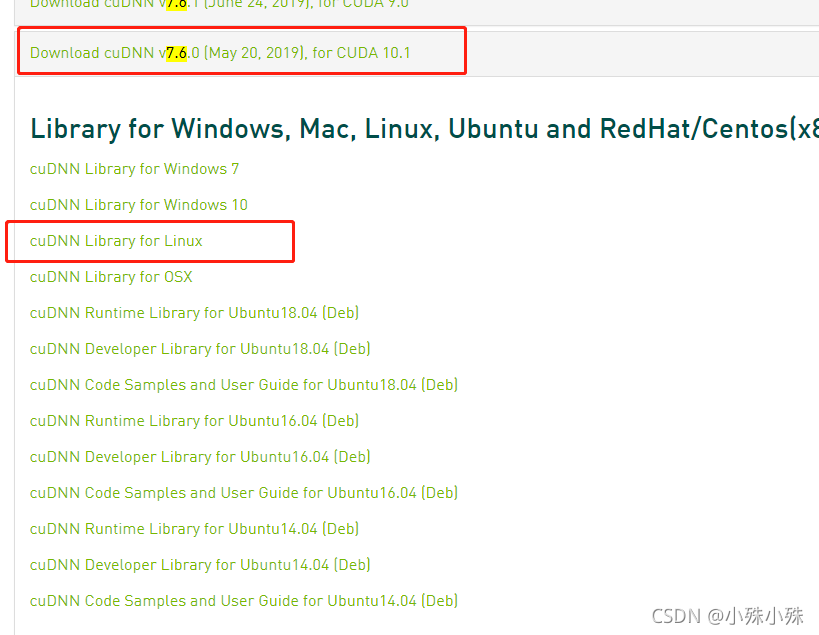

PaddleOCR需要一些配置,这里主要记录cuDNN的配置。亲测PaddleOCR需要cuDNNv7.x,CUDA11.0x。这里以cuDNN7.6为例1.下载:cuDNNv7.6cuDNN Archive | NVIDIA Developer 我的CUDA是11.0,但是使用cuDNNv7.6.0 for CUDA10.1也能用,很奇怪。2.解压,打开所在文件夹,将里面的东西拷贝到CUDA根目

cv2.estimateAffine2D是 OpenCV 库中的一个函数,用于估计两个二维点集之间的仿射变换矩阵。即第一个点集经仿射变换转换到第二个点集需要的操作,包括缩放、旋转和平移。

现在有很多开源的大模型,他们一般都是通用的,这就意味着这些开源大模型在特定任务上可能力不从心。为了适应我们的下游任务,就需要对预训练模型进行微调。全参数微调有两个问题:在新的数据集上训练,会破坏大模型原来的能力,使其泛化能力急剧下降;而且现在的模型参数动辄几十亿上百亿,要执行全参数微调的话,他贵啊!!于是LoRA出现了,LoRA(Low-Rank Adaptation)是微软提出的一种参数有效的微

Faiss(Facebook AI Similarity Search)是一个面向相似性搜索和聚类的开源库,专注于高维向量的快速相似性搜索。该库提供了一系列高效的算法和数据结构,可用于处理大规模高维向量数据,广泛应用于信息检索、机器学习和深度学习等领域。本文主要介绍Faiss中包含的量化器,量化器可以将高维向量映射到低维码本(codebook)以便进行快速近似最近邻搜索。当然在介绍量化器之前还有说

一、环境ubuntu 18.04.4 LTS二、卸载显卡驱动1.执行卸载sudo apt-get --purge remove nvidia*sudo apt autoremove2.如果也要卸载CUDA:sudo apt-get --purge remove "*cublas*" "cuda*"三、禁用 Nouveau 驱动在安装新的驱动时如果发生如下报错,则需要禁用Nouveau 驱动:ERR