简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

PyQt5 是Digia的⼀套Qt5应⽤框架与python的结合,同时⽀持2.x和3.x。本教程使⽤的是3.x。Qt库 由Riverbank Computing开发,是最强⼤的GUI库之⼀ ,官⽅⽹站www.riverbankcomputing.co.uk/news。

该文将介绍感知机A(perceptron)这一算法。感知机是由美国学者Frank Rosenblatt在1957年提出来的。为何我们现在还要学习这一很久以前就有的 算 法 呢 ? 因 为 感 知 机 也 是 作 为 神 经 网 络(深 度 学 习)的起源的算法 。 因此 ,学习感知机的构造也就是学习通向神经网络和深度学习的一种重要思想。该文我们将简单介绍一下感知机,并用感知机解决一些简单的问题。希

本篇文章将会讲解CART算法的实现和树的剪枝方法,通过测试不同的数据集,学习CART算法和树剪枝技术。

机器学习:机器学习常见的算法分类和算法优缺点汇总.机器学习实战教程(13篇)_M_Q_T的博客-CSDN博客这些网址非常适合想学习机器学习,却苦于没有项目(尤其缺少数据)的人。无意中看到,给自己做一个记录。

决策树是什么?决策树(decision tree)是一种基本的分类与回归方法。举个通俗易懂的例子,如下图所示的流程图就是一个决策树,长方形代表判断模块(decision block),椭圆形成代表终止模块(terminating block),表示已经得出结论,可以终止运行。从判断模块引出的左右箭头称作为分支(branch),它可以达到另一个判断模块或者终止模块。我们还可以这样理解,分类决策树模型

如何选择最优特征作为分类特征。本篇文章将在此基础上进行介绍。主要包括:决策树构建、决策树可视化、使用决策树进行分类预测、决策树的存储和读取、sklearn实战之预测隐形眼睛类型

本篇文章讲解线性回归的缩减方法,岭回归以及逐步线性回归,同时熟悉sklearn的岭回归使用方法,对乐高玩具套件的二手价格做出预测。

Python 机器学习 数据归一化

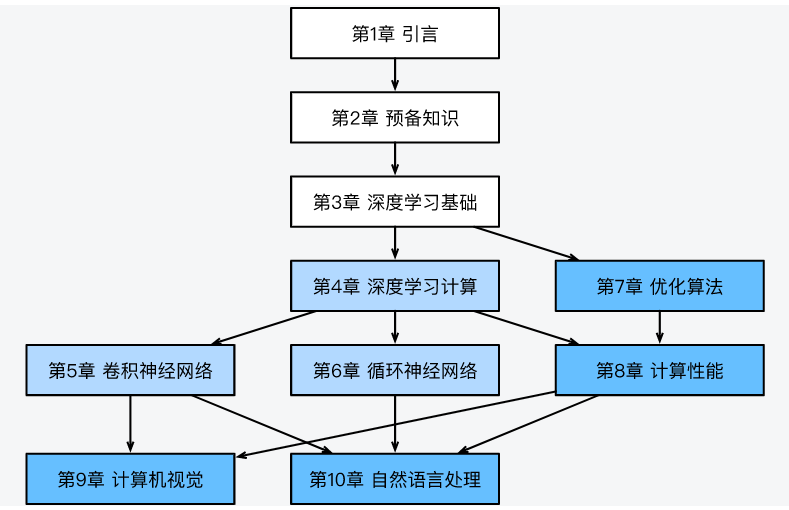

一篇文章搞定《动手学深度学习》-(李沐)PyTorch版本的所有内容

《动手学深度学习》PyTorch版本和TendorFlow版本(内有所有代码和PDF版下载地址)