简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

ChatGPT 现在可以思考行动,主动选择工具,用自己的虚拟计算机为你完成任务。

三年前,我们发布了这份榜单的第一版,目标很简单:找出哪些生成式 AI 产品真正被主流消费者使用。在当时,「AI 原生」公司和其他公司之间的界限很清晰。ChatGPT、Midjourney 和 Character.AI 都是围绕基础模型从零构建的产品,而软件行业的其他玩家还在摸索这项技术该怎么用。

截至2025年底,全国累计748款生成式AI服务完成备案,上海以137款大模型备案量位居全国城市第一。这些备案模型涵盖多个应用领域,从视频生成到科研助手,从教育到客服服务,为AI开发者提供了丰富的技术资源和应用参考,推动人工智能技术落地与创新发展。

1. 首次系统性地定义和综述了基于大语言模型增强的强化学习这一新兴领域,提出了完整的概念分类框架。2. 基于智能体-环境交互范式,将大语言模型在强化学习中的作用分为信息处理器、奖励设计器、决策者和生成器四类,并详细分析了每种角色的方法、优势和挑战。

推理是智能的核心能力,它支撑着逻辑推断、问题解决和决策制定等高级认知过程。尽管大语言模型(LLMs)在数学和代码等封闭领域的标准基准测试中展现出强大的推理能力,但在开放式和动态环境中,它们仍然面临诸多挑战。**智能体推理**(Agentic Reasoning)的出现标志着一个范式转变,它将大语言模型从简单的序列生成器重新定义为能够规划、行动并通过持续交互学习的自主推理智能体。

2026年,AI Agent 正在从实验室走向生产。但把一个能跑通 demo 的 Agent 变成一个可靠的产品,中间隔着一整套工程体系。这篇文章面向中国开发者,结合国内实际的技术生态和工具链,梳理 Agent 工程师需要掌握的核心开发技术——不求精通每一项,但求在做架构决策时不掉链子。

在企业级实际开发中,单纯的大模型调用远远不够——比如复杂的提示词工程、多数据源上下文整合、大模型与业务系统的深度联动、向量数据库适配等场景,Spring AI的封装就显得不够灵活。

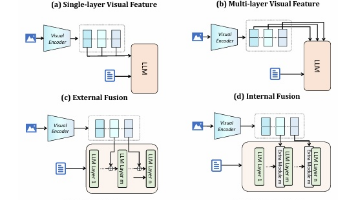

当前多模态大语言模型(MLLMs)在视觉-语言任务中快速发展,但**视觉信息通常仅来自视觉编码器的单一层**,这在复杂推理、跨语言理解、细节感知与一致性判断等任务中存在明显瓶颈。尤其在视频、OCR、多阶段推理等场景中,单层视觉特征难以同时覆盖低层细节与高层语义。

当下的 AI 领域正在经历一场深刻的分化。大多数开发者仍在构建"玩具级"应用——那些基于 GPT API 的薄层封装,而市场真正需要的是能够处理生产级复杂性的系统架构师。

随着技术的进步、业务需求的快速增长,一个运维人员通常要管理上百、上千台服务器,运维工作也变得重复、繁杂。将运维工作自动化,能够把运维人员从服务器的管理时间中释放出来,让运维工作变得简单、快速、准确。换句话来讲,运维自动化是一组将静态的设备结构转化为根据IT服务需求动态弹性响应的策略,主要目的就是实现IT运维的质量,降低成本。