简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

需要将标签数据转换为张量,并调整形状以适应模型训练的要求,.float的作用在于如果原始标签是整数,那么需要显式转换为浮点数。原本y是那么多行,转换成张量后,就变成一维的了,一行多列。然后是DataLoader。验证和测试就不随机了。

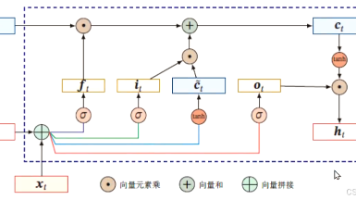

是一种改进的循环神经网络(RNN),专为解决传统RNN的(梯度消失/爆炸)而设计。其核心是通过动态控制信息的流动。

一开始conv1,第一层卷积层,去运算的时候,以前全连接的时候直接展平,现在是三维的,通道数是1(黑白照片),卷积的时候卷积核也是(1,3,3),但现在卷积核的尺寸实际上是立方体,虽然写的是2d,这是接口的这么一个设计,之所以是2d是因为在两个维度上进行移动(上下左右),不像以前的全连接是一维的必须展平。nn.MaxPool2d(2,2),前面一个2代表池化核大小是2*2,后面的2代表步长。池化一

1.常数:scaler:0阶张量——标量2.向量:vector:1阶张量3.矩阵:matrix:2阶张量4.三阶张量。

1 加载数据集fashion_minst2 搭建class NeuralNetwork模型3 设置损失函数,优化器4 编写评估函数5 编写训练函数6 开始训练7 绘制损失,准确率曲线。

普通的RNN信息不能长久传播,因为结尾较远的信息被稀释的比较厉害,所以引入LSTM,LSTM 是一种特殊的循环神经网络(RNN),专门设计用于解决传统RNN在处理与RNN相比,LSTM在计算隐藏层时,会包含当前时刻的日记信息。LSTM通过,显式控制信息的保留与遗忘,从而解决长期依赖问题。门机制是通过学习对原权重进行更新。遗忘门:决定细胞状态中哪些信息需要被丢弃(通过Sigmoid函数输出0~1之间

熵:信息增益:信息增益=信息熵-条件熵前者是初始信息熵大小,后者是因为条件加入后带来的确定性增加信息增益表示得知特征X的信息而使得类Y的信息的不确定性减少的程度信息增益越大说明影响越大。

self.rnn = nn.RNN(embedding_dim, hidden_dim, num_layers=num_layers, batch_first=True, bidirectional=bidirectional) #bidirectional是双向的#把final_hidden去除轴size为1的,和x进行比较,里边元素是否相等# 取最后一个时间步的输出 (这也是为什么要设置pad

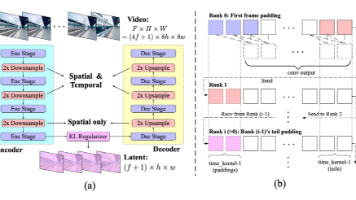

为了解决以前的视频生成模型经常与有限的运动和短暂的持续时间作斗争:1.引入了一个三维变分自编码器(VAE)来跨空间和时间维度压缩视频,提高压缩率和视频保真度2.为了改善文本-视频对齐,提出了一种具有专家自适应LayerNorm的专家转换器3.采用渐进式训练和多分辨率帧打包,实现生成具有不同形状和动态运动的连贯,长时间的视频。