简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

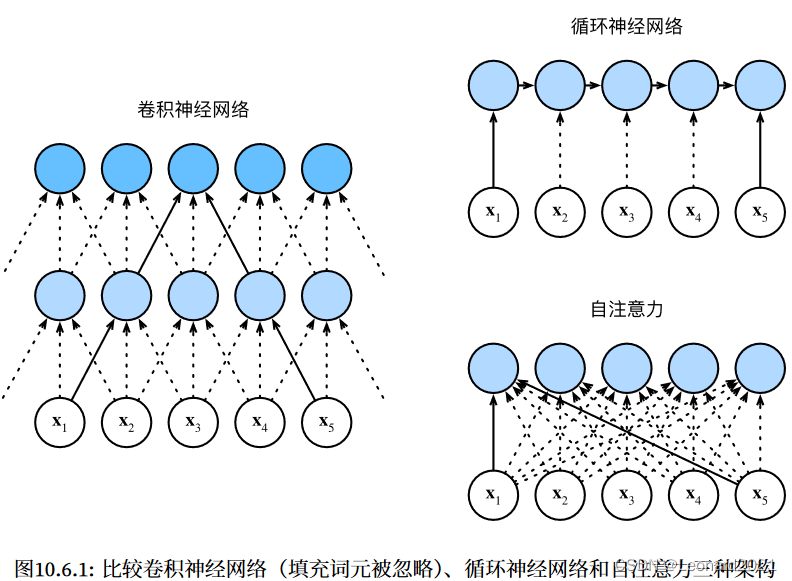

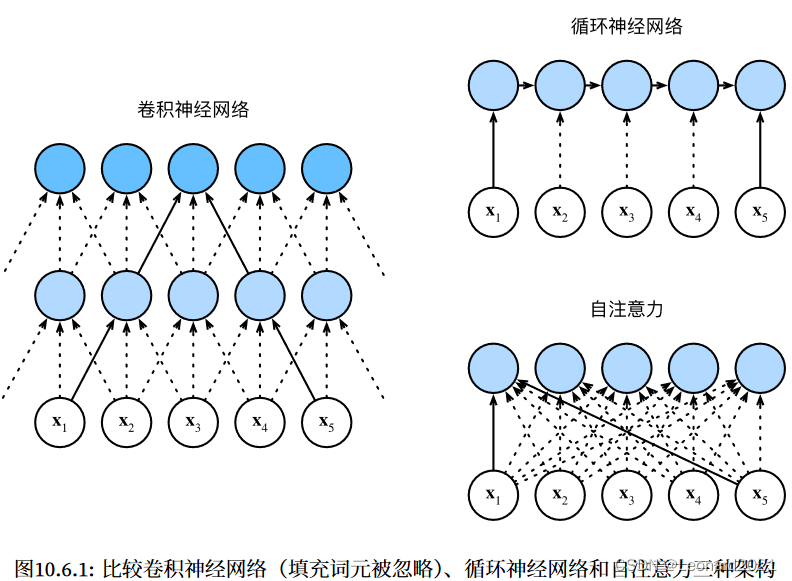

一、Vision Transformer介绍Transformer的核心是 “自注意力” 机制。论文地址:https://arxiv.org/pdf/2010.11929.pdf自注意力(self-attention)相比 卷积神经网络 和 循环神经网络 同时具有并行计算和最短的最大路径⻓度这两个优势。因此,使用自注意力来设计深度架构是很有吸引力的。对比之前仍然依赖循环神经网络实现输入表示的自注意

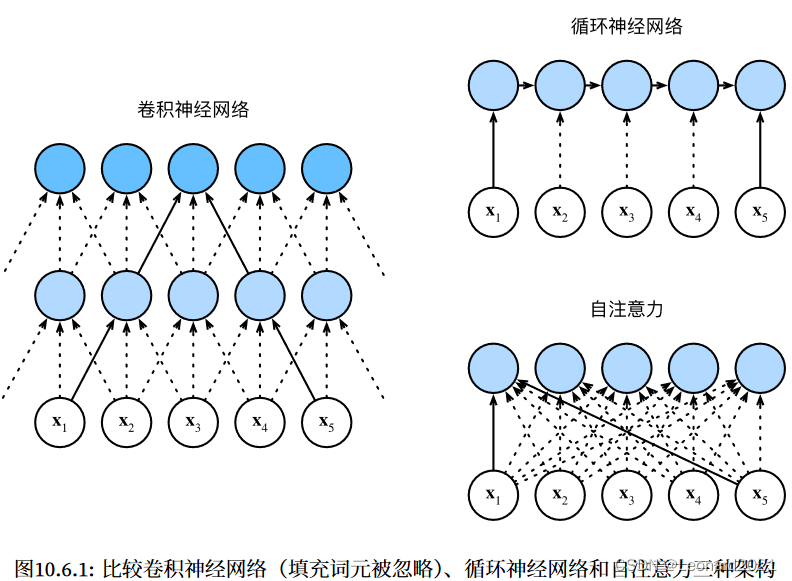

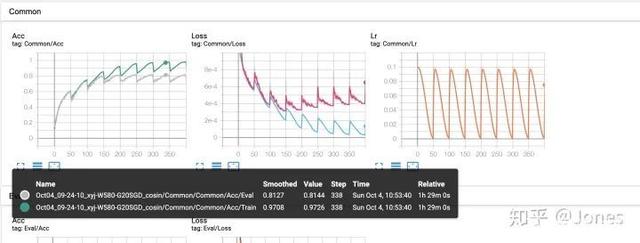

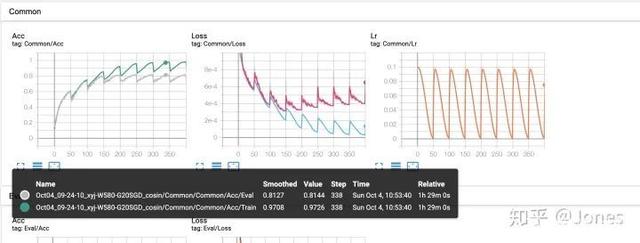

一、前言正当本人在纠结如何组合使用 优化器和学习率 调整方法时,看到了这篇文章,属实让我豁然开朗。口说无凭,实验数据比对更能说明问题。看似玄学,炼丹(训练)也有门路。膜拜大佬!二、正文本文作者模拟复现了自己在深度学习训练过程中可能遇到的多种情况,并尝试解决这些问题,文章围绕学习率、动量、学习率调整策略、L2正则、优化器展开。“深度模型是黑盒,而且本次并没有尝试超深和超宽的网络,所以结论只能提供一个

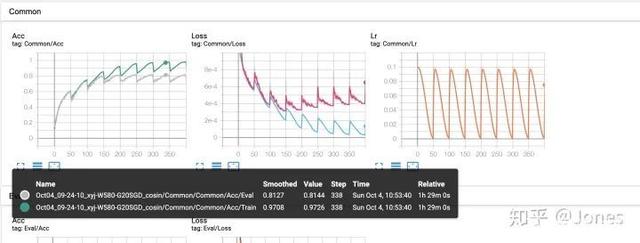

一、前言ECA-NET(CVPR 2020)简介:论文名:ECA-Net: Effificient Channel Attention for Deep Convolutional Neural Networks论文地址:https://arxiv.org/abs/1910.03151开源代码:https://github.com/BangguWu/ECANet作为一种轻量级的注意力机制,ECA-

一、前言正当本人在纠结如何组合使用 优化器和学习率 调整方法时,看到了这篇文章,属实让我豁然开朗。口说无凭,实验数据比对更能说明问题。看似玄学,炼丹(训练)也有门路。膜拜大佬!二、正文本文作者模拟复现了自己在深度学习训练过程中可能遇到的多种情况,并尝试解决这些问题,文章围绕学习率、动量、学习率调整策略、L2正则、优化器展开。“深度模型是黑盒,而且本次并没有尝试超深和超宽的网络,所以结论只能提供一个

一、前言正当本人在纠结如何组合使用 优化器和学习率 调整方法时,看到了这篇文章,属实让我豁然开朗。口说无凭,实验数据比对更能说明问题。看似玄学,炼丹(训练)也有门路。膜拜大佬!二、正文本文作者模拟复现了自己在深度学习训练过程中可能遇到的多种情况,并尝试解决这些问题,文章围绕学习率、动量、学习率调整策略、L2正则、优化器展开。“深度模型是黑盒,而且本次并没有尝试超深和超宽的网络,所以结论只能提供一个

一、环境的搭建1.tensorflow2.4和pytorch1.7环境的搭建参考:树莓派4B32位官方系统配置tensorflow2.4以及pytorch1.7_Leonard2021的博客-CSDN博客2.opencv4.5.3环境的搭建参考:树莓派32位官方系统配置opencv(whl)无需编译_Leonard2021的博客-CSDN博客3.其他python包的安装pip install pa

首先参考https://blog.csdn.net/dujuancao11/article/details/114002979这篇文章,把python的默认版本改为3.7然后利用WinSCP传输工具把相应的whl文件传输到树莓派的某个文件夹中,所需的whl文件在本人的上传资源中可以获取。首先,配置tensorflow2.4安装相关系统依赖sudo apt-get install -y libhdf

1. 安卓手机安装ip摄像头app下载地址:https://app.mi.com/details?id=com.shenyaocn.android.WebCam这是小米的下载地址,如果无法下载,则直接上网搜索“ip摄像头APP”就能得到2. 打开APP打开下方“打开IP摄像头服务器的”按钮点击下方“分享”按钮查看局域网的地址:例如我的局域网地址:局域网:http://192.168.1.103:8

一、Vision Transformer介绍Transformer的核心是 “自注意力” 机制。论文地址:https://arxiv.org/pdf/2010.11929.pdf自注意力(self-attention)相比 卷积神经网络 和 循环神经网络 同时具有并行计算和最短的最大路径⻓度这两个优势。因此,使用自注意力来设计深度架构是很有吸引力的。对比之前仍然依赖循环神经网络实现输入表示的自注意

一、Vision Transformer介绍Transformer的核心是 “自注意力” 机制。论文地址:https://arxiv.org/pdf/2010.11929.pdf自注意力(self-attention)相比 卷积神经网络 和 循环神经网络 同时具有并行计算和最短的最大路径⻓度这两个优势。因此,使用自注意力来设计深度架构是很有吸引力的。对比之前仍然依赖循环神经网络实现输入表示的自注意