简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

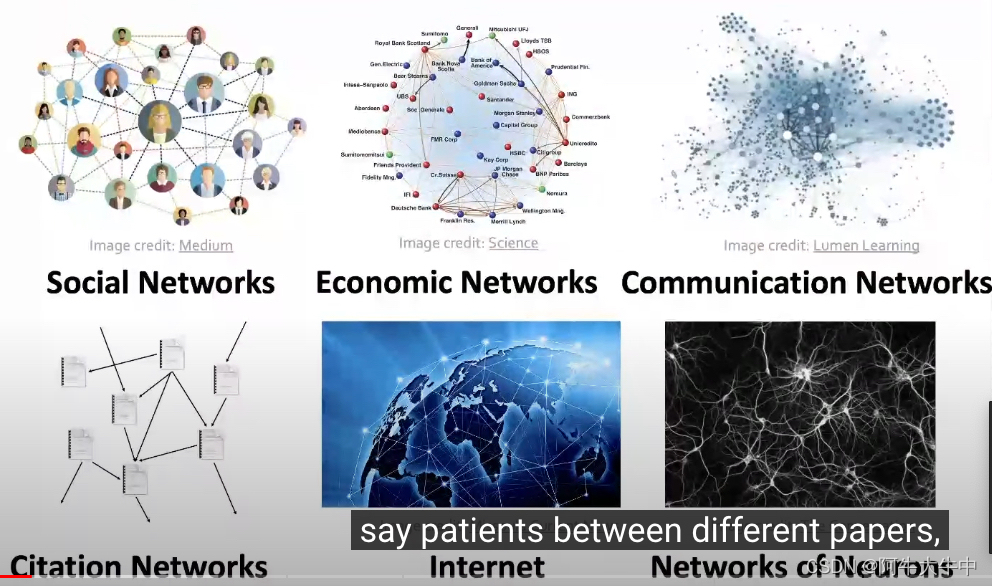

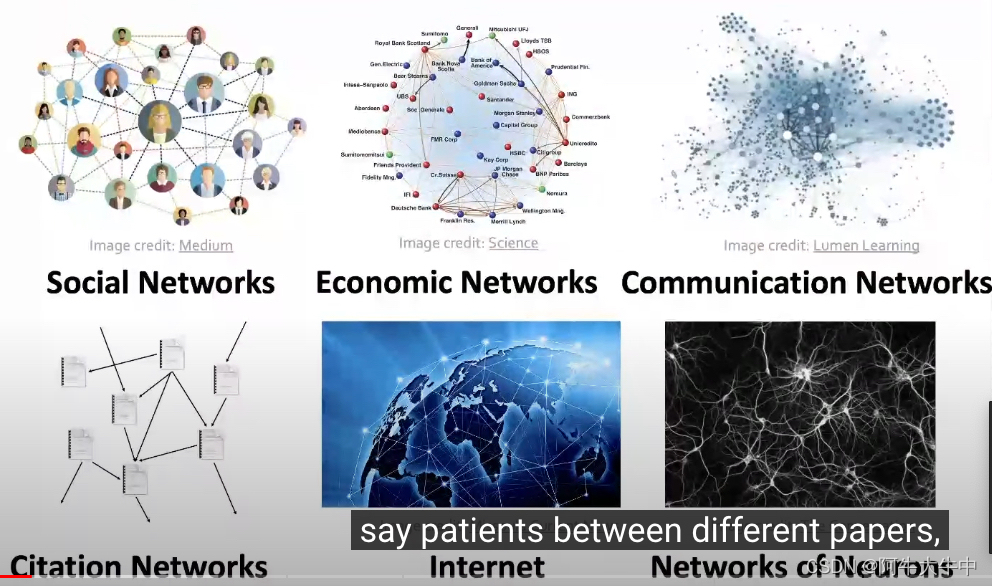

首先,介绍一下什么是图:简单来说,图是一种描述和分析实体之间关系的通用表达形式。图的种类也有很多,比如:事件图、计算机网络图、疾病传播图、食物链图、分子图、地铁路线图。社交网络图、金融图、沟通图、论文引用图、因特网、神经元网络。知识图谱、监管网络图、场景图、代码结构图、分子结构图、3D图形。

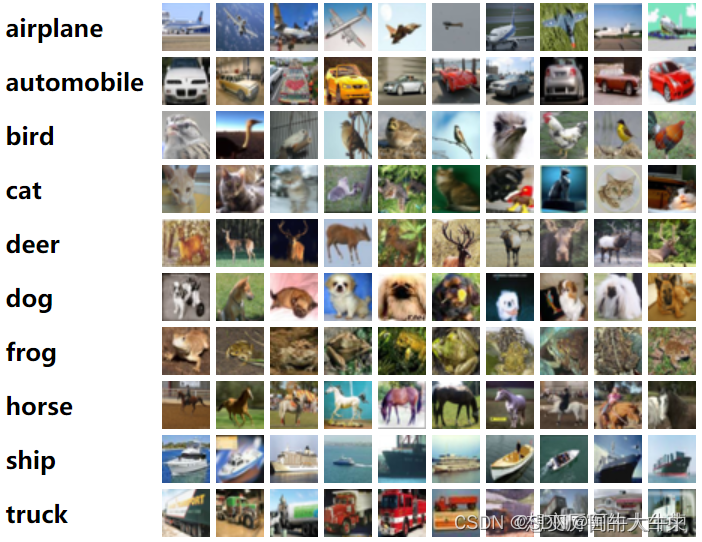

CIFAR-10数据集包含60000张32x32彩色图像,分为10个类,每类6000张。有50000张训练图片和10000张测试图片。数据集分为五个训练batches和一个测试batch,每个batch有10000张图像。测试batch包含从每个类中随机选择的1000个图像。训练batches以随机顺序包含剩余的图像,但有些训练batches可能包含一个类的图像多于另一个类的图像。在它们之间,训练

决策树是一种简单高效并且具有强解释性的模型,广泛应用于数据分析领域。其本质上是一颗自上而下的由多个判断节点组成的树。条件熵-conditional entropy。都压缩到[0,1]区间内。

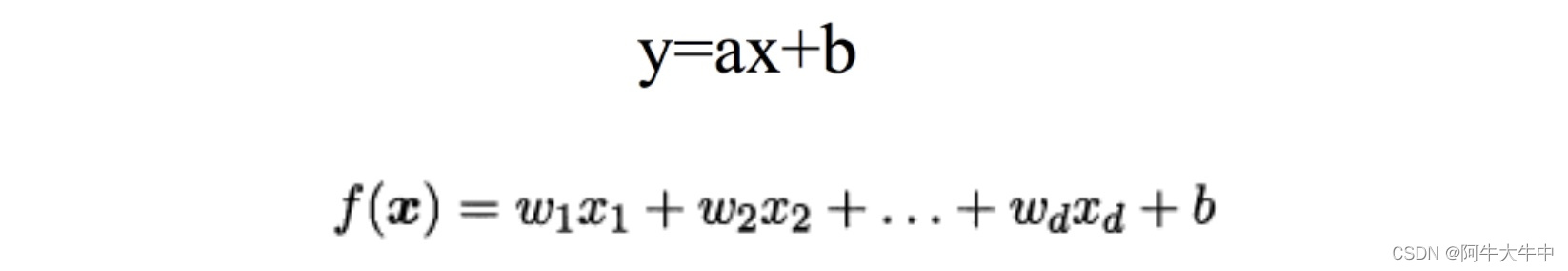

损失函数是系数的函数,另外还要传入数据的x,y def compute_cost(w , b , points) : total_cost = 0 M = len(points) # 逐点计算平方损失误差,然后求平均数 for i in range(M) : x = points [ i , 0 ] y = points [ i , 1 ] total_cost +=(y - w * x - b)

决策树是一种简单高效并且具有强解释性的模型,广泛应用于数据分析领域。其本质上是一颗自上而下的由多个判断节点组成的树。条件熵-conditional entropy。都压缩到[0,1]区间内。

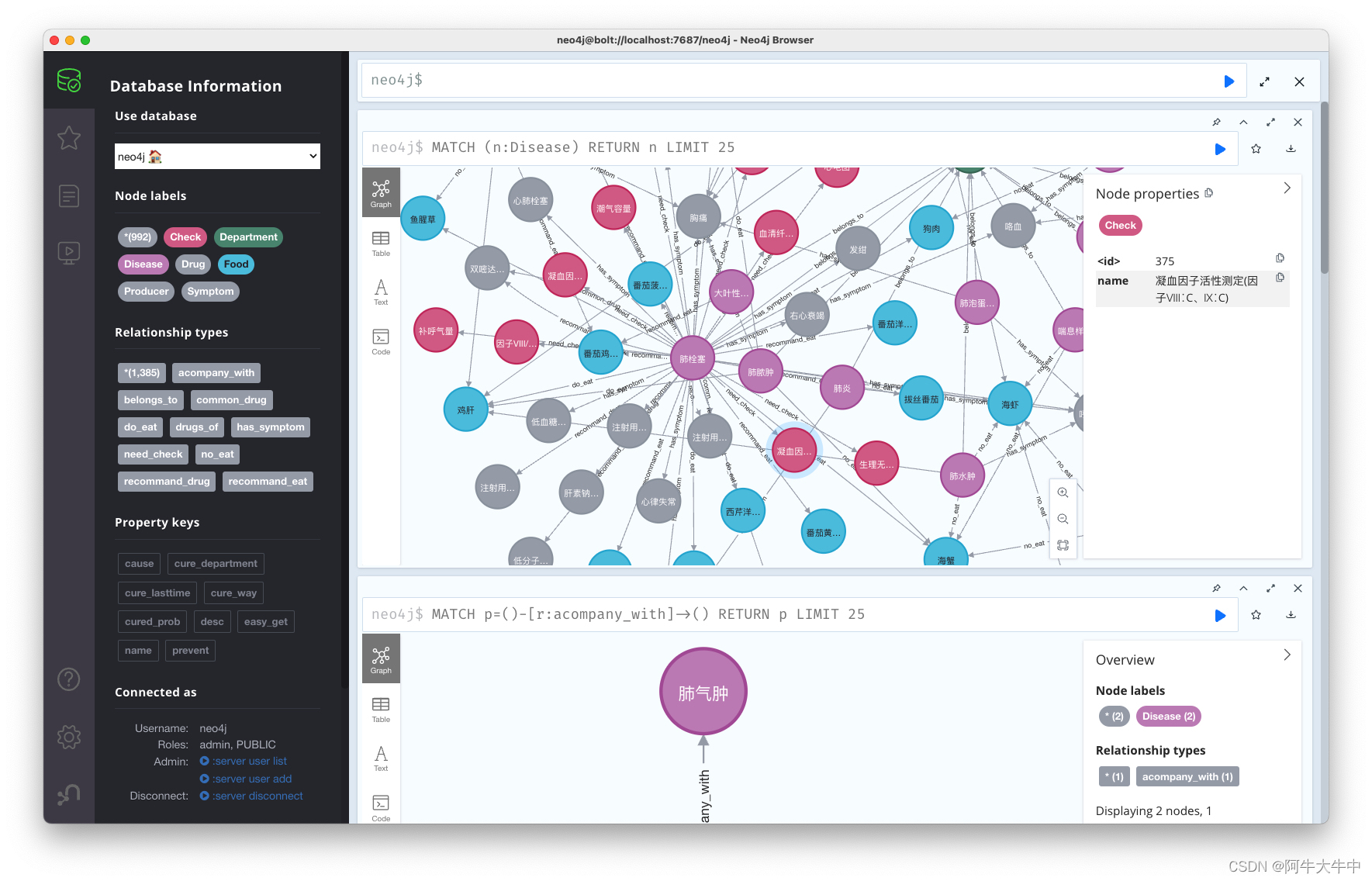

首先,执行build_medicalgraph.py文件,将数据导入Neo4j数据库中。该项目来自中国科学院,数据来源于网络,不过没有实现前端页面,只有后端的展示。之后执行chatbot_graph.py文件即可开启对话!这里设置的密码为:“12345678”

首先,介绍一下什么是图:简单来说,图是一种描述和分析实体之间关系的通用表达形式。图的种类也有很多,比如:事件图、计算机网络图、疾病传播图、食物链图、分子图、地铁路线图。社交网络图、金融图、沟通图、论文引用图、因特网、神经元网络。知识图谱、监管网络图、场景图、代码结构图、分子结构图、3D图形。

文章目录面向对象封装案例目标1. 封装2. 小明爱跑步2.1 小明爱跑步扩展 —— 小美也爱跑步3. 摆放家具3.1 创建家具3.2 创建房间3.3 添加家具3.4 小结面向对象封装案例目标封装小明爱跑步存放家具1. 封装封装 是面向对象编程的一大特点面向对象编程的 第一步 —— 将 属性 和 方法 封装 到一个抽象的 类 中外界 使用 类 创建 对象,然后 让对象调用方法对象方法的细节 都被 封

uni-app 封装request请求uni-app 封装接口request请求我们知道一个项目中对于前期架构的搭建工作对于后期的制作有多么重要,所以不管做什么项目我们拿到需求后一定要认真的分析一下,要和产品以及后台沟通好,其中尤为重要的一个环节莫过于封装接口请求了。因为前期封装好了,后面我们真的可以实现粘贴复制了。第一步、根目录下新建 config.js 文件const config = {ba