简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

过多无关信息会使模型处理上下文时更加困惑。尤其是低级模型,处理大量数据会表现衰减。模型本身对上下文长度有限制,无法一次加载过多信息。包含过多信息容易导致模型过拟合,处理新查询时效果较差。动态加载信息可以降低计算成本。允许模型主动决定何时需要更多信息,可以增强其推理能力。我们可以使用更智能的检索机制,而不仅是精确匹配,例如文本 Embedding 实现语义搜索。因此,合理设计提示链的信息提供策略,既

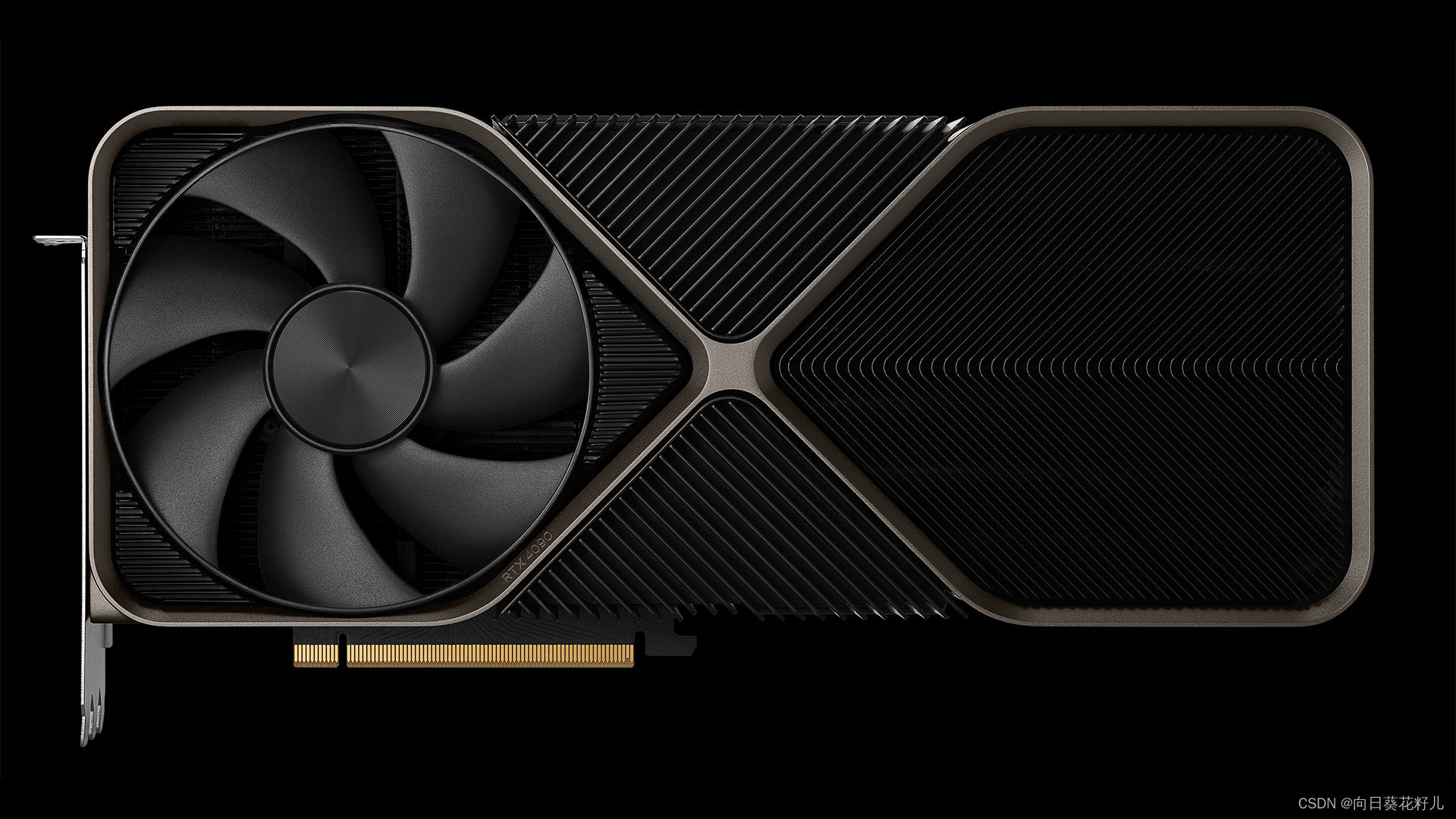

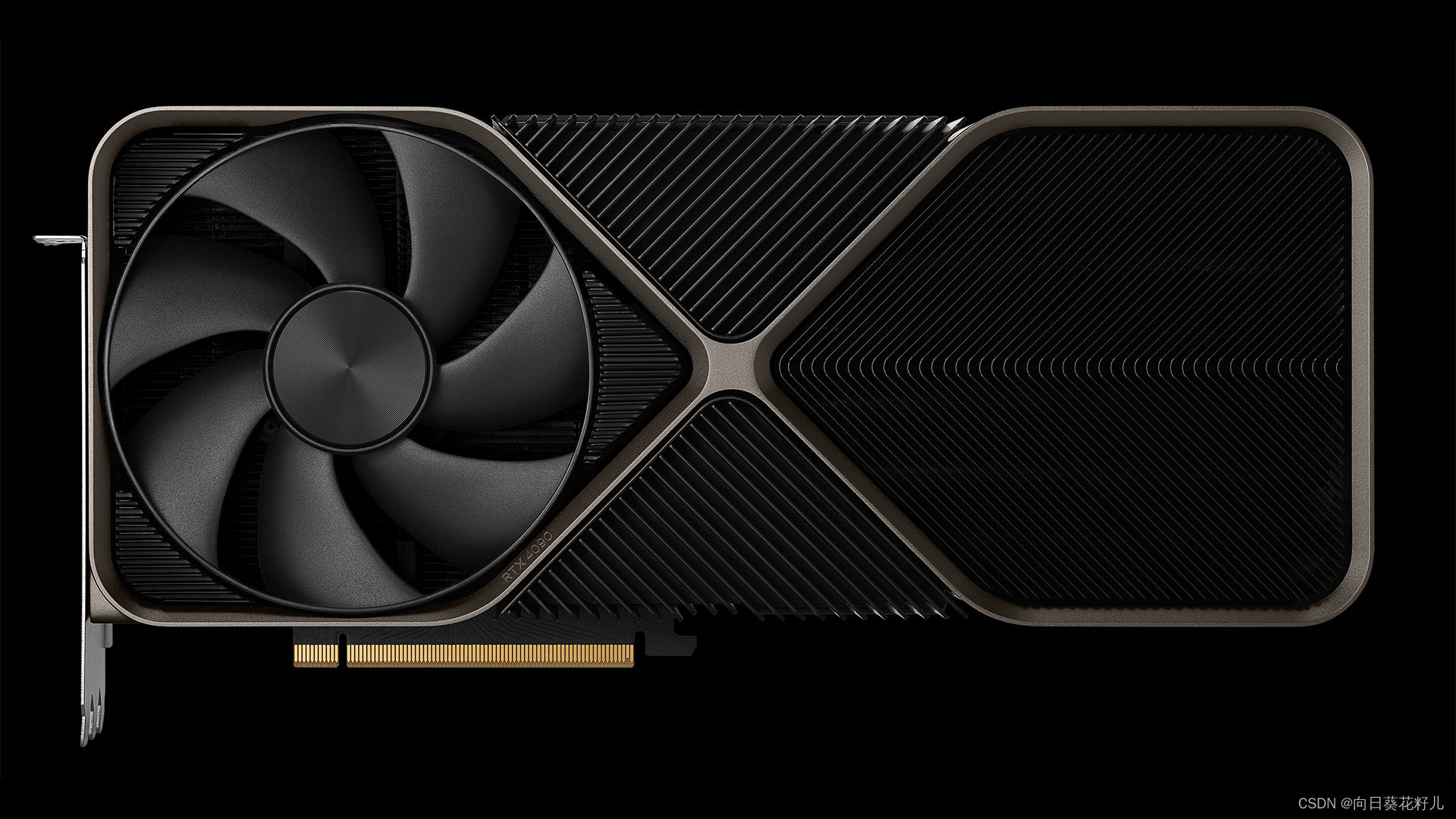

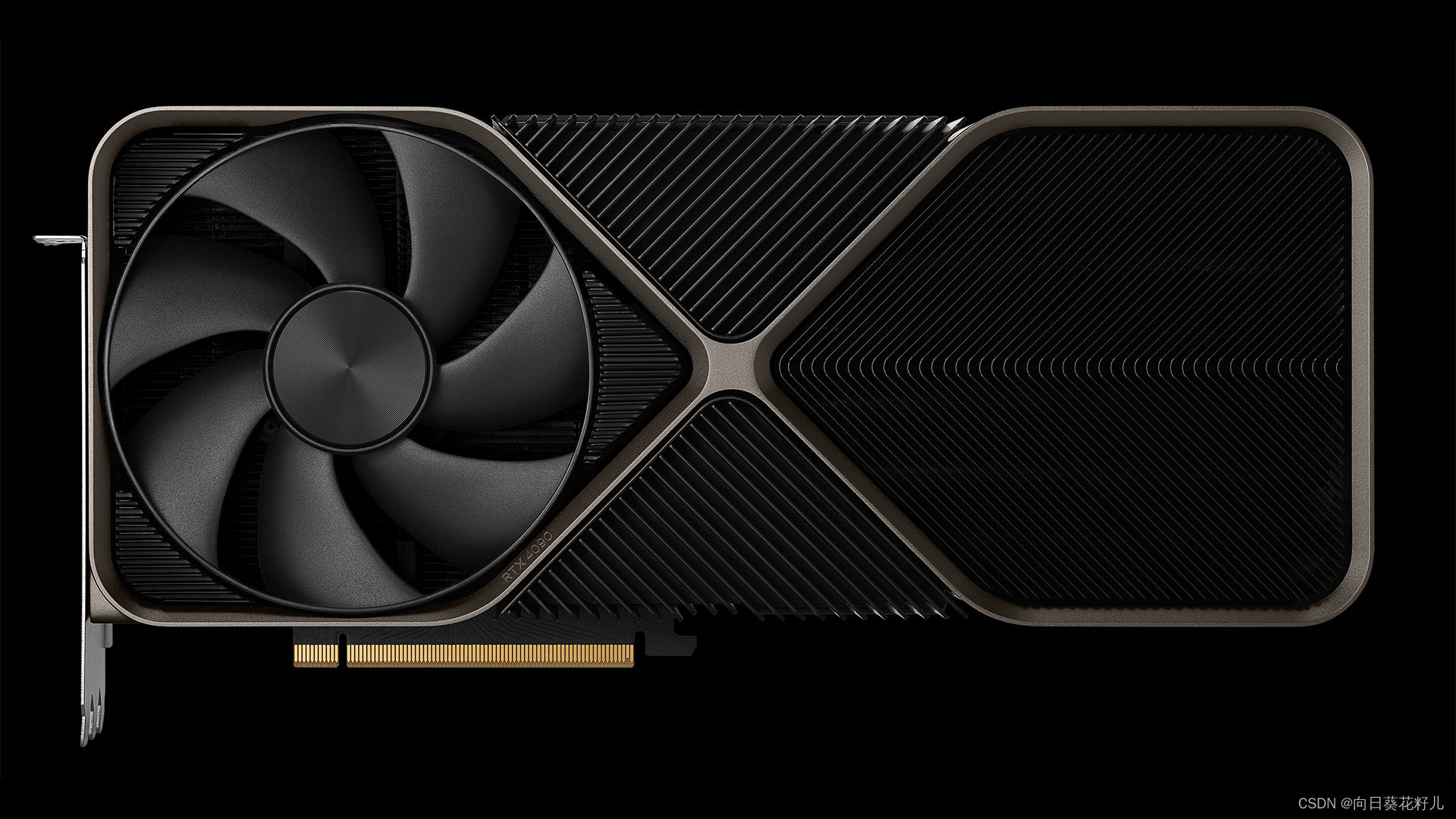

显存,也被称作帧缓存。独立显卡拥有独立显存,而集成显卡通常是没有的,需要占用部分主内存来达到缓存的目的是集成在主板上的,与主处理器共享系统内存。一般会在很多轻便薄型的笔记本与低端的台式电脑上得到广泛的应用性能较低,适合一般办公和基本图形任务。一块独立的图形处理器,有自己的显存,并且不与主处理器共享内存。独立显卡通常性能更强大,适合处理复杂的图形和游戏。在一些专业应用和高性能需求的场景中,独立显卡往

安装验证安装是否成功。

上一章讨论了文档标准化加载,现在转向文档的细分,这虽简单却对后续工作有重大影响。

上一章讨论了文档标准化加载,现在转向文档的细分,这虽简单却对后续工作有重大影响。

显存,也被称作帧缓存。独立显卡拥有独立显存,而集成显卡通常是没有的,需要占用部分主内存来达到缓存的目的是集成在主板上的,与主处理器共享系统内存。一般会在很多轻便薄型的笔记本与低端的台式电脑上得到广泛的应用性能较低,适合一般办公和基本图形任务。一块独立的图形处理器,有自己的显存,并且不与主处理器共享内存。独立显卡通常性能更强大,适合处理复杂的图形和游戏。在一些专业应用和高性能需求的场景中,独立显卡往

显存,也被称作帧缓存。独立显卡拥有独立显存,而集成显卡通常是没有的,需要占用部分主内存来达到缓存的目的是集成在主板上的,与主处理器共享系统内存。一般会在很多轻便薄型的笔记本与低端的台式电脑上得到广泛的应用性能较低,适合一般办公和基本图形任务。一块独立的图形处理器,有自己的显存,并且不与主处理器共享内存。独立显卡通常性能更强大,适合处理复杂的图形和游戏。在一些专业应用和高性能需求的场景中,独立显卡往

一旦文档被加载,它会被存储在名为pages的变量里。在第二部分,我们利用LangChain加载器从YouTube视频链接下载音频到本地,并用OpenAIWhisperPaser解析器将音频转换为文本。在page变量中,每一个元素都代表一个文档,它们的数据类型是langchain.schema.Document。首先,我们将构建一个 GenericLoader 实例来对 Youtube 视频的下载到

*安装 Rust 编译器:**根据提示,你可以尝试安装 Rust 编译器。你可以从 Rust 官网(https://rust-lang.org)下载并安装 Rust。**尝试安装预编译的轮子:**如果你不想安装 Rust 编译器,也可以尝试安装预编译的轮子。你可以在 PyPI 网站上找到适合你系统和 Python 版本的预编译轮子,并手动安装。*更新 pip:**你也可以尝试升级 pip 到最新版

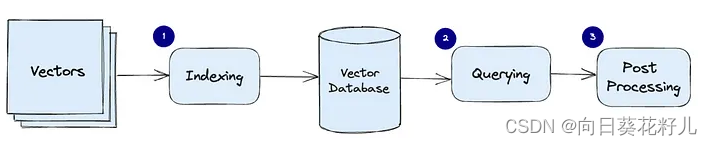

在构建RAG这类基于LLM的应用程序中,分块(chunking)是将大块文本分解成小段的过程。当我们使用LLM embedding内容时,这是一项必要的技术,可以帮助我们优化从向量数据库被召回的内容的准确性。在本文中,我们将探讨它是否以及如何帮助提高RAG应用程序的效率和准确性。在向量数据库(如:Pinecone)中索引的任何内容都需要首先Embedding。分块的主要原因是尽量减少我们Embed