简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文为[b站@bryanyzhu](https://space.bilibili.com/511378644)老师四期视频理解相关论文解读的汇总图文笔记。

深度学习自动编译和优化技术调研转自:https://moqi.com.cn/blog/deeplearning/作者:墨奇科技全栈开发在墨奇科技,我们需要将一些包含深度神经网络(DNN)的 AI 算法移植到边缘端的设备, 这些设备往往使用 ARM 架构的 CPU 和一些特殊的边缘端推理芯片(NPU)。这个时候,我们可以使用 NPU 产商提供的推理框架(例如瑞芯微的 rknn-toolkit)或 T

从头搭建一个深度学习框架转自:Build a Deep Learning Framework From Scratch代码:https://github.com/borgwang/tinynn当前深度学习框架越来越成熟,对于使用者而言封装程度越来越高,好处就是现在可以非常快速地将这些框架作为工具使用,用非常少的代码就可以进行实验,坏处就是可能背后地实现都被隐藏起来了。在这篇文章里笔者将带大家一起从

使用docker构建自己的机器学习开发环境

机器学习理论——优雅的模型:变分自编码器(VAE)

集合通信(Collective Communications)是一个进程组的所有进程都参与的全局通信操作,其最为基础的操作有 发送send、接收receive、复制copy、组内进程栅障同步Barrier以及节点间进程同步(signal +wait ),这几个最基本的操作经过组合构成了一组通信模板也叫通信原语,比如:1对多的广播broadcast、多对1的收集gather、多对多的收集all-ga

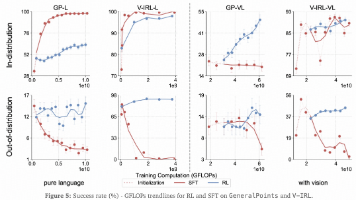

这篇文章是对 RL/SFT 泛化能力差异的一个早期研究。但是感觉所选的任务比较少,而且不太典型。

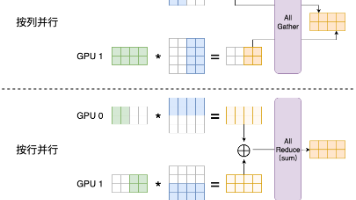

Tensor Parallel 是目前大模型训练和推理中最常用的并行方式之一,主要针对 Transformer 类模型。本文首先介绍了 GEMM 切分的按列并行和按行并行两种方式,然后在 Transformer 的各个组件,包括 MLP、Attention、input embedding、LM head + cross entropy loss 中根据实际情况设计具体的切分方案。

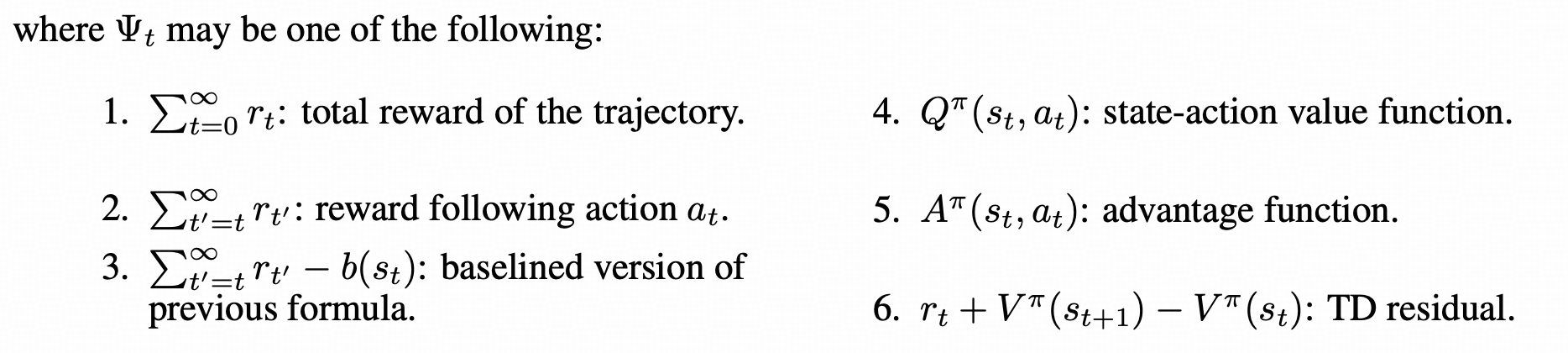

本文中,我们首先回顾了之前介绍过的基于累积回报的Ψt\Psi_tΨt选择,这类选择虽然是无偏的,但是由于需要多次采样,会造成累积方差很大。为了减小方差,我们考虑了基于价值函数的Ψt\Psi_tΨt选择,但是在价值网络估计的价值函数不准时,这类选择的偏差又比较大。GAE 提出了一种一般形式,将多项对优势函数的估计值进行加权表示,通过调节超参数λ\lambdaλ,实现了偏差和方差之间进行权衡,目前

仅从结构上来说,ViT 要支持任意分辨率、任意长宽比输入图像,只要位置编码是可外推的绝对位置编码就行了,现在来看比较常用的是苏神的 2D RoPE,Qwen 2/2.5 VL 中就采用了这种方式。NaViT 主要是将 NLP 训练中的 sequence packing 引入了过来,将多个长度不一的 token 序列放到一个 sequence 里,并对 self attention 进行 maski