简介

更多AI大模型应用开发学习知识,尽在聚客AI学院(https://edu.guangjuke.com/)

擅长的技术栈

可提供的服务

暂无可提供的服务

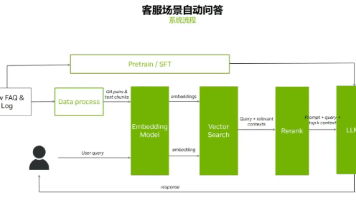

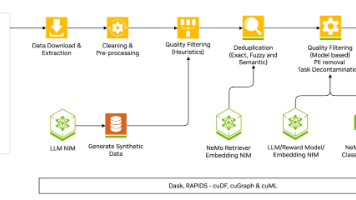

多模态RAG:融合文本/表格/图像检索自适应检索:基于用户反馈动态调整检索策略实时知识更新:流式数据处理管道

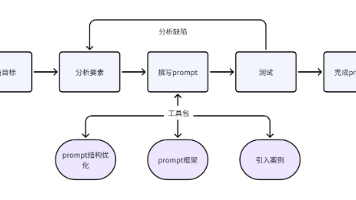

1.Prompt设计的基本原则2.简洁性与清晰度:如何设计简洁明了的Prompt3.上下文与语境的设计:如何为模型提供充分的上下文信息4.问题明确性:如何避免模糊不清的提示导致错误输出5.使用语言模型的指令:如何给模型传递清晰的指令以生成所需结果6.结构化与非结构化Prompt:适应不同任务的Prompt设计

本文介绍了AI大模型提示工程的核心技术与实践方案。主要内容包括:1)分层提示设计架构,展示上下文层、任务层和格式层的代码实现;2)动态上下文管理、多级文本摘要、思维链优化等核心技术;3)工业级优化体系,如自动化评估和强化学习优化器;4)工程化架构,包括混合提示管道和自适应引擎;5)可视化调试工具;6)企业级最佳实践。该方案可提升300%的工程效率,提高45%的输出质量。

本文系统解析了人工智能大模型的技术架构与行业发展。从训练层、推理层、市场洞察和基础设施层四个维度展开:训练层详细介绍了预训练、微调到强化学习的多阶段流程及资源优化;推理层重点分析了Prefill与Decode分离技术如何提升效率;市场层面指出技术趋同下的闭源与开源双轨竞争格局;基础设施层则揭示了GPU功耗激增带来的散热和供电挑战。文章强调未来大模型发展将更注重端到端能效优化,开发者需平衡算力成本与

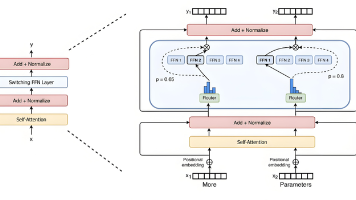

近年来,混合专家模型(Mixture of Experts, MoE)技术在大模型领域迅速崛起,成为解决计算效率和扩展性问题的关键创新。我将从核心原理、显著优势、落地应用以及当前挑战四个方面,全面解析MoE技术。内容力求深入浅出,并结合图文增强理解。现在,让我们一起揭开MoE的神秘面纱。

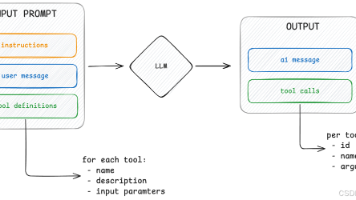

摘要:本文系统解析了模型上下文协议(MCP)与大模型工具调用的关系,指出MCP是开发者工具对接的标准化方案而非大模型需要理解的机制。文章强调大模型仅生成工具调用指令文本,实际执行由开发者程序完成;MCP通过统一接口简化工具集成,但不改变大模型的工作方式。核心观点是:MCP面向开发者效率提升,大模型无需感知MCP存在,只需按工具列表生成调用指令。全文通过工具调用流程拆解,阐明MCP与上下文工程的关系

在对大语言模型(LLM)进行微调时,有多种技术可选。今天我们分享一下最值得关注的 4 款工具 —— 从单卡 到支持万亿参数的分布式集群,它们几乎覆盖了所有 LLM 微调场景,让我们看看该在什么时候用哪一个。让你一文掌握主流框架特性、性能对比与实战选型策略

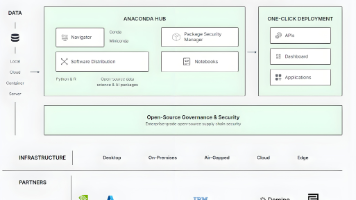

Python深度学习环境搭建: Anaconda/Miniconda、虚拟环境管理、Jupyter Notebook/Lab使用、GPU驱动安装(CUDA/cuDNN)

掌握文档分块、分词与向量嵌入技术,是构建高效NLP系统的关键基础。

技术价值开发效率提升:传统集成需1周的任务,MCP可缩短至数小时安全可控:企业可自主管理数据权限,避免敏感信息暴露生态共建:开源社区涌现MCP服务器市场(如mcpt、OpenTools),加速工具共享未来趋势多模态扩展:支持AR眼镜、脑机接口等新型设备接入端侧部署:DeepSeek-R1-Zero等轻量模型推动MCP在移动端落地。