简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

如果你哪天又被人问到:“MCP 和 LangChain 有啥区别?MCP = 通用插线板标准定义“大模型怎么跟工具说话”,偏“协议 / 接口”层。LangChain = 装修队 + 施工图帮你把模型、工具、数据、流程统统编排起来,偏“应用框架”层。只想让系统更“AI 友好”:先搞 MCP要造一个完整 AI 应用:用 LangChain / LangGraph 这类框架系统多、团队大、希望长期演进:

如果你哪天又被人问到:“MCP 和 LangChain 有啥区别?MCP = 通用插线板标准定义“大模型怎么跟工具说话”,偏“协议 / 接口”层。LangChain = 装修队 + 施工图帮你把模型、工具、数据、流程统统编排起来,偏“应用框架”层。只想让系统更“AI 友好”:先搞 MCP要造一个完整 AI 应用:用 LangChain / LangGraph 这类框架系统多、团队大、希望长期演进:

经过这次折腾,我算是彻底活明白了。如果是做垂直领域的信息查询千万别上来就搞微调!微调像是把孩子关起来背字典,背错了还容易瞎编(幻觉),字典更新了还得重新背。RAG像是允许孩子带字典进考场(开卷考试),哪里不会翻哪里,又快又准。想让AI学周杰伦说话的语气?你去微调。想让AI查周杰伦的资料?请老老实实选 RAG。简单粗暴的“翻书找答案”,才是最香的。

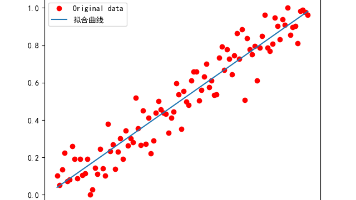

你可以把机器学习想象成一个擅长总结经验的助手。你给它一堆例子(比如很多张猫的照片),它就能慢慢学会“什么样的图像是猫”。然后即使你给它一张新照片,它也能判断是不是猫。一句话总结:机器学习是一种根据已有数据自动找出规律,并用于新数据预测的方法。机器学习虽然听起来很技术,但它本质上是在解决这样一个问题:给我一堆数据,我能不能从中找出规律,并用这个规律去预测未来的事情?每一个术语的背后,其实都是围绕这个

想象一下你是一个图书管理员,面对成千上万本书,你需要把它们放到正确的位置。比如历史书放A区,小说放B区,科普读物放C区。这个过程就是典型的“分类”。文本分类也是类似的概念:它是根据已有的类别标准,把一段文字自动分配到一个或多个预设的类别中。新闻网站把每篇报道打上“体育”、“财经”、“科技”等标签;客服系统自动识别用户留言是否属于“投诉”、“咨询”、“建议”;邮件系统判断一封邮件是不是垃圾邮件。有时

3、定义损失函数和优化器。

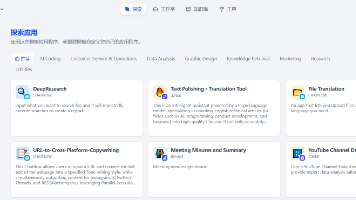

如果遇到docker无法启动,一般是wls未启动的问题。安装过程中注意一定要开启wls,等待安装完成,重启电脑即可。bcdedit 是否为auto,如果不是,设置为auto。注意,如果没有设置安装源,需要梯子,等待下载完成即可。安装没有报错,全部组件启动后,浏览器输入。进入dify的docker目录。配置初始化信息进入系统即可。

简单来说,随机森林就是一个“由很多棵小树组成的树林”。每棵树都根据一部分数据做出自己的判断,最后大家投票决定最终结果。比如你想判断一个人会不会买某样产品,你可以让100棵树各自看看不同的数据片段,然后每棵树都说说自己的判断。最后多数人怎么说,就作为最终结论。听起来是不是有点像“开会讨论”?没错,这就是它的核心思想——多个弱模型联合起来,形成一个强模型。

想象一下你是刚学做饭的新手,而你身边有一位米其林三星大厨。他做一道菜,你看着、记着、照着做,慢慢你也学会了怎么做出口感接近的菜。知识蒸馏就是这么个过程。“老师模型”:通常是一个效果很好但很重的大模型(如 BERT、GPT)“学生模型”:通常是一个轻量但表现一般的小模型(如 TinyBERT、DistilBERT)我们让小模型去“模仿”大模型的输出,从而学到它的“思维方式”,而不是仅仅去记住训练数据

你有没有遇到过这样的情况?这篇文章带你一步步搞清楚:我们将使用**公开数据集(Iris 和 Diabetes)**进行实战演示,并结合真实业务场景,让你不仅能“看懂”,还能“动手做”。在任何建模之前,最重要的一件事是:你想预测的到底是什么?我们来看两个常见公开数据集的例子:所以你可以问自己一句话:如果是类别标签 → 分类任务如果是连续数值 → 回归任务虽然都叫“机器学习模型”,但它们处理的任务完全