简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

提取码: qgh5 复制这段内容后打开百度网盘手机App,操作更方便哦。

方法 1:直接用-l参数循环刷新这里的1表示每,你可以改成其他秒数,比如-l 2就是每 2 秒刷新一次。按Ctrl + C可以退出。方法 2:结合watch命令这里的-n 1表示每nvidia-smi。

在使用这些工具时,需要根据具体的工具和数据库结构进行相应的操作。选项从文件中读取数据。选项执行SQL语句,并将结果输出到文件中。工具外,还可以使用其他工具进行数据的导入和导出,例如。选项执行SQL语句,或者使用。是包含数据的CSV文件。是包含数据的CSV文件。工具导入数据,可以使用。工具导出数据,可以使用。是要导入数据的表名,是要导出数据的表名,

COMPACT格式在尝试将数据存储在行内时更容易超出 8KB 的限制。DYNAMIC格式则通过将大字段存储在页外,避免了这一问题,从而不容易触发错误。COMPRESSED格式会压缩数据,适合节省磁盘空间,但可能会增加 CPU 负担,且对存储方式与DYNAMIC类似。解决办法: 直接将ROW_FORMAT = COMPACT改成ROW_FORMAT = DYNAMIC;

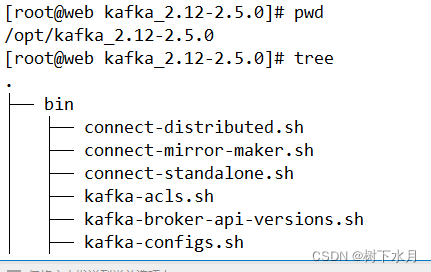

最近在搞Flink 框架 其中数据源需要模拟kafka取数据 ,于是自己搭建了一套单机的kafka环境,以便用于测试。现整理如下的笔记,发上来和大家分享。后续还会有kafka的相关笔记,会与大家继续分享!当前文档所部署服务器 IP地址为192.168.118.218hostname 为web一、 kafka环境搭建下载kafka很简单,可以使用源码的方式和安装包的方式安装。这里使用安装包的方式进行

今天使用composer的时候得到了这个错误:The openssl extension is required for SSL/TLS protection but is not available搜了一圈,基本都是说开启php.ini里的配置:extension=openssl# 同时,执行composer config -g --disable-tls true # 关闭Composer的T

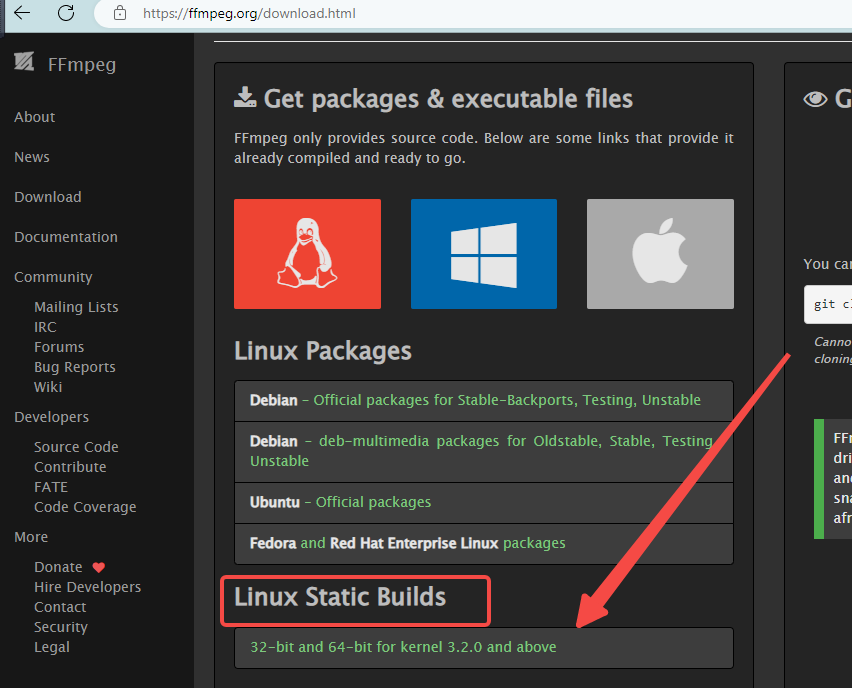

linux安装,找了半天各种技术文章,说最好编译安装,按照步骤安装编译环境编译成功了,但是使用的时候总要安装各种外部库,转码转不了等等问题......当然,如果想要ffmpeg命令全局可用,可以在bin目录加个链接。比如,分别执行如下命令,即可在/usr/bin目录下创建ffmpeg和ffprobe软链接。最后,删除/usr/local/bin/ffmpeg执行程序,你的可能不在这个地方,可以自己

COMPACT格式在尝试将数据存储在行内时更容易超出 8KB 的限制。DYNAMIC格式则通过将大字段存储在页外,避免了这一问题,从而不容易触发错误。COMPRESSED格式会压缩数据,适合节省磁盘空间,但可能会增加 CPU 负担,且对存储方式与DYNAMIC类似。解决办法: 直接将ROW_FORMAT = COMPACT改成ROW_FORMAT = DYNAMIC;

在使用这些工具时,需要根据具体的工具和数据库结构进行相应的操作。选项从文件中读取数据。选项执行SQL语句,并将结果输出到文件中。工具外,还可以使用其他工具进行数据的导入和导出,例如。选项执行SQL语句,或者使用。是包含数据的CSV文件。是包含数据的CSV文件。工具导入数据,可以使用。工具导出数据,可以使用。是要导入数据的表名,是要导出数据的表名,

在看php手册数组函数时,看到了一个高赞的用户回答传送门,利用array_search与array_column实现二维数组查找,不用自己写个循环,减少工作量。主要是在实际中 我们需要查找二维数组中,某个键值的值去查找返回所在的key 代码如下:<?php$userdb = array(0 => array('uid' => 100,'name' => 'Sandra Sh