简介

资深技术经理 & AI大模型全栈工程师 9年Java技术纵深 | 2年AI工程化落地 | 大型项目管理专家

擅长的技术栈

可提供的服务

大模型应用开发,大模型训练或微调,Agent 开发,软件研发

摘要:ClaudeSkills功能显著降低了AINative使用门槛,实现了按需加载机制,避免了重复输入指令的繁琐。Skills与MCP、Sub-agents的区别在于:MCP连接外部系统,Skills指导使用方法,Sub-agents独立完成任务。Skills优势在于低Token消耗和易用性,适合固定工作流程、团队协作和高Token消耗场景。作者与ClaudeCode合作撰写了82页白皮书,详细

本文详细介绍了LangChain框架及其在大模型应用开发中的核心功能。主要内容包括: LangChain概述:介绍1.0版本的重要更新,定位为连接大模型与外部组件的开发框架,支持Agent、RAG等应用开发。 核心组件: Model I/O:标准化模型输入输出,包含提示模板、模型调用和输出解析 Chains:通过LCEL表达式语言组合工作流 Retrieval:实现RAG流程,包括文档加载、切分、

摘要:HuggingFace的Transformers库是一个开源Python工具,提供BERT、GPT等预训练模型及NLP任务处理API,简化了模型加载和微调过程。Transformer模型则是2017年提出的基于自注意力机制的深度学习架构,相比RNN具有并行计算优势,已成为NLP领域的基础模型。两者的核心区别在于:Transformers是包含多种模型的工具库,而Transformer是具体的

这个域名自1993年注册以来,经历了多次跳转和归属传闻,但实际所有权信息并未完全公开。ai.com 跳转到 DeepSeek 官网了。

摘要:Logits是深度学习模型输出的原始分数,相比直接输出概率具有两大优势:1)数值稳定性,避免概率接近零时的计算问题;2)提供更丰富的梯度信号。在大语言模型生成文本时,Logits先为每个候选词计算分数,再通过Softmax转换为概率分布进行抽样。Logits作为"原始想法"(任意实数),经Softmax转化为概率(0-1区间),前者用于稳定训练,后者作为最终输出。这种设计

本文系统解析了PyTorch中常见的8种矩阵运算操作符(torch.dot、@、matmul等)的区别与应用场景。主要内容包括:1)点积的数学本质与几何意义;2)各操作符的输入输出形状规则与典型用法,重点对比了torch.dot、matmul、mv等函数的差异;3)批量矩阵乘法的形状推断技巧;4)NumPy与PyTorch在矩阵运算上的关键区别;5)大模型中的典型应用场景(如自注意力机制);6)性

本文介绍了SSH隧道技术在AI模型训练中的应用,主要解决两个问题:1)本地访问云平台非公网端口,如AutoDL上的自定义端口;2)实现Pycharm本地开发与远程GPU计算的无缝对接。文章详细演示了两种实现方式:图形化工具(Xterminal等)和命令行方法,并重点展示了通过SSH隧道实现本地Pycharm调用远程GPU进行模型训练的全过程,包括环境配置、数据同步、镜像设置等关键步骤,最终实现本地

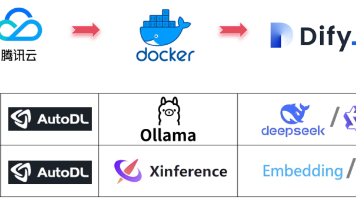

基于 Dify 实现 RAG、Agent “大模型应用落地”是目前企业落地 AI 场景最简单也是必须的路径,我将分两篇文章,从“原理->Dify 部署->模型私有化部署->Agent 搭建案例”完整演示一下实操过程。

基于 Dify 实现 RAG、Agent “大模型应用落地”是目前企业落地 AI 场景最简单也是必须的路径,我将分两篇文章,从“原理->Dify 部署->模型私有化部署->Agent 搭建案例”完整演示一下实操过程。

摘要:本文介绍了DeepSeek-V3大模型的本地部署方案。基于ChatBI项目中Text2SQL能力需求,选择DeepSeek-v3结合vLLM框架部署。详细说明了FP8(700GB+)、BF16(1400GB+)和int4(450GB+)三种精度下的显存需求及硬件配置(8块A100显卡)。部署流程包括从魔搭社区下载权重文件、安装依赖环境、代码调用以及vLLM框架配置。同时提供了多服务器场景下的