简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

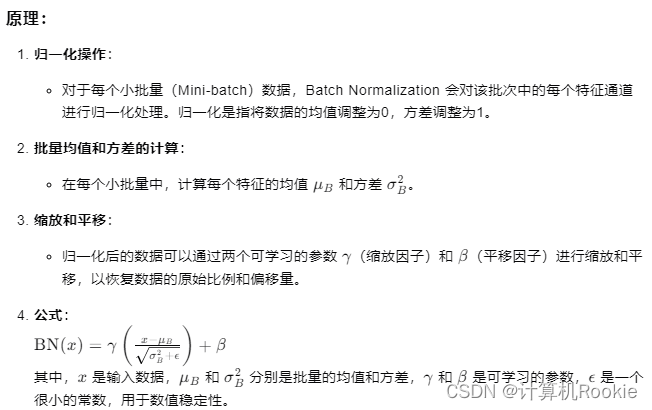

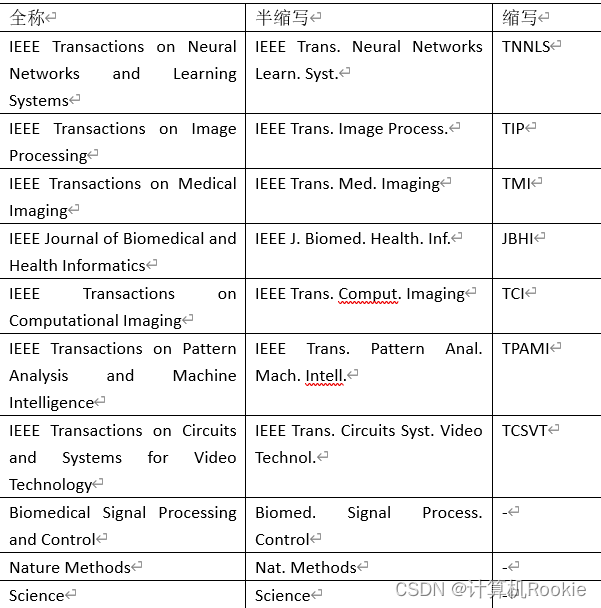

Adam优化算法(Adaptive Moment Estimation)是一种基于一阶和二阶矩估计的自适应学习率优化算法,广泛用于训练深度神经网络。在图像预处理和增强过程中,选择合适的技术对于提升模型的泛化能力至关重要。FPN(特征金字塔网络)是一种在深度学习中用于图像识别和目标检测任务的网络结构,主要用于解决多尺度目标检测问题,即在图像中同时检测不同尺寸的物体。在图像分割任务中,评估模型性能的指

Adam优化算法(Adaptive Moment Estimation)是一种基于一阶和二阶矩估计的自适应学习率优化算法,广泛用于训练深度神经网络。在图像预处理和增强过程中,选择合适的技术对于提升模型的泛化能力至关重要。FPN(特征金字塔网络)是一种在深度学习中用于图像识别和目标检测任务的网络结构,主要用于解决多尺度目标检测问题,即在图像中同时检测不同尺寸的物体。在图像分割任务中,评估模型性能的指

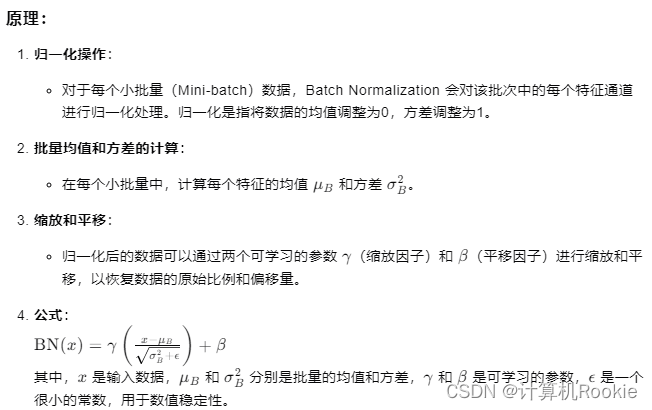

对于所有的相关经历,都是跟面试官聊技术(举例,提供参考方向)从数据规模、特征、指标、目前使用的模型方法、项目难点详细介绍。

Transformer 结构和 LSTM 的区别和优势,Transformer 怎么体现时序信息?Bert 用的什么位置编码,为什么要用正弦余弦来做位置编码?还知道其他哪些位置编码?Transformer Encoder 和 Decoder 的输入输出和结构。Attention 和 self-attention 有什么区别?为什么现在的大模型大多是 decoder-only 的架构?简单介绍一下

在进行某些比较**费时**的git操作时自动生成,操作结束后自动删除,相当于一个**锁定文件**,目的在于**防止对一个目录同时进行多个操作**。有时强制关闭进行中的git操作,这个文件没有被自动删除,之后你就无法进行其他操作,必须手动删除。

Transformer 结构和 LSTM 的区别和优势,Transformer 怎么体现时序信息?Bert 用的什么位置编码,为什么要用正弦余弦来做位置编码?还知道其他哪些位置编码?Transformer Encoder 和 Decoder 的输入输出和结构。Attention 和 self-attention 有什么区别?为什么现在的大模型大多是 decoder-only 的架构?简单介绍一下

在将已有项目提交到线上远程仓库时,报错[rejected] master -> master (fetch first) error: failed to push some refs

报错信息:报错原因:writer.add_scalar要加“S”

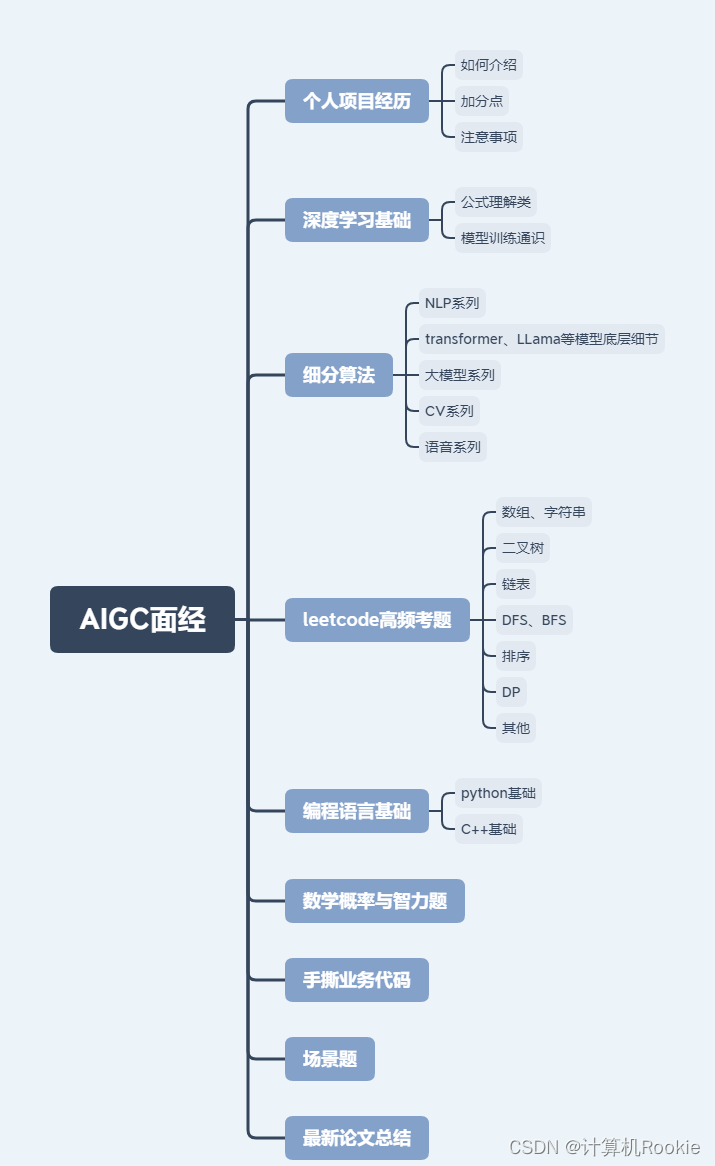

计算机常见期刊半缩写和缩写(投稿)

本教程内含YOLOv11网络结构图+训练教程+推理教程+数据集获取等有关的内容~