简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

如果这篇博客让你感到焦虑,那就对了。焦虑是学习的动力。去下载一个或Qwen2.5-7B。安装vLLM,尝试在本地部署它。阅读DPO的论文,并尝试用库跑通一个最小的对齐 Demo。只有动手写代码 (Write Code),你才能真正拥有它。(附注:文中提到的所有论文建议直接在 arXiv 搜索标题,工具库直接上 GitHub 搜索 Star 数最高的即可。2025年的技术,唯快不破。

2025年,不会用AI的人,就像2005年不会用电脑的人。你不需要懂Transformer,不需要会写代码——哪个工具能解决你的问题,怎么用它省时间、多赚钱、少加班。

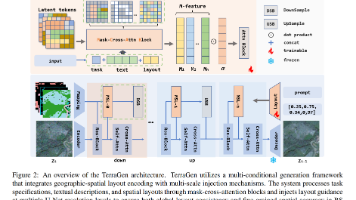

遥感视觉任务需要大量跨多个相互关联领域的标注数据。然而,当前的生成式数据增强框架通常是任务孤立的,即每个视觉任务都需要训练一个独立的生成模型,且忽略了对地理信息与空间约束的建模。为解决上述问题,我们提出了 TerraGen——一种统一的布局到图像生成框架,能够灵活、可控地合成适用于多种高层视觉任务(如目标检测、语义分割和要素提取)的遥感影像。

阿里巴巴推出的新一代超大规模语言模型,支持 32K 上下文、多语言交互、代码生成和逻辑推理,提供免费 API 调用额度(每日限流)。:科大讯飞推出的迭代版本,增强多语言翻译、逻辑推理与代码生成能力,支持教育、医疗等垂直场景。:OpenAI 最新多模态模型,支持文本、图像、音频交互,推理能力与生成速度显著提升。:Meta 开源的模型,支持商用免费,提供 8B 与 70B 参数版本,需自行部署。:腾讯

简单来说,模型蒸馏就是“以大带小”:用一个已经训练好的、性能强大的“教师模型”(Teacher Model),去指导一个结构更小、计算更轻的“学生模型”(Student Model)学习。这就像一位经验丰富的老师,不直接告诉你标准答案,而是通过讲解思路、分析错误、指出重点,让你自己慢慢领悟并形成自己的理解。学生模型不是复制老师,而是“吸收”老师的智慧。

官网:https://www.jetbrains.com/pycharm/适用场景:大型项目、Web开发(Django/Flask)、团队协作、专业级调试。版本选择Community(社区版):免费,支持纯Python开发。Professional(专业版):付费,支持Web框架、数据库、科学工具、远程开发等。优点智能代码补全、重构、错误检测极强集成调试器、测试工具、虚拟环境管理支持 Docker

从 Stable Diffusion 的开源引爆,到 SD3 的架构革新,再到 FLUX 的上下文智能编辑,图像生成模型正从“被动生成”走向“主动理解与修改”。FLUX 的出现标志着开源模型在可控性与实用性上迈入新阶段——尤其适合需要精确空间约束、结构保持与真实感生成的专业场景(如城市规划、遥感变化检测、建筑分布模拟等)。未来,随着流匹配、多模态理解与编辑能力的深度融合,图像生成将不仅是创意工具,

2025年11月,AI已经不再是“玩具”了。如果你要写代码,请无脑冲Claude或DeepSeek。如果你要写论文/读研报Kimi和GPT-5是你的救命稻草。如果你要做视频/搞设计海螺AI和腾讯混元会让你打开新世界的大门。未来已来,甚至有点拥挤。不要只做一个看客,赶紧点击上面的链接,成为第一批驾驭这些“神兽”的人吧!

从2014年简单的逐帧预测,到2025年Sora的世界模拟能力,视频生成技术经历了近十年的快速发展。这一历程不仅见证了深度学习技术的成熟,更预示着AI将在创意产业中发挥越来越重要的作用。正如OpenAI在Sora发布时所说:"我们正在向通用人工智能迈进,而视频生成只是这个宏伟蓝图中的一个重要步骤。"我们有理由相信,在不远的将来,每个人都能够轻松地创造出属于自己的精彩视频内容。这场从GAN到Sora

视觉-语言-动作(Vision-Language-Action, VLA)模型标志着人工智能领域的一项变革性进展,旨在将感知、自然语言理解与具身行动统一于单一的计算框架之中。本综述系统性地梳理了VLA模型近年来的研究进展,并围绕五大主题支柱对该快速演进领域的研究图景进行了全面整合。首先,我们确立了VLA系统的概念基础,追溯其从早期跨模态学习架构逐步演进为通用型智能体的发展脉络——此类智能体紧密融合