简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这部分代码的功能是初始化一个 GPT-2 模型的配置对象。,该对象将用于后续创建 GPT-2 模型实例。

GELU(x) = xΦ(x) ≈ 0.5x(1 + tanh[√(2/π)(x + 0.044715x³)])# 近似计算。timeit.timeit(lambda: nn.ReLU()(x), number=100)# 约0.12秒。timeit.timeit(lambda: nn.GELU()(x), number=100)# 约0.18秒。self.activation = nn.ReLU

分析用户“1000113200000151566”常去的加油站点和通常的加油时间;数据集介绍:该表记录了用户在11月和12月一天24小时内的加油信息,包括:持卡人标识(cardholder)、卡号(cardno)、加油站网点号(nodeno)、加油时间(opetime)、加油升数(liter)、金额(amount)统计17:30~18:30期间加油的人数和平均加油量,以及该时间段的加油总量在一天中

【代码】【计算机视觉】构造一个3*3卷积核,对一幅512*512*3的原始图像进行卷积操作。其中512*512*3分别表示图像的宽、高和通道数。

该方法用于数据集的预取操作。`AUTOTUNE`常量的值由之前定义的`tf.data.AUTOTUNE`决定,它会自动根据可用的系统资源动态选择合适的缓冲区大小,以加速数据加载。`EarlyStopping` 是 Keras 中的一个回调函数,它监视指定的指标(在这个例子中是验证准确率 `'val_accuracy'`),并根据预先设置的条件来判断是否停止训练。通过这些数据集配置操作,可以在训练过

已经安装了pandas库,但仍然遇到导入错误,可能是因为你的开发环境没有正确配置或没有选中正确的Python解释器。:创建一个虚拟环境,确保在虚拟环境中安装了。在激活虚拟环境后,使用。

通过 Ubuntu 的默认软件源安装,但这种方式安装的版本可能较旧(建议后续通过。:指定服务端口为 8001(默认是 8000)。并安装依赖项的步骤说明。实例(FastAPI 应用对象)。:开发模式,代码修改后自动重启服务。服务启动后,可通过浏览器或工具(如。,并初始化一个前端项目的步骤记录。表示当前已安装的 npm 版本是。的虚拟环境目录,隔离项目依赖。、Postman)访问 API。用户进入前

其中 BGE 为 BAAI General Embedding(智源通用嵌入模型 ),M3 代表 Multi - Functionality(多功能性 )、Multi - Linguality(多语言性 )、Multi - Granularity(多粒度性 ) ,该模型由北京智源人工智能研究院开发,是具备多语言、多功能、多粒度特征的语义向量模型。• 多语言性(Multi-Linguality):B

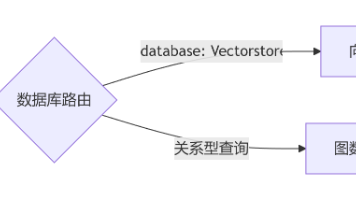

下面这一段代码(有自定义)使用了自定义的提示模板(PromptTemplate)和输出解析器(LineListOutputParser),而第一段代码只使用了MultiQueryRetriever.from_llm的默认设置。-----------------------------(到此构建向量数据库完成)------------------------------(到此sql生成完成)d. 检