简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:Label Studio 是一款开源数据标注工具,支持多种数据类型标注并导出为模型格式。本文介绍了如何搭建基于 Qwen2-VL 视觉大模型的 ML backend 实现自动标注功能。环境配置使用 AutoDL 云服务器,安装 Label Studio 及依赖库,创建虚拟环境。重点开发了 Flask 后端服务,通过调用 Qwen-VL API 实现目标检测,输出归一化坐标的 bbox 结果。

是一个开源的实时交互数字人系统,通过多模态AI技术实现语音驱动的虚拟形象生成,支持低延迟视频流输出,适用于虚拟客服、直播、教育等多种场景。。

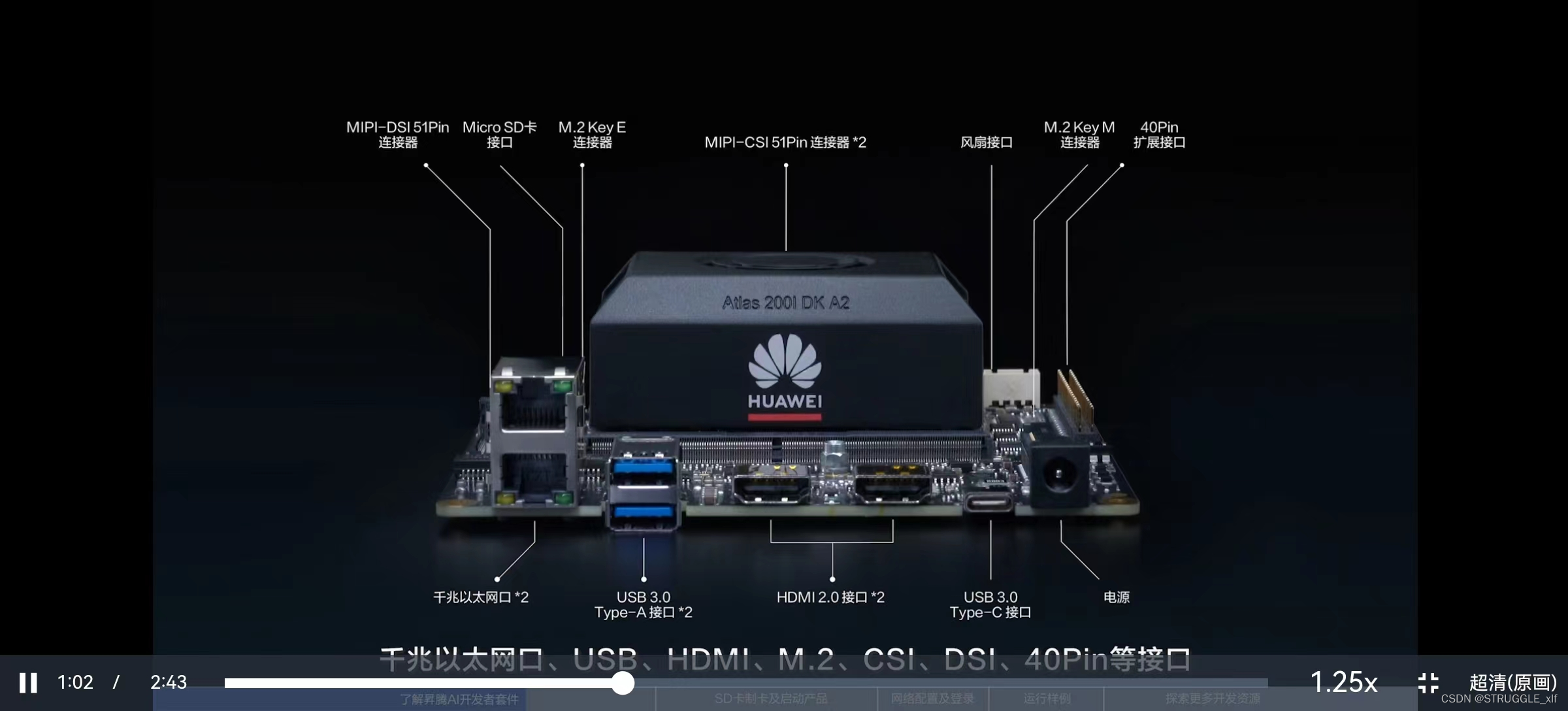

AscendCL的基本概念

个人开发者、高校师生和行业工程师。可用于AI技术学习、AI教学实践、趣味应用开发、行业算法验证,满足开发者在视频图像分析、自然语言处理和机器人等场景的研发需求。具有丰富的外设接口,提供了主流AI算法模型和多样化的参考样例。配套昇腾全流程开发工具链。套件由核心模组和扩展底板组成,具有丰富的外设接口,如千兆以太网口、USB、HDMI、M.2、CSI、DSI、40Pin等接口。核心模组是一组SoC,集成

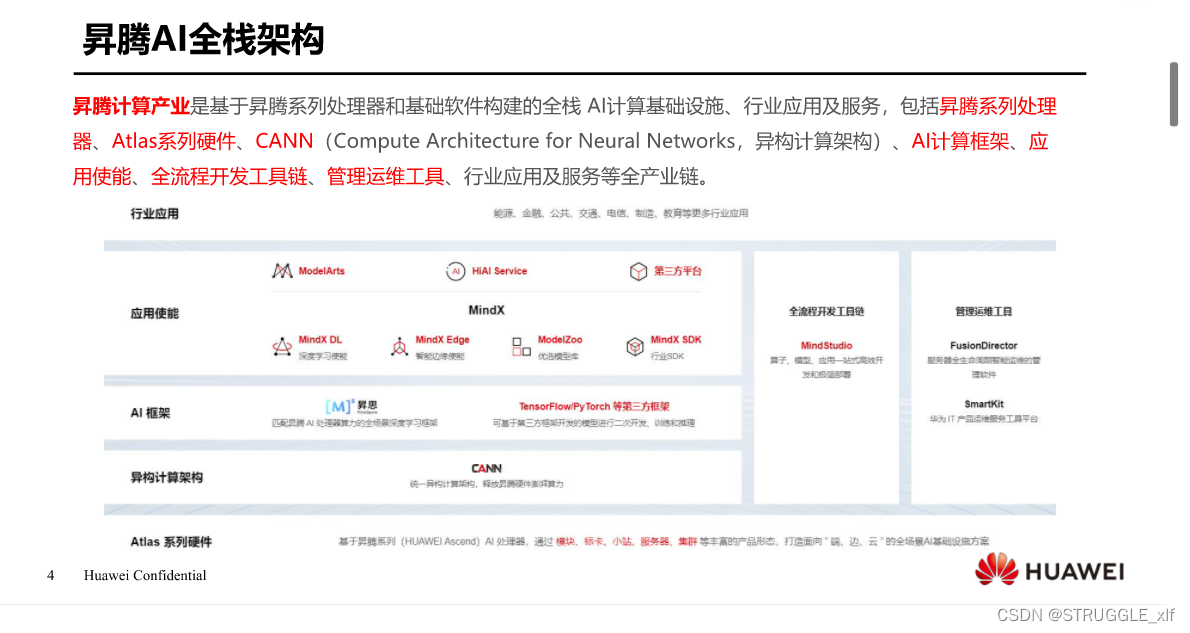

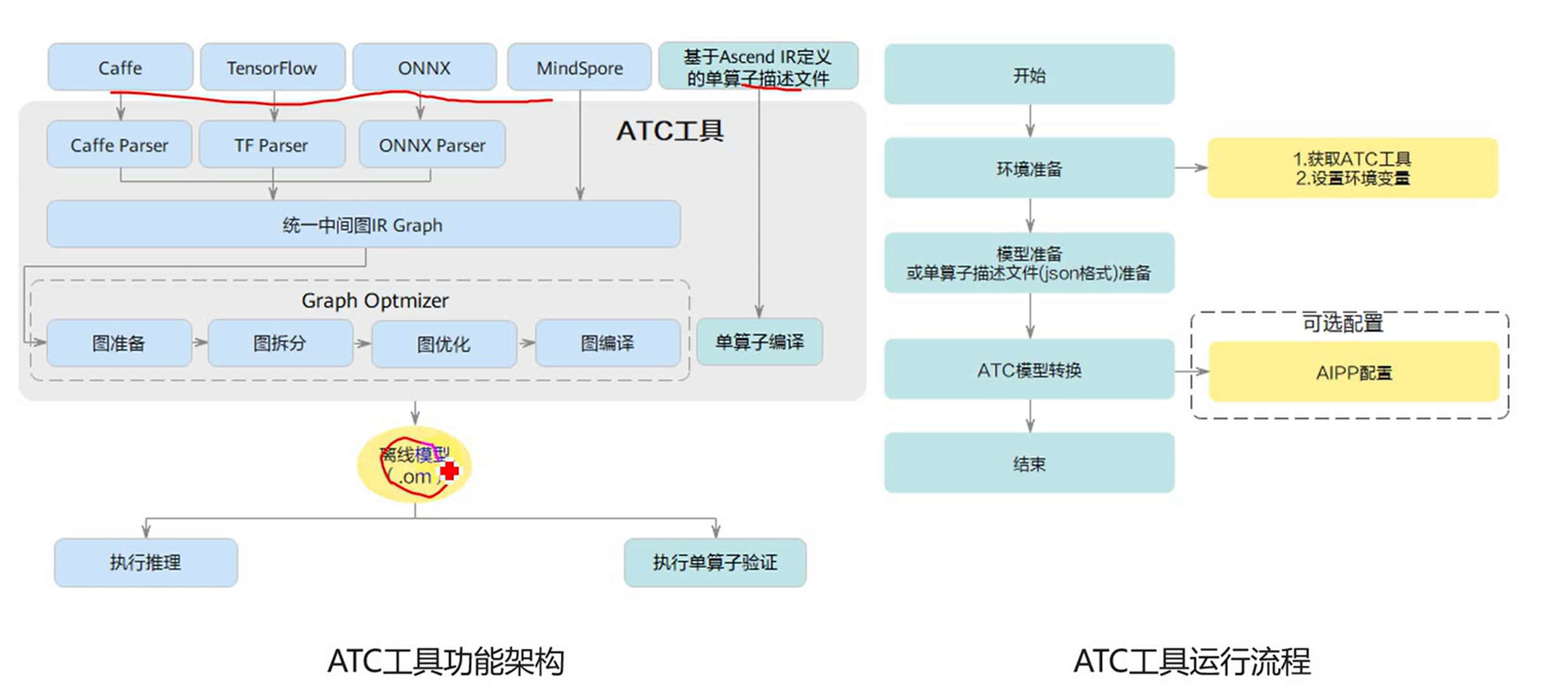

支持原始框架类型为Caffe、TensorFlow、MindSpore、ONNX的模型转换:当原始框架类型为Caffe、MindSpore、ONNX时,输入数据类型为FP32、FP16(通过设置入参–input_fp16_nodes实现,MindSpore框架不支持该参数)、UINT8(通过配置数据预处理–insert_op_conf实现);当原始框架类型为TensorFlow时,输入数据类型为F

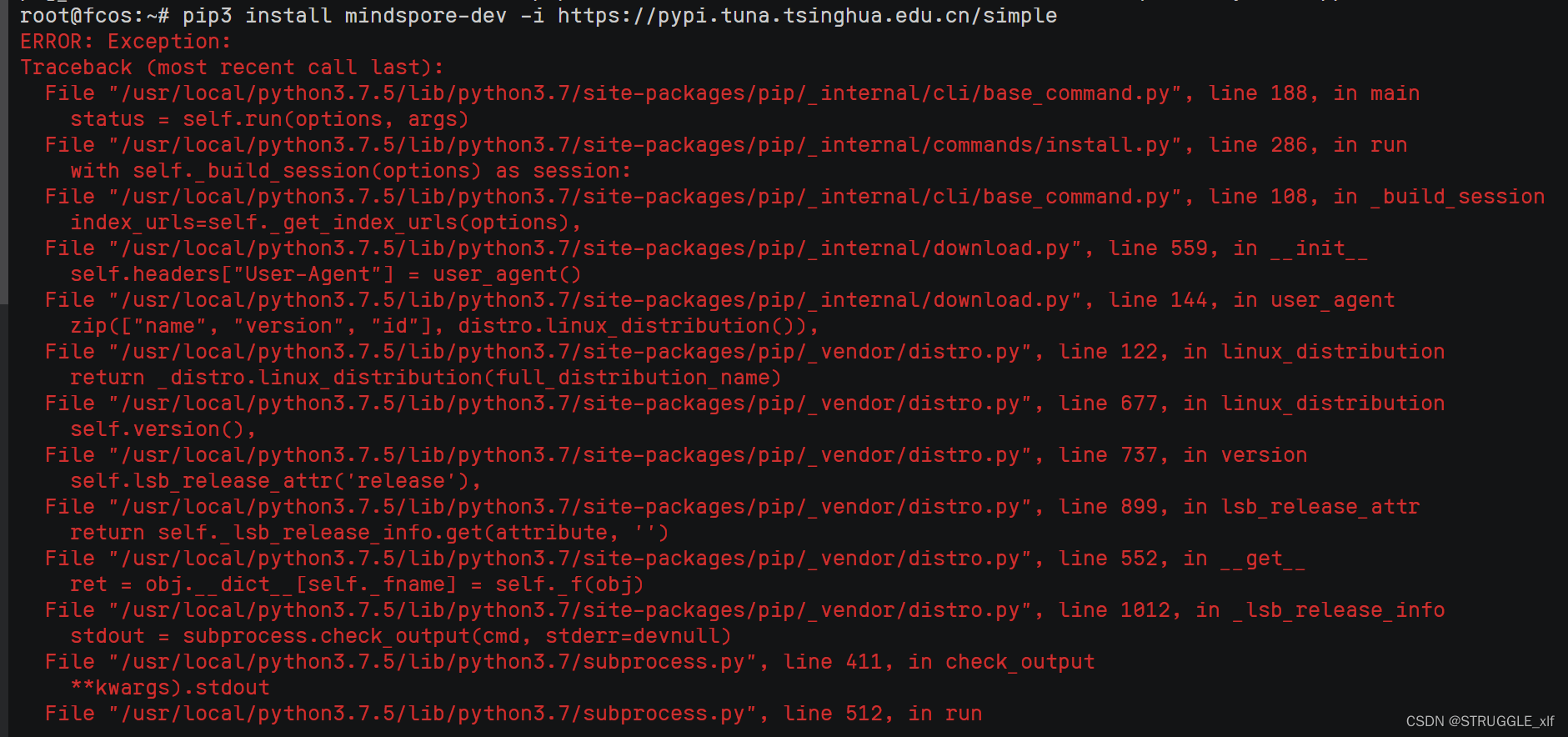

【代码】安装MindSpore时报错。

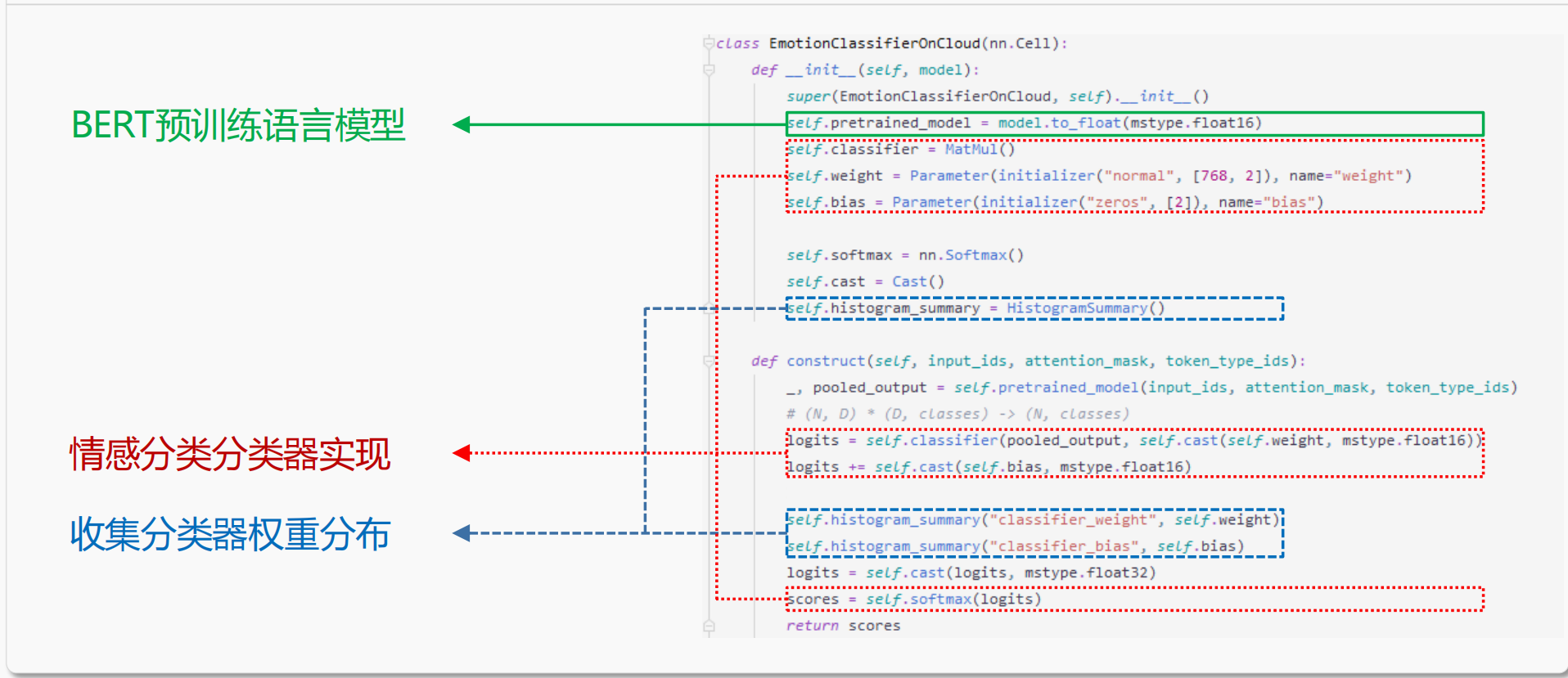

BERT(Bidirectional Encoder Representations from Transformers)是由Google提出的具有里程碑意义的自然语言理解模型,BERT能够充分利用海量的无标注数据对模型进行预训练,另模型学习到大量的语言知识。基于预训练先验知识的情况下,通过在下游任务上进行微调,即可达到较好的效果。执行该命令后,转换后的文件保存在当前目录下的output目录中(转

说明: 类别标签和类别的对应关系与训练模型时使用的数据集有关,本样例使用的模型是基于imagenet数据集进行训练的,您可以在互联网上查阅imagenet数据集的标签及类别的对应关系,例如,可单击Link查看。购买 ECS 云环境成功后,您可以获取到一个服务器 IP 地址, SSH 方式远程登录到该服务器上,您可以接着快速体验样例,参见第3单元快速体验。要注意这里的但引号是英文输入法下的Tab键上

1.一种是自动迁移方式。自动迁移是通过工具对原始脚本进行AST语法树扫描,可自动分析原生的TensorFlow API在异腾AI处理器上的支持度,并将原始的TensorFlow训练脚本自动迁移成异腾AI处理器支持的脚本,对于无法自动迁移的API,可以参考工具输出的迁移报告,对训练脚本进行相应的适配修改。手工迁移需要算法工程师人工分析TensorFlow训练脚本中的API支持度情况,并且参照文档逐一

模型训练\推理过程中可能遇到的问题:• 代码编写错误,问题难以定位;• 模型结构错误;• 权重更新错误;• 损失函数设计错误;• 半精度下计算溢出;• Loss scale调整不当;• 过拟合、欠拟合;• 梯度消失/爆炸;• 激活值饱和;• 学习率设置不当;• 批大小(batch size)、期(Epoch)设置不当;• 模型训练/推理慢;• …