简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

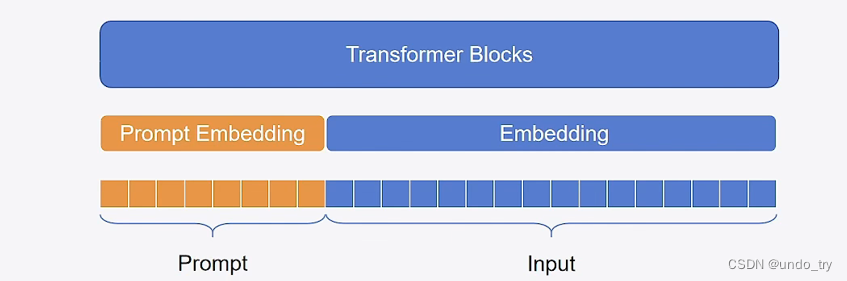

参数高效微调PEFT(二)快速入门P-Tuning、P-Tuning V2

参数高效微调PEFT(二)快速入门P-Tuning、P-Tuning V2

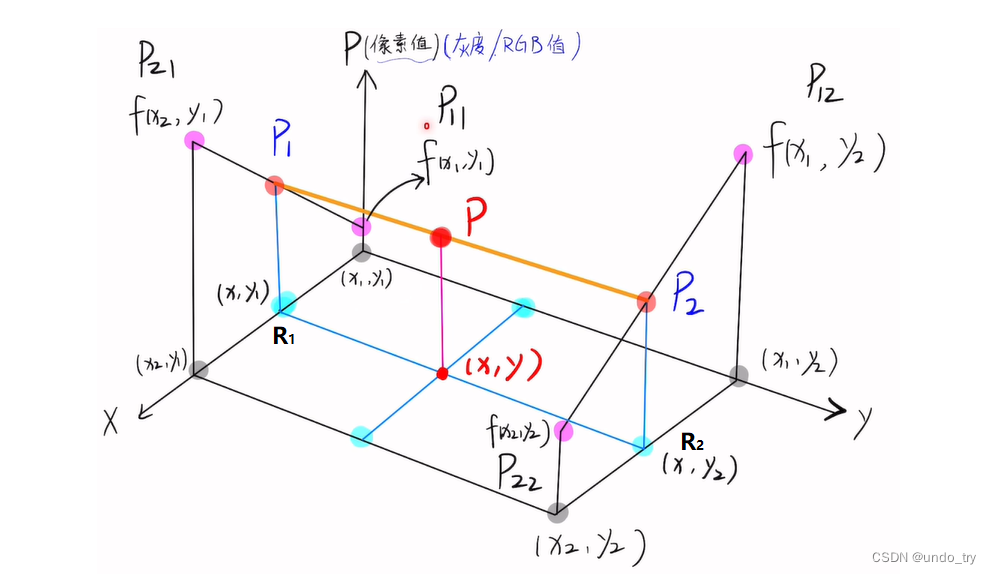

Pytorch常用的函数(四)深度学习中常见的上采样方法总结

Pytorch常用的函数(四)深度学习中常见的上采样方法总结

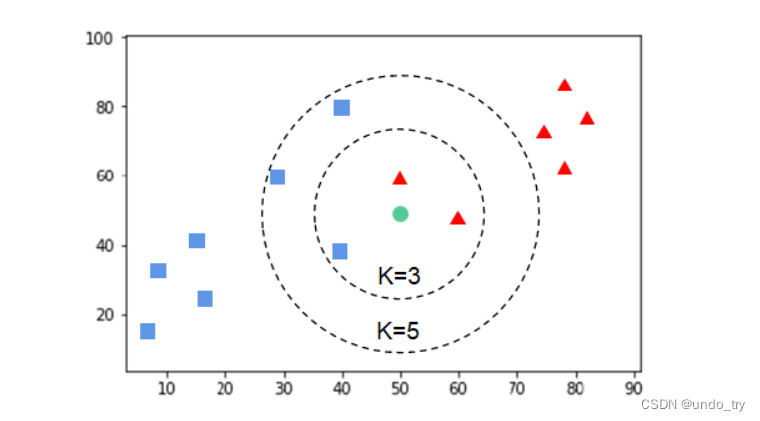

经典机器学习模型(二)KNN模型

经典机器学习模型(二)KNN模型(构造kd树实现)

深度学习推荐系统(七)NFM模型及其在Criteo数据集上的应用

深度学习推荐系统(七)NFM模型及其在Criteo数据集上的应用

传统机器学习(五)—分类、回归模型的常见评估指标

传统机器学习(五)—分类、回归模型的常见评估指标

传统机器学习(七)支持向量机(2)sklearn中的svm

sklearn中的svm参数详解、案例分析

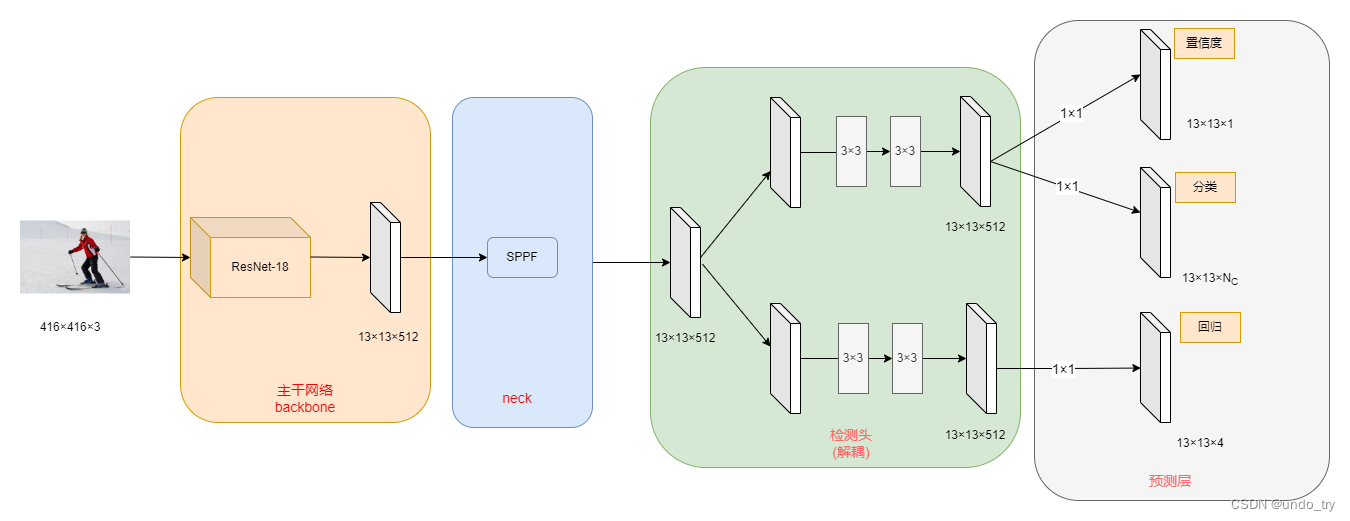

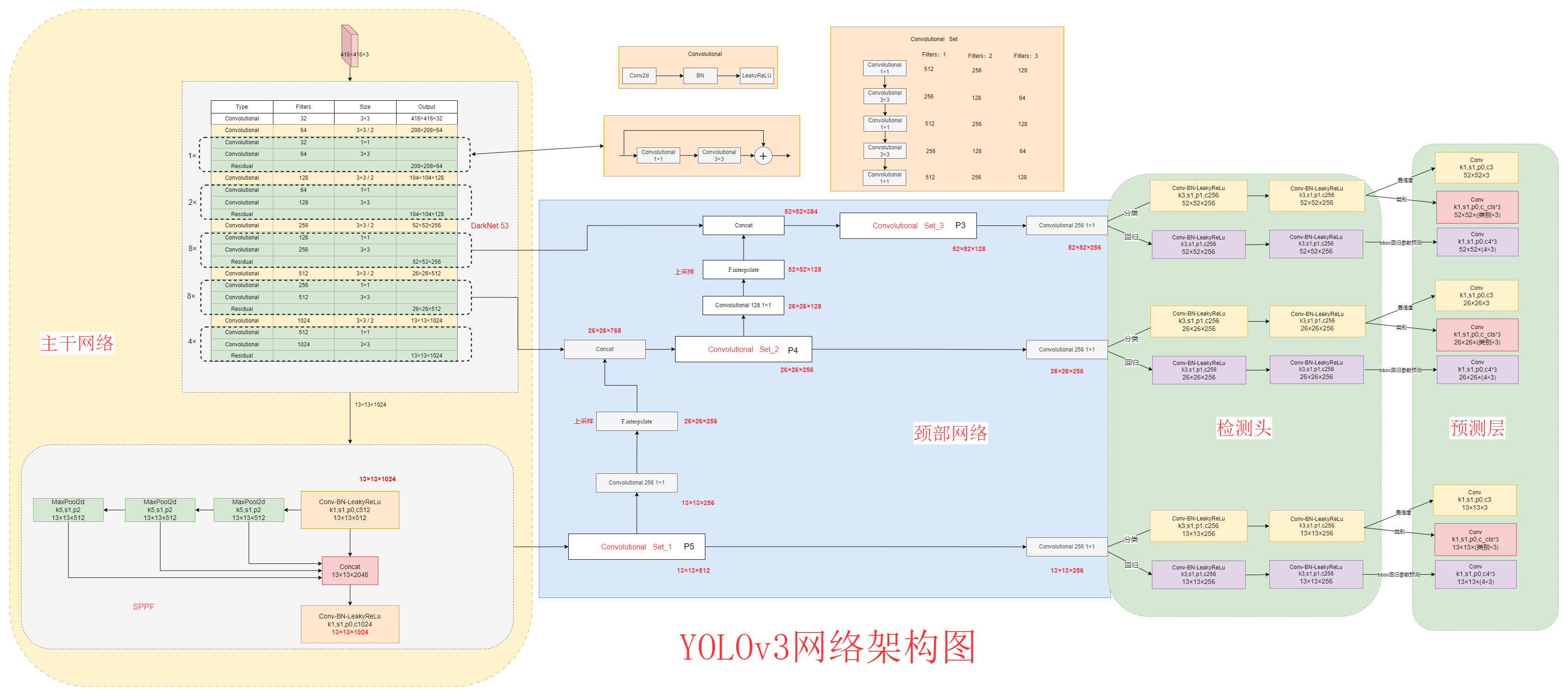

经典目标检测YOLO系列(三)YOLOv3算法详解

经典目标检测YOLO系列(三)YOLOv3算法详解

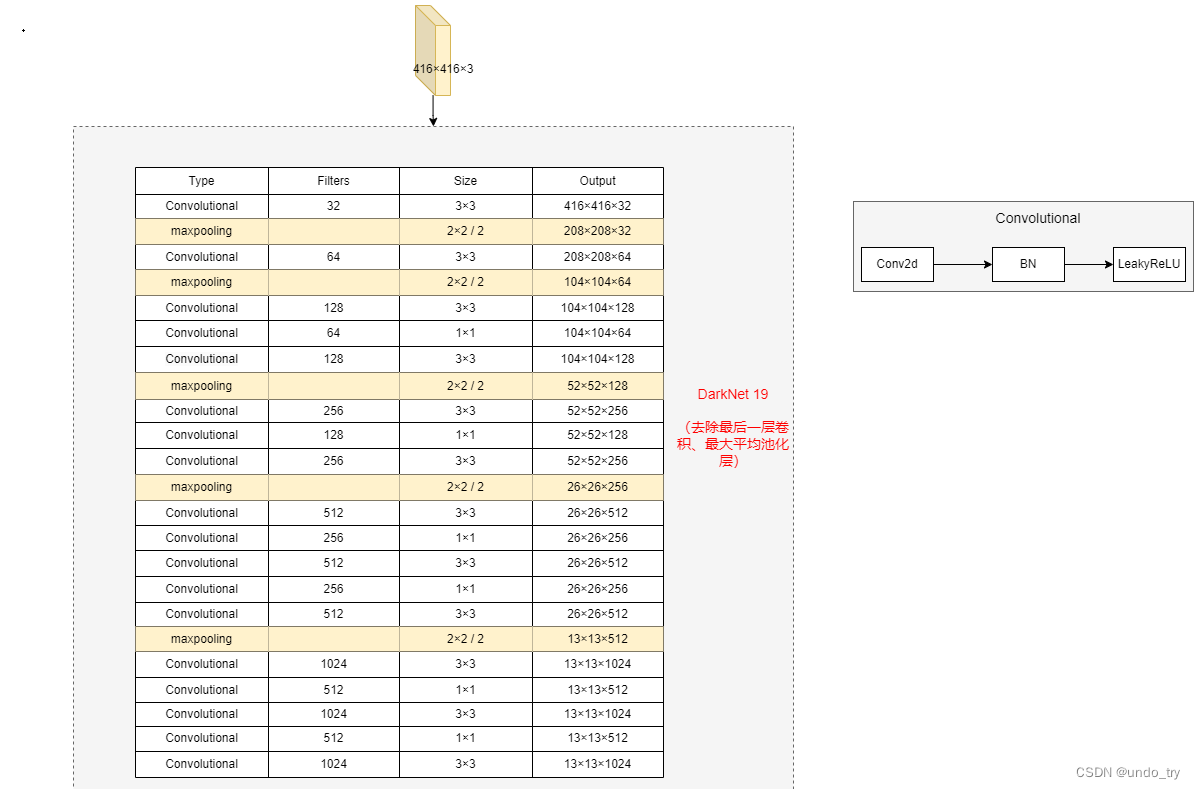

经典目标检测YOLO系列(二)YOLOV2的复现(1)总体网络架构及前向推理过程

经典目标检测YOLO系列(二)YOLOV2的复现(1)总体网络架构及前向推理过程

经典目标检测YOLO系列(一)YOLOV1的复现(1)总体架构

经典目标检测YOLO系列(一)YOLOV1的复现(1)总体架构