简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

理解将 Numpy 矩阵保存为图像的过程需要一些关于图像表示和矩阵的基本知识。下面我们详细解释矩阵设置的原理,以及灰度图像和彩色图像的区别,以帮助初学者更好地理解这些概念。

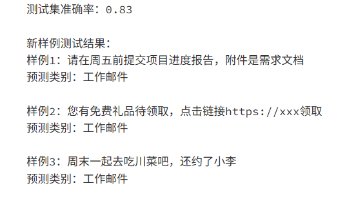

摘要:分类模型评估指标与可视化实践 在分类任务中,仅依赖准确率(Accuracy)会导致误判,尤其在类别不平衡时(如垃圾邮件检测)。需结合精确率(Precision)、召回率(Recall)和F1分数(F1-Score)全面评估: 精确率:预测为正类的样本中实际为正类的比例,避免误判(如垃圾邮件检测中减少正常邮件的误判)。 召回率:真实正类中被正确预测的比例,避免漏判(如癌症筛查中减少漏诊)。 F

在 Numpy 中,三维数组(张量)是通过嵌套列表创建的,每个维度可以看作是一个更高维度的数组的元素。这个张量可以看作是一个 2x2x2 的数组(即 2 个 2x2 的矩阵)。让我们详细解释一下这个三维张量的结构,并说明如何对应到三维坐标。

摘要: 早停(Early Stopping)是防止模型过拟合的关键技术,通过监控验证集指标(如准确率、F1值)在训练过程中动态终止训练。其核心原理是设置"耐心值"(Patience),当验证集性能连续多轮未提升时停止,并保存最优模型而非最终模型。以PyTorch为例,需自定义早停类,在训练循环中实时判断指标变化,避免模型陷入过拟合。参数调整中,Patience建议5-15轮,d

本文总结了Transformer中Q/K/V权重矩阵的核心要点:1)权重矩阵将512维输入向量转换为64维的Q/K/V向量,以平衡计算效率和信息保留;2)单头注意力中,W_Q/W_K/W_V维度固定为512×64;3)多头注意力(如8头)将权重矩阵拆分为8组512×8的子矩阵,独立计算后拼接;4)权重矩阵数值动态调整,初始随机,训练中优化以捕捉词间关联;5)代码实现中,权重矩阵对应线性层的参数。核

位置向量(位置编码)是Transformer模型的关键设计,由谷歌团队Vaswani等人在2017年提出。它通过正弦余弦函数生成,具有三个核心特点:维度与词嵌入一致(通常512维),数值随位置周期性变化且唯一,与词嵌入直接相加而非拼接。这种设计既能保留语义信息,又能区分词序,支持任意长度句子处理,且不增加计算负担。例如,在512维设置中,每个位置对应一组独特的512个数字,通过相加方式将位置信息融

摘要 本项目基于BERT+PyTorch实现小样本邮件分类,针对"每类仅10条标注样本"的场景,通过预训练模型微调达到83%准确率。实验使用自定义3类邮件数据集(工作/垃圾/私人邮件),采用轻量微调策略(冻结大部分BERT层、小学习率)和GPU混合精度训练优化效率。完整复现指南包含云平台与本地配置方案,核心代码仅需PyTorch、Transformers等基础库。项目验证了小样

Git协作中常见的non-fast-forward报错通常发生在本地分支与远程分支提交历史不同步时。该错误表明远程分支存在本地未包含的新提交,Git为防止数据丢失拒绝推送。解决方案需先拉取远程内容并合并:1)通过git fetch确认差异;2)执行git pull origin main --allow-unrelated-histories合并远程与本地提交;3)解决可能出现的文件冲突;4)重新

摘要:Transformer采用多层结构(如6层编码器/解码器)实现信息的逐层提炼,从局部词关系到全局语义逐步深化。单层仅能处理简单词关联,多层则通过"流水线式加工":底层提取基础词义(如"红苹果"),中层整合短语逻辑,高层解析跨句指代等复杂关系。层间传输遵循"维度守恒"原则(如保持512维),通过残差连接防止信息丢失,自注意力和前馈网络

定义:下游任务是机器学习中“最终要解决的目标任务”,上游过程(如特征工程、预训练)为其服务;起源:源于深度学习流程的“模块化分工”,当上游模块可复用时,下游任务的概念自然出现;核心应用领域:计算机视觉(CV)、自然语言处理(NLP)、图学习、跨模态学习等,均属于计算机科学与技术领域;核心价值:衡量上游过程的有效性,明确技术优化的目标,简化复杂流程的表述。