简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

├── citation: 答案和证据引用| ├── document: 文档解析和分块,支持多种文档类型| ├── generator: 生成器| ├── judger: 文档选择| ├── prompt: 提示词| ├── refiner: 信息汇总| ├── reranker: 排序模块| ├── retrieval: 检索模块| └── rewriter: 重写模块。

阿里团队提出WebWalkerQA基准和WebWalker多智能体框架,解决传统RAG在开放域问答中仅能横向检索浅层内容的问题。WebWalkerQA包含680道需多层级网页跳转的中英双语题目,测试显示GPT-4o准确率仅40%。WebWalker通过Explorer(模拟点击)和Critic(信息筛选)双Agent协同,实现纵向深度检索。实验表明,横向RAG与纵向WebWalker结合可使准确率

Kimi-1.5 和 DeepSeek-R1 都是通过强化学习提升大型语言模型推理能力的优秀模型。Kimi-1.5 在多模态任务中表现出色,而 DeepSeek-R1 在数学和编码任务中略胜一筹。未来的研究可以进一步探索如何结合两者的优点,开发出更高效、更通用的推理模型。

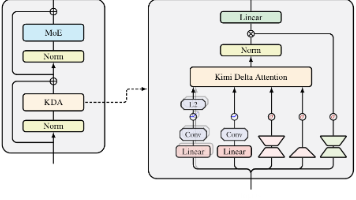

基于 MoE 原理,将上下文划分为块,利用门控机制让每个查询令牌动态选择历史相关的键值块进行注意力计算。通过计算查询与块的亲和度分数,使用 top-k 门控选择最相关的块,同时通过特定设计保持因果性,并且支持细粒度块分割和与全注意力的混合

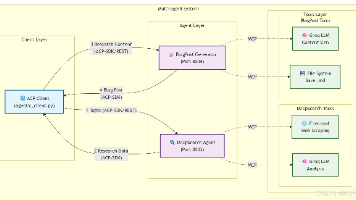

IBM推出智能体通信协议ACP,推动AI智能体互操作性发展 IBM研究中心于2025年推出智能体通信协议(ACP),旨在解决AI智能体间的互操作性问题。ACP作为开放式通信标准,支持不同框架和技术栈的智能体相互协作,有效解决了当前智能体集成面临的框架多样性、自定义集成复杂等挑战。该协议随后被捐赠给Linux基金会,并与谷歌的A2A协议合并,形成了统一的行业标准。项目展示了基于ACP-SDK构建的深

DeepSeek(或任何大型语言模型)输出的“深度思考”并非真正的逻辑思考,而是对复杂文本模式的高效模仿。真正的逻辑思考仍是人类独有的能力——它根植于对世界的身心体验、对矛盾的价值抉择,以及对未知的敬畏与探索。技术能扩展思考的工具箱,但无法替代思考的主体性。LLM的“深度思考”本质是。

企业RAG挑战赛冠军伊利亚·莱斯揭秘了一套高效问答系统的构建秘籍。面对100份千页级企业年报,他通过**GPU加速解析**(40分钟搞定15万页)、**分库向量检索**(每企业独立FAISS库)和**LLM重排序**(成本仅0.01美元/问)三大绝招,实现了精准答案生成。系统创新点包括:**动态路由策略**(自动识别问题类型)、**思维链结构化输出**(强制LLM分步推理),以及**反常识优化**

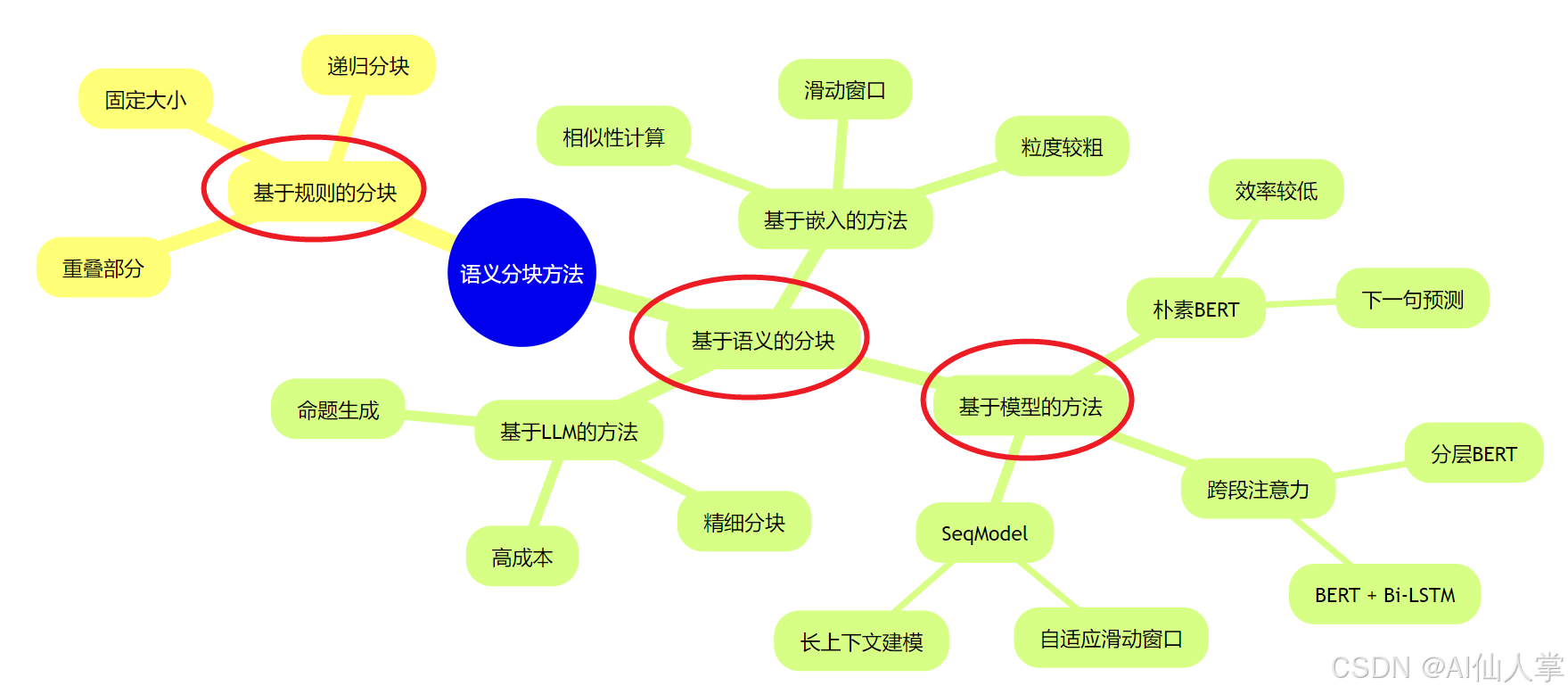

在RAG中,我们首先需要将文档解析成结构化的数据,然后将其拆分成更小的块,以便提取详细的特征并进行嵌入表示。传统的分块方法通常是基于规则的,比如固定大小的分块或相邻分块的重叠。然而,这些方法在实际应用中可能会遇到一些问题,比如检索上下文不完整或分块过大导致噪声过多。语义分块的目标是确保每个分块尽可能包含语义上独立的信息。这样一来,RAG模型在检索和生成时就能更加精准地找到相关信息,避免“捡了芝麻丢

摘要:Kimi Linear提出新一代线性注意力架构KDA(Kimi Delta Attention),通过逐通道门控遗忘机制和可学习位置编码,首次实现线性注意力全面超越传统Transformer。该方案采用3:1混合架构(3层KDA+1层全注意力),在1M长上下文场景下实现6.3倍解码加速,KV缓存减少75%,并在短/长上下文、推理速度、显存占用等维度全面领先。实验证明其训练效果优于标准Tran

Open-R1 是 Hugging Face 发起的一个项目,旨在公开复现 DeepSeek-R1 的完整流程。DeepSeek-R1 是一种大型语言模型,Open-R1 的目标是让任何人都能复现和在此基础上进行构建,降低研究和开发门槛。:随着人工智能技术的快速发展,大型语言模型如 GPT-3 等在自然语言处理领域取得了巨大成功。DeepSeek-R1 作为一个重要的模型,其完整复现具有重要的研究