简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

博主开辟了微信公众号,更多博客文章详见微信公众号“小宁算法梦工场”,欢迎读者们关注~

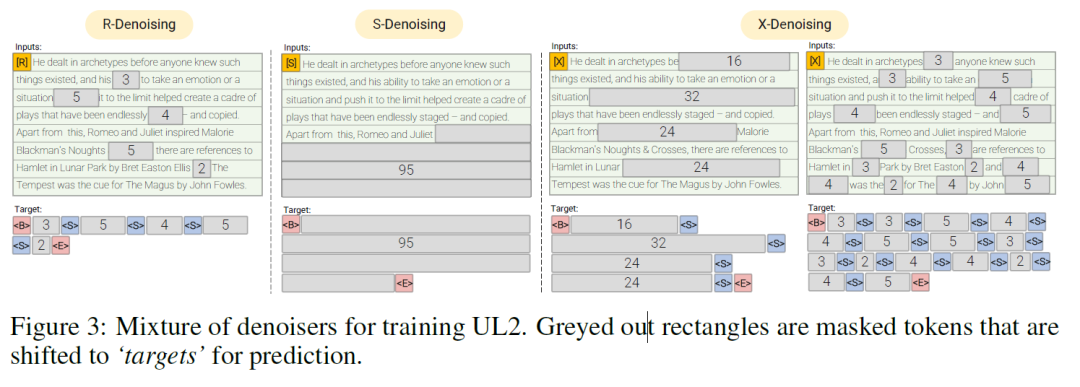

Prompt 主要适用于三个场景:低资源、低算力、统一场景。也曾在知乎上发表过想法:Prompt 在某种程度上可以进行模型的专家化(expertization)或者模块化(modularization),需要和进行沟通。这篇文章使用 paradigm prompt 进行 denoiser 的 mode switching,有进一步的启发意义。脱离 denoiser 的 mixture,可能会有更加

强化学习(七):n步自举法(多步引导法) 在之前,我们知道求解有限马尔可夫决策过程可以通过蒙特卡洛和时序差分来通过与环境多次交互从经验中学习,然而,蒙特卡洛方法在一些不满足分幕式任务或连续型任务上无法获得最终的收益,因此我们引入时序差分方法。时序差分的思想就是将下一时刻的状态价值或下一时刻的状态动作价值作为估计值,用于估计当前状态价值或动作价值。时序差分是一种结合采样和自举的方法,那么一种介于.

论文解读:Dialogue Generation: From Imitation Learning to Inverse Reinforcement Learning 对话生成是一个常见的自然语言处理任务,其在工业界广泛应用与智能客服,闲聊机器人等。现如今主要研究于如何提高对话的质量,多样性。本文则采用先进的技术试图解决这个问题。一、简要信息序号属性值1模型名称DG-AIRL2所属领域自然语言处

强化学习(五):蒙特卡洛采样方法 在强化学习(四)中,我们学习了如何使用动态规划法求解强化学习问题,我们还学习了策略评估和策略改进,以及广义策略迭代(GPI),事实上,动态规划能够很好地收敛到最优值,但是否动态规划就是最好的呢?显然不是。回顾一下动态规划的状态价值函数的贝尔曼方程:vk+1(s)=∑aπ(a∣s)∑s′,rp(s′,r∣s,a)[r+γvk(s′)]v_{k+1}(s)=\...

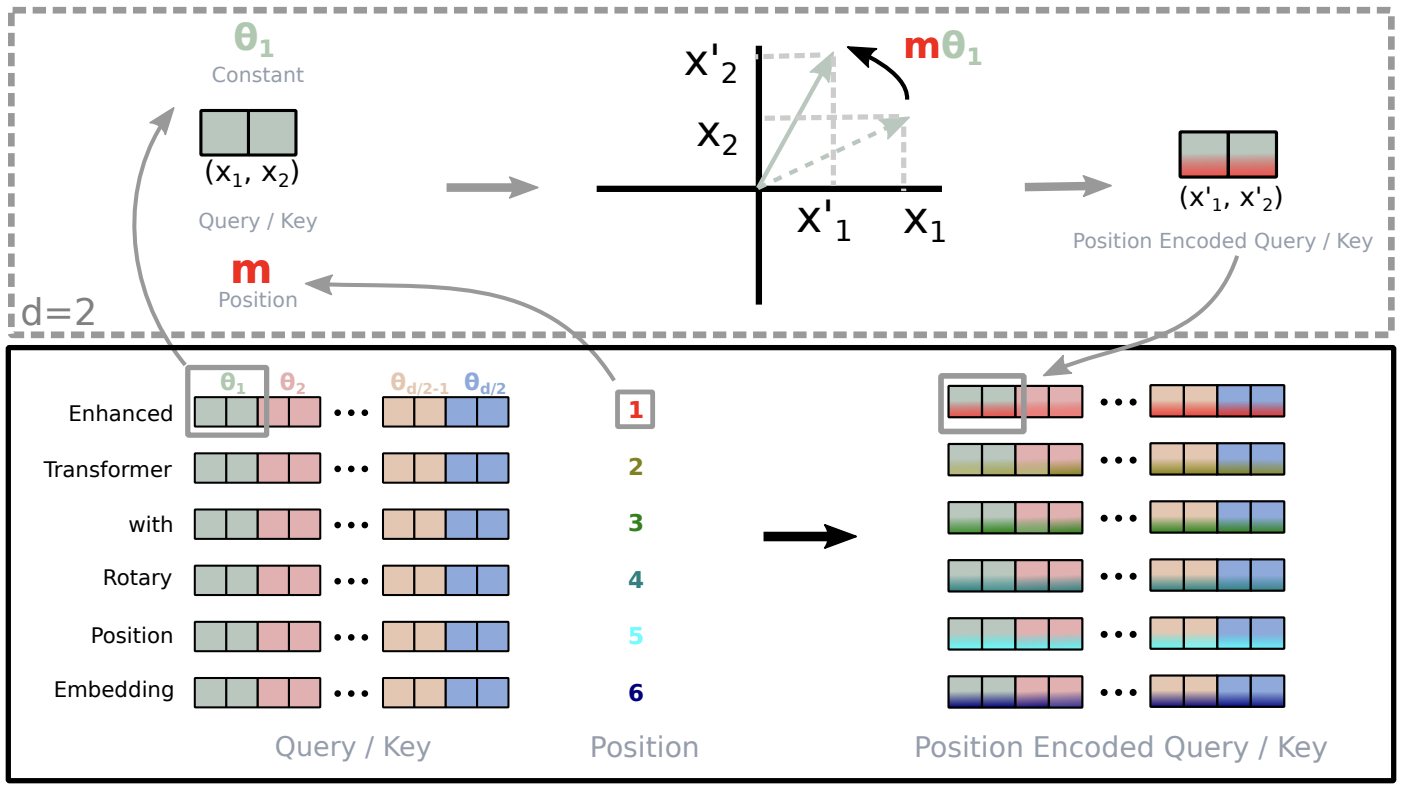

现如今很多大模型都开始支持超过4096长度的推理,例如GPT-4支持超过30k,ChatGLM2-6B也支持最长为32K的文本,但是由于显存资源的限制,这些大模型在真正在训练过程中不一定要训练这么长的文本,通常在预训练时只会设计到4k左右,因此**如何确保在模型推理阶段可以支持远远超过预训练时的长度**,是目前大模型的核心问题之一,我们将这一问题归为**大模型的外推性**。

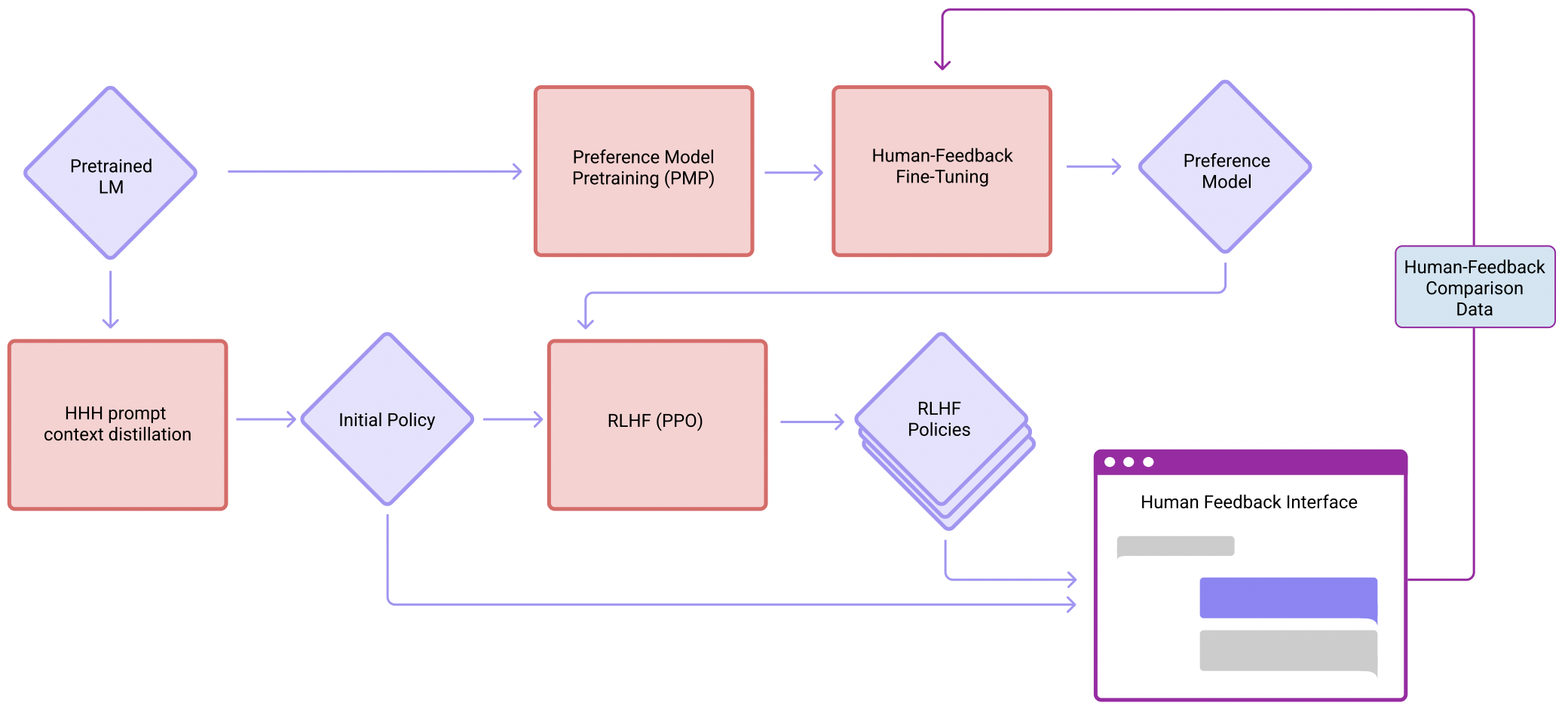

主要介绍Anthropic LLM大模型

发现,大模型可能会在生成代码的时候同时写一些推理思考的文本,为了较好地区分,这里对于非编程代码的部分全部添加一个“#”,作为注释。随着大模型的发展,以Chain-of-Thought的提示学习方法可以有效地提升算术推理的性能。对于一些特殊的推理场景,有必要结合CoT完成多步骤:PoT可以先为一个Question生成一个中间推理和计算的结果,基于中间结果再继续使用CoT完成剩余的推理工作。例如时间计

关联规则常用算法 关联规则(Association Rules)是海量数据挖掘(Mining Massive Datasets,MMDs)非常经典的任务,其主要目标是试图从一系列事务集中挖掘出频繁项以及对应的关联规则。关联规则来自于一个家喻户晓的“啤酒与尿布”的故事,本文通过故事来引出关联规则的方法。啤酒与尿布的故事 在一家超市里,有一个有趣的现象:尿布和啤酒赫然摆在一起出售。但是这个奇怪的举

大语言模型Chain-of-Thought与Agent