简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Tensorflow 的cpu版本和gpu版本所谓的cpu版本gpu版本值得就是计算核心的分别,分别是gpu核心,cpu核心。既然如此了解cpu和就显得很重要了。cpu是一种复杂的计算的软硬件结合,是个繁琐的计算处理,包含了各种中断,资源切换等。gpu也是一种软硬件解和体系,他适合的是一种简单的重复的大量运算。而且他不想cpu就几个核,目前gpu核有五百多个,而且未来还会增加。两种...

概述很多学习python的初学者甚至学了有一段时间的人接触到anaconda或者其他虚拟环境工具时觉得无从下手, 其主要原因就是不明白这些工具究竟有什么用, 是用来做什么的, 为什么要这么做, 比如笔者一开始也是不明白为啥除了python之外我还需要这么一个东西, 他和python到底有啥联系和区别, 为啥能用来管理python.在使用过之后我才逐渐发现其实anaconda等环境管理工具究...

目录概要如果你不小心删除了系统的python怎么办一:误删怎么办?1.1:删除相关python1.2:删除相关yum1.3:安装系统python1.4:安装系统yum...

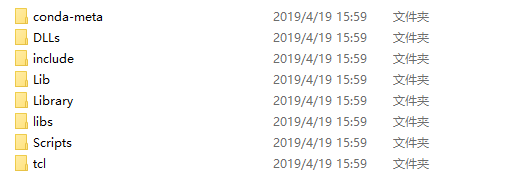

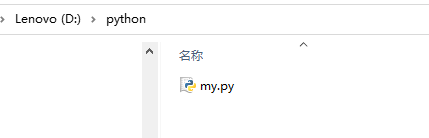

有时候我们需要在程序中导入额外的python包,这个时候就需要用到这里的知识.这里介绍两种导包方式.一. 手动导包其工作的原理就是将搜索路径加入python的sys.path 数组中.python工作的时候会自动搜索sys.path 中所有的目录,那么我们可以自定义一个目录,然后在目录中建立一个或者多个.py文件,然后将这个目录添加到sys.path中就行了,举例如下.建立目录: D:\pytho

当Jedispool资源池连接用尽后,调用者的最大等待时间(单位为毫秒)。默认值为-1,表示永不超时,不建议使用默认值。#如果该属性为true,表示会用一个专门的线程对空闲的连接进行有效性的检测扫描,默认值为true,表示进行空闲连接的检测。#表示一个Jedis连接至少停留在空闲状态的最短时间,然后才能被空闲连接扫描线程进行有效性检测。#如果有效性检测失败,则表示连接无效,会从资源池中移除该连接。