简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

了解小编的读者应该知道,我在从事了一段数据分析师的工作之后,目前岗位的title已经换成了算法工程师。虽然两个岗位存在很大交集和共通之处,但无论是工作思维还是所需技术栈方面,也都存在很大差异。前期,一名读者在后台留言问我数据分析师转岗算法工程师的经历,今天本文就结合个人实际做以总结。PS:每个人对岗位的理解往往不同,视经历和认知的偏差,本文难免有其局限性和不同的观点,所以仅代表个人观点,权当参考。

在城市里开设一家24小时便利店有多难?创业者常常面临着熬夜看店、全年无休的困境,而选择增加雇佣员工看店又会面临着成本高昂、利润微薄的问题。日前在温州,一家AI无人值守便利店引发关注。在这家无人便利小店内,浙江移动试点部署了首例AI值守系统以及5G无人零售应用,基于中国移动自主研发的视觉大模型技术,有效解决了中小微门店人工贵、招人难、守店累的痛点问题,可以更智能地处理无人值守中遇到的复杂销售场景问题

Edward Donner开发的8周LLM工程师训练营,面向工程实践的大语言模型开发指南。涵盖从开发环境配置到部署的完整工程化流程,注重实战技能培养和最佳实践传授。这十个GitHub仓库构成了AI智能体技术栈的完整生态系统,从理论基础到工程实践,从开发工具到部署运维,为不同背景的开发者提供了系统性的学习路径。

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

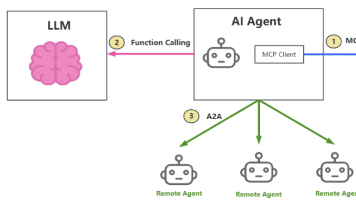

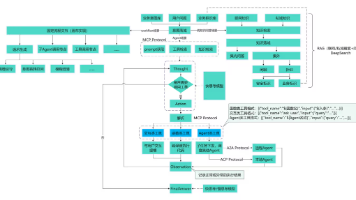

单纯的大模型,只能对话和生成文本,是“思想的巨人,行动的矮子”。配上Agent的大模型,能感知环境、使用工具、执行任务,成为“万能助手”。MCP、Function Calling 和 A2A。这三项技术,并不是有你无我的排斥关系,而是可以通力协作的互补关系。大模型通过 Prompt 学习工具使用,实现非结构化任务处理,克服传统规则的“刚性”,使得AGI(Artificial General Int

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

春晚全民破圈:国家层面认可,资本与资源全面涌入AI赛道企业真实扩招:从互联网大厂到中小科技企业,全线扩编抢人赛道全面爆发:大模型、具身智能、AI安全、AIGC、智能驾驶、医疗AI、金融AI,机会遍地开花窗口期非常短:风口不等人,早入场早占位,早享受行业红利对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:

春晚全民破圈:国家层面认可,资本与资源全面涌入AI赛道企业真实扩招:从互联网大厂到中小科技企业,全线扩编抢人赛道全面爆发:大模型、具身智能、AI安全、AIGC、智能驾驶、医疗AI、金融AI,机会遍地开花窗口期非常短:风口不等人,早入场早占位,早享受行业红利对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

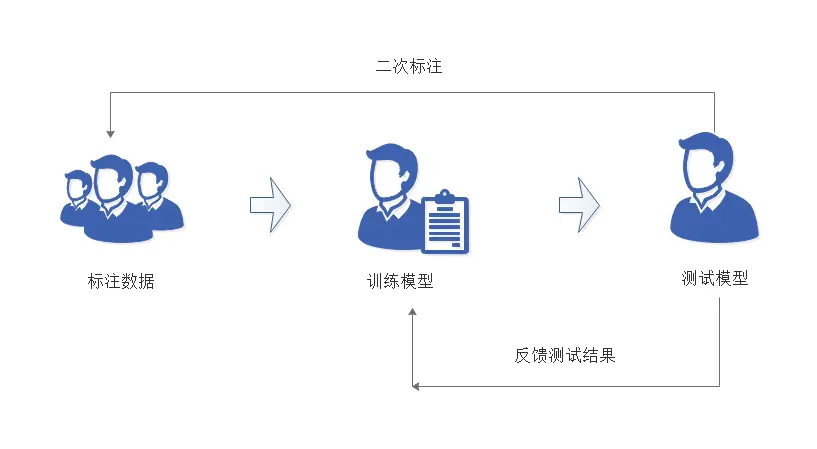

快速、高效的进行数据标注,是机器学习和深度学习的基础,现在一些标注工具通过深度学习模型和主动学习技术,通过NLP模型来提高标注效率,集数据标注、数据管理、模型训练和模型服务于一体,使数据标注更加轻松、更高效。离AI最近的重复复杂的工作,是首先会被机器取代的。