简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

近些年随着模型参数量的增大以及预训练语料的增长,单个模型的训练规模越来越大,消耗的成本越来越大, 尤其是2020之后,大型语言模型的兴起,将包括自然语言处理、计算机视觉、跨模态等场景带进了超大规模的军备竞赛中,但是就目前的硬件设计以及分布式通信所限,集群整体利用率较低。

5 月 14 日,腾讯宣布旗下混元文生图大模型全面升级并全面开源,目前已在 Hugging Face 平台及 GitHub 上发布,包含模型权重、推理代码、模型算法等完整模型,可供企业与个人开发者免费商用。据了解,这是,支持中英文双语输入及理解,参数量 15 亿。升级后的混元文生图大模型采用了与 Sora 一致的 DiT 架构,即,不仅可以支持文生图,也可以作为视频等多模态视觉生成的基础。

可能大家都想学习AI大模型技术,也想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;大模型岗位需求越来越大,但是相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约3960

1 LLaMA-Factory本地大模型微调2 本地大模型联网功能开发3 业务场景探索4 未来展望与实践建议。

RAG全称是。

OpenWebUI是一个可扩展、功能丰富且用户友好的自托管WebUI,它支持完全离线操作,并兼容Ollama和OpenAI的API。这为用户提供了一个可视化的界面,使得与大型语言模型的交互更加直观和便捷。

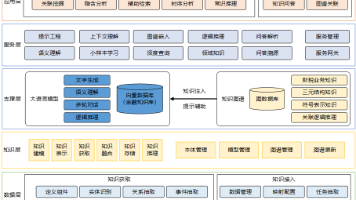

以数据和经验为基础的知识信息管理在各个行业和领域都至关重要,随着知识经济的到来,有效地管理和利用知识信息,成为企业获得竞争优势、促进创新和发展最有效途径。传统的知识存储媒介以纸质为主,借助计算机和互联网技术的发展,越来越多知识信息以电子文档的形式进行存储,以共享知识库为核心,通过建立共享知识和交流平台,实现数据和经验的价值复用。知识库中的数据来源多样,大量的非结构化信息需要人工处理,建设效率低、成

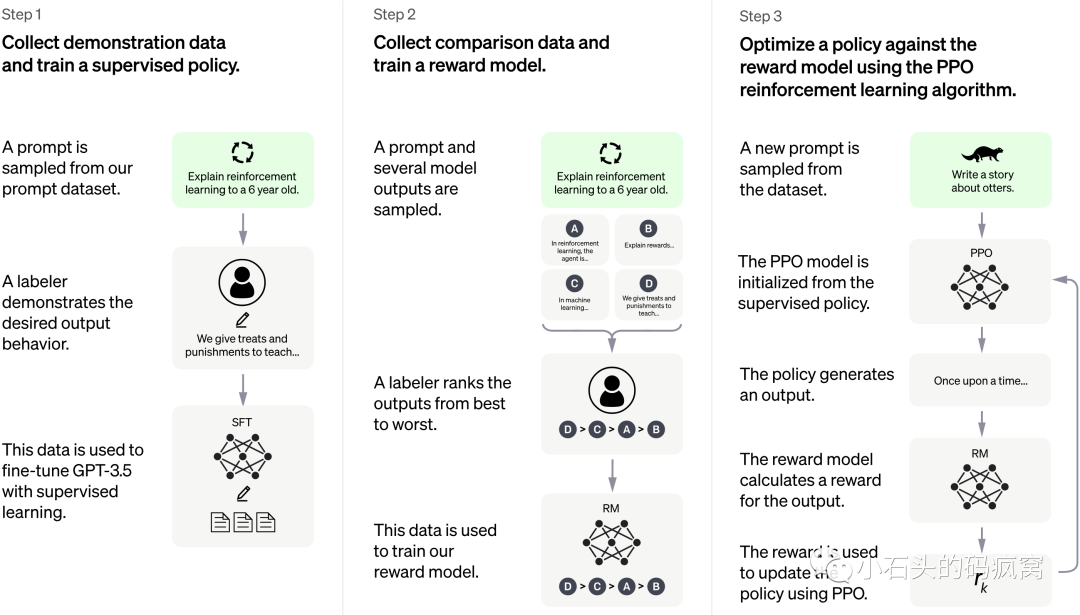

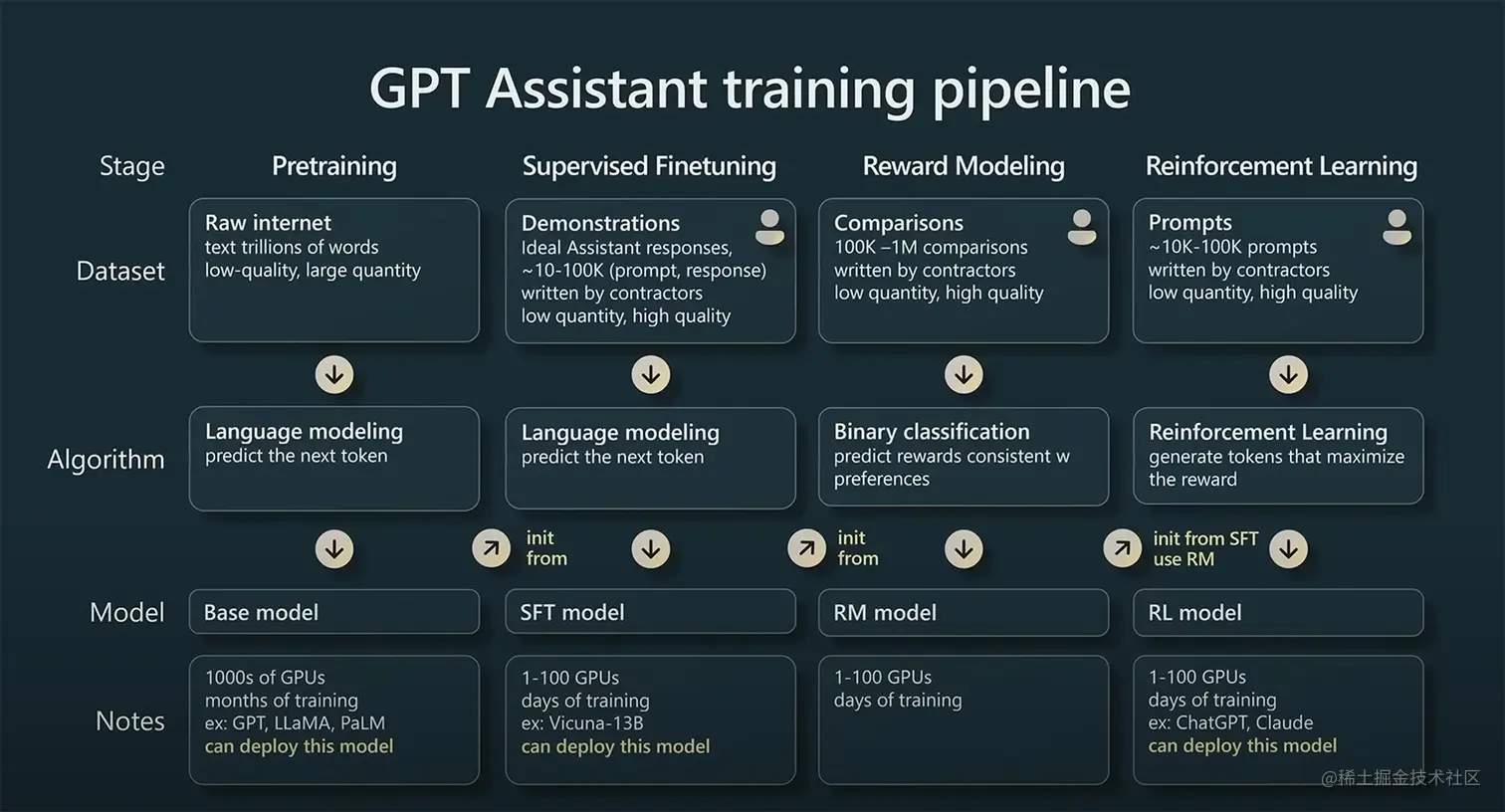

ModelBase Model在240万条中英文医疗数据集上SFT微调了一版Ziya-LLaMA-13B模型,医疗问答效果有提升,发布微调后的LoRA权重姜子牙通用大模型 V1 是基于 LLaMa 的 130 亿参数的大规模预训练模型,具备翻译,编程,文本分类,信息抽取,摘要,文案生成,常识问答和数学计算等能力。目前姜子牙通用大模型已完成大规模预训练、多任务有监督微调和人类反馈学习三阶段的训练过程

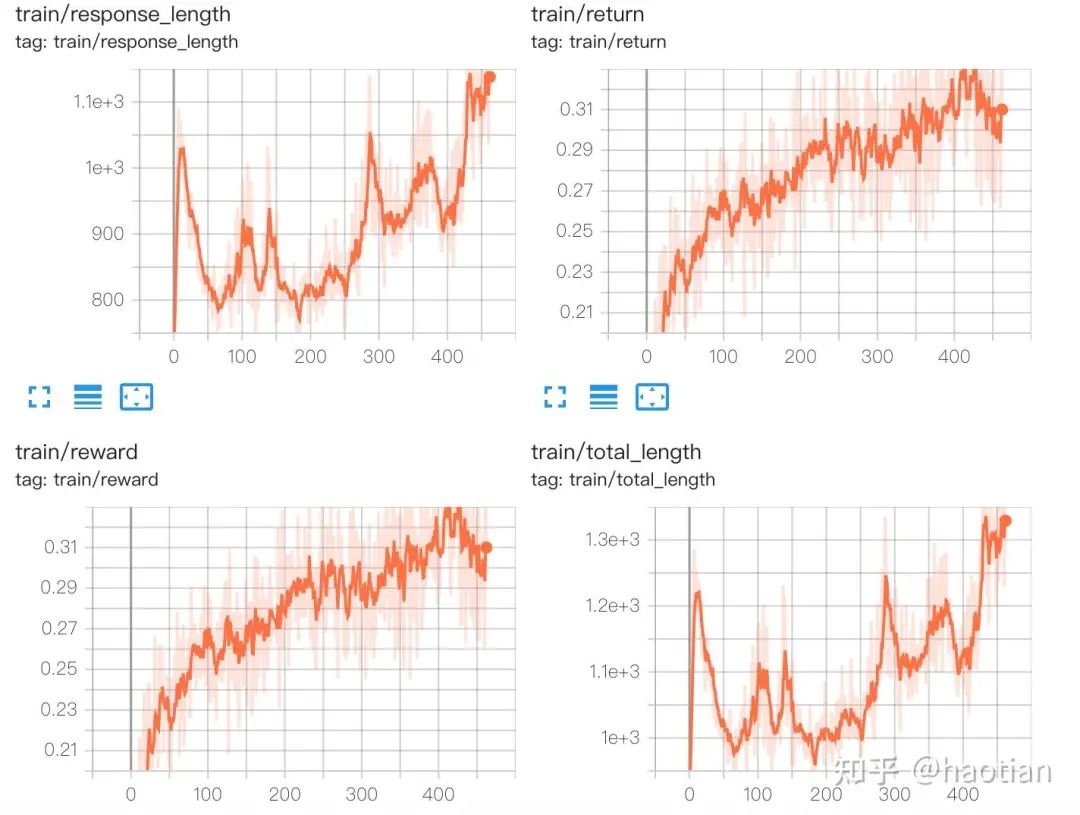

时常回顾经典,在新的base-model上,可能会有意想不到的效果。做成功的事情都是时机恰到好处。当然,结合环境交互的rl框架也是一个重要的技术方向。需要类似传统的游戏环境,能够和环境异步交互、生成中断等等,对llm的适配也带来一些挑战,也容易拉开各家rl的差距。没好的环境,基本上也做不出更强的推理、推理增强的agent模型。最后,除了rl方法外,其他一些生成模型的优化/采样方法(EBM的优化/采

Cherry Studio 是一个支持多服务商集成的 AI 对话客户端,CherryStudio 目前支持市面上绝大多数服务商的集成,并且支持多服务商的模型统一调度。官网地址: