简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Hey,各位科研大佬、技术宅们!今天,我得给大家讲讲一个超级劲爆的好消息!清华大学KVCache.AI团队联合趋境科技,居然把千亿级大模型DeepSeek-R1的推理门槛给“踢”了!你没听错,就是用咱们平时玩游戏的4090显卡,就能轻松搞定这个大家伙!😱但清华大学KVCache.AI团队和趋境科技做到了!他们不仅做到了,还开源了项目,让所有人都能用上。这操作,直接把AI圈的水搅得更热了!:之前,

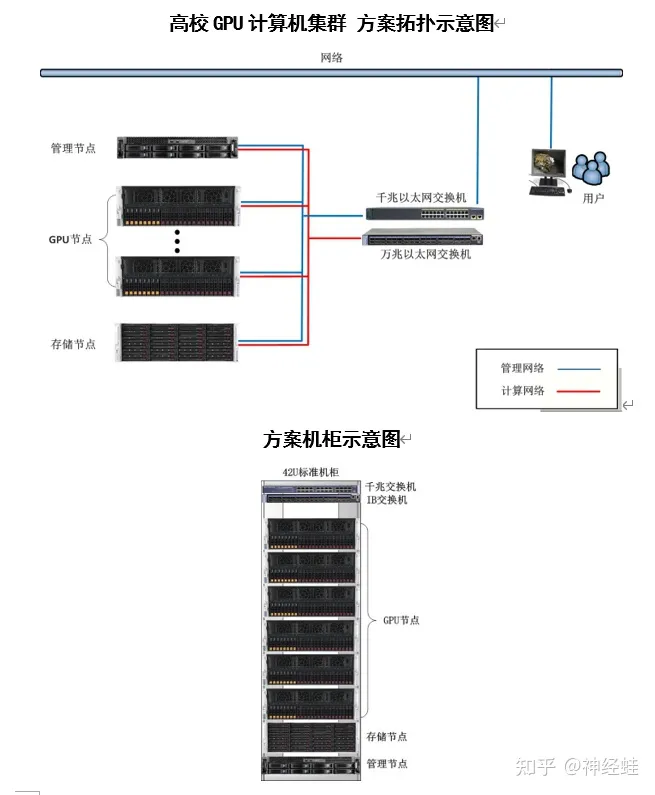

而集群的最大优势在于对故障服务器的监控是基于应用的,也就是说,只要服务器的应用停止运行,其它的相关服务器就会接管这个应用,而不必理会应用停止运行的原因是什么。高性能计算、深度学习集群服务器解决方案,提供标准的软硬件接口,支持分布式AI运算,可用于机器学习、人工智能和大数据开发等,相对传统的集群服务器,拥有低功耗、高可管理性、高灵活性等特点。集群系统可解决所有的服务器硬件故障,当某一台服务器出现任何

在HPC性能卓越计算中还必须依据精密度来挑选,例如有的性能卓越计算必须双精度,这时候假如应用RTX4090或是RTX A6000就不适合,只有应用H100或是A100;另外也会对显存容量有要求,例如石油或石化勘查类的计算运用对显卡内存要求较为高;还有一些对系统总线规范有要求,因而。下面推荐几款深度学习服务器。

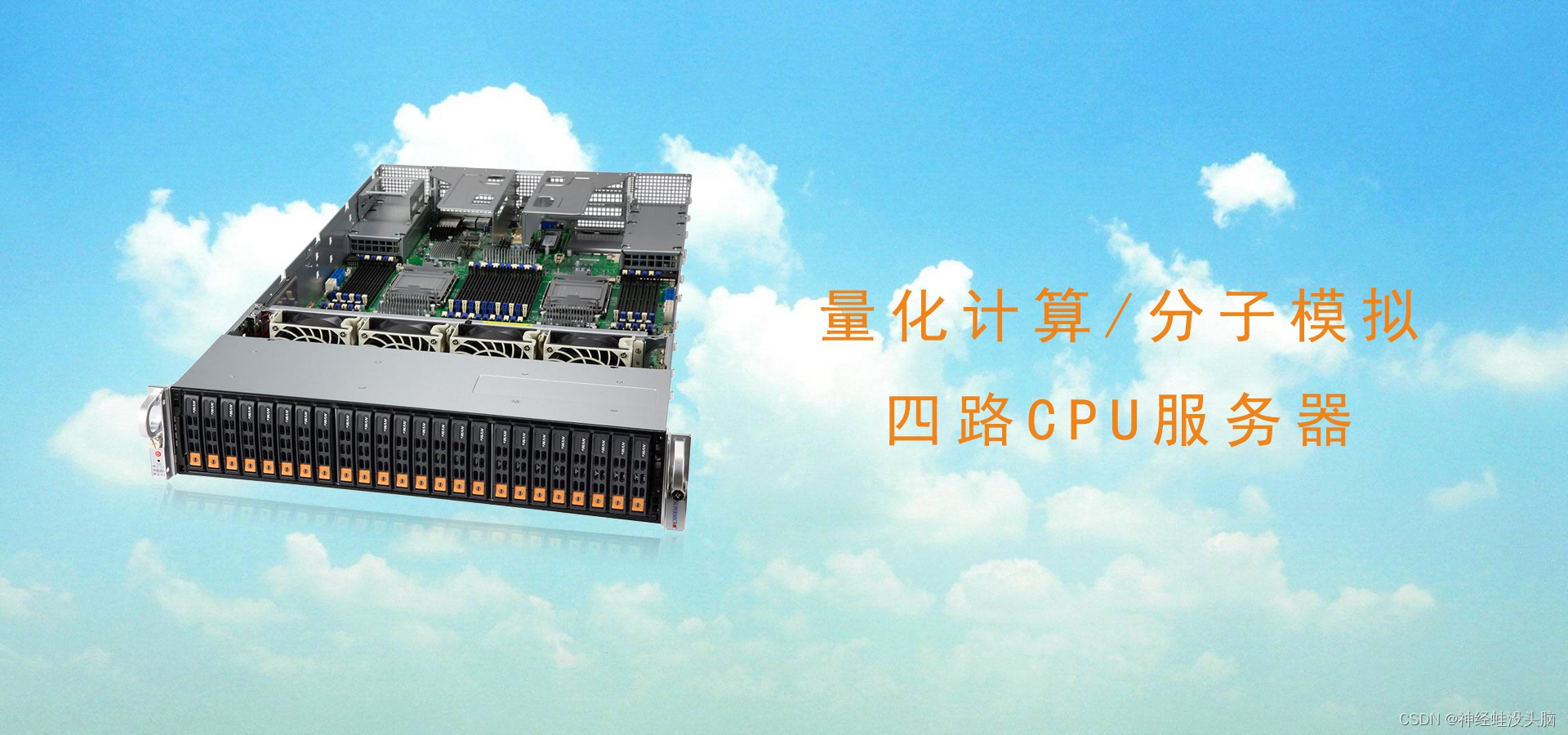

多数不用考虑GPU,但对CPU要求高,内存要求大,建议高核,大内存,如果追求性价比的话,可以选AMD的CPU。等主要强调GPU运算能力,存储空间要求往往很大,可以配置多块大空间硬盘,系统盘用SSD、存储用机械盘。,塔式比较安静,如果用GPU运算受卡数限制,4卡以内可以,液冷更静音。40系列相对性价比高,运算能力也不弱;:单双精度计算要求、显存、价格,,电源瓦数大于总功耗30%为宜;,空间大对散热有

如果要进行从头组装(例如Velvet),假设一个人的全基因组测序数据,采用二代测序的方法,人的基因组3G,10倍数据30G,那么这30G的碱基,在切成更小的kmer,假设数据增加到了100G,还不算存储序列的一些其他信息,序列拼接的时候必须一次将所有数据同时存入内存,如果内存达不到100G,拼接根本无法完成。生物信息学的研究材料和结果就是各种各样的生物学数据,其研究工具是计算机,研究方法包括对生物

立足上海服务全国,致力于打造国产科研服务器自主品牌,不断探索国人科研工具的自力更生之路,经过多年努力,我们已经成为专业的科学计算服务器、工作站、集群供应商,提供深度学习训练、量化计算、分子动力学模拟、计算生物信息学、计算流体力学、有限元分析等科研方向软硬件整体解决方案。最近一段时间,CPU两强第四代服务器级别处理器陆续上市,相对于上一代处理器来说,无论是性能、还是优化指令都有了很大提升,特别是在核

如果你可以为你的集群购买 RTX GPU:66% 的 8路RTX 4080 和 33% 的 8路RTX 4090(要确保能有效地冷却)。如果解决不了 RTX 4090 的冷却问题,那么可以购买 33% 的 RTX 6000 GPU 或 8路Tesla A100。任何专业绘图显卡(如Quadro 卡);进一步学习,卖掉你的 RTX 4070,并购买多路RTX 4090。根据下一步选择的领域(初创公司

适用于深度学习的GPU服务器配置过程中,大家一定会在市场上进行对比,往往会发现差不多的参数配置,甚至更高的参数配置价格会更低,这是怎么一回事呢?关于这个 问题,今天给大家举个例子,现在市场上有不少组装商家,为了赢得与客户的合作,往往会用客户满意的参数去吸引客户,殊不知参数并不能代表性能,而是性能的假象,这两天看到一个配置和大家分享一下:CPU:Intel Xeon **6148** 2.4 GHz

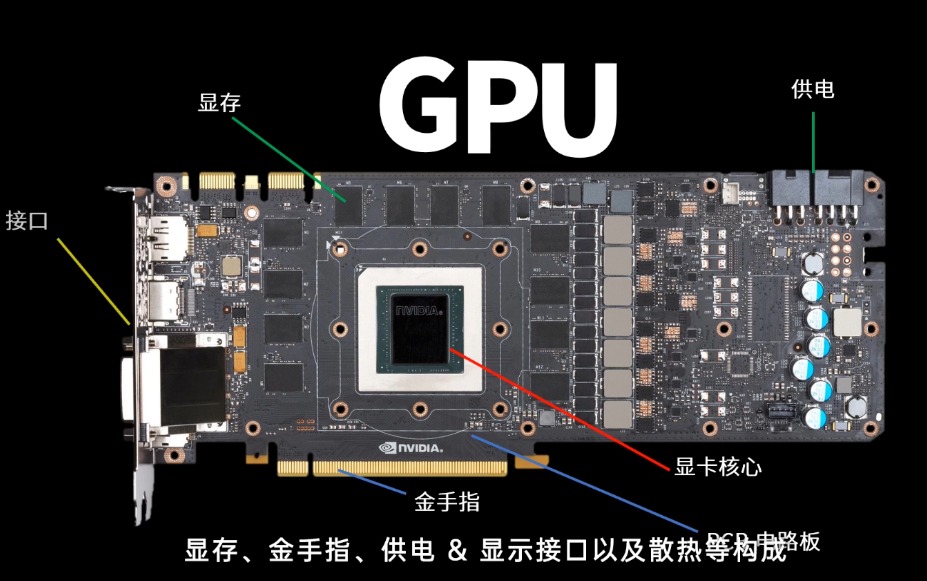

NVIDIA,作为GPU技术的领头羊,不断推陈出新,以其强大的计算能力和创新的技术解决方案引领着这一领域的发展。传统的GPU计算卡通常需要通过PCIe插槽安装在主板上,这不仅限制了计算卡的数量和密度,还增加了系统的复杂性和功耗。B100采用了NVIDIA最新的GPU架构,集成了大量的Tensor Cores和CUDA Cores,为深度学习、科学计算等任务提供了强大的计算能力。在显存方面,B100

这些包括更密集的解决方案、用于更多内核的基于 AMD 或 ARM 的 CPU 解决方案、不同的 Xeon SKU 级别、不同的 RAM 配置、不同的存储配置,甚至不同的 NIC。NVIDIA 还有其他主板,例如称为 Redstone 和 Restone Next 的 4x GPU 组件,但主要的 DGX/HGX (Next) 平台是使用 SXM 的 8x GPU 平台。对于最新一代的“Hopper