简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

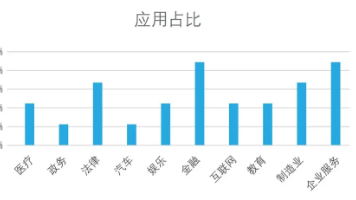

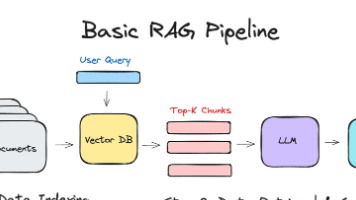

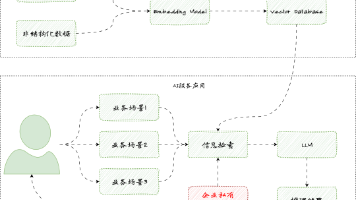

本文介绍了检索增强生成(RAG)技术,它通过结合实时数据检索和文本生成技术,提升决策效率并自动化业务流程。文章详细解析了RAG的工作原理,包括数据摄取、查询输入、检索、内容生成、后处理和输出交付等环节。此外,还探讨了RAG的核心优势,如提高准确性、提升决策效率、可扩展性和持续改进能力。文章还列举了RAG在客户支持自动化、内容创作、市场情报和销售营销等领域的应用场景。最后,文章提出了企业如何落地RA

本文深入探讨了如何通过Query重写、Step-back Prompting和Sub-query Decomposition这三大Query变形术,有效提升RAG(检索增强生成)系统的检索能力。文章指出,精准的提问是高效信息检索的关键,并详细阐述了每种变形术的原理、应用场景及伪代码实现。通过实战案例和评分对比,文章强调了Sub-query Decomposition在处理复杂问题时的优越性,并总结

本文详细介绍了RAG(检索增强生成)技术,包括其流程、文档分块策略、相似度计算方法及优化技巧。内容涵盖余弦相似度的优缺点、重排序技术、GraphRAG应用以及系统评估方法。文章还探讨了RAG的缺点及解决方案,旨在帮助读者深入理解RAG,提升大模型应用能力。

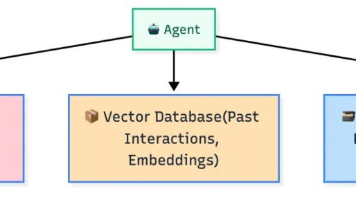

本文深入剖析了AI智能体记忆能力的核心运作机制,包括观察、记忆、行动、反思和更新记忆的闭环架构。文章详细介绍了AI智能体的记忆存储机制,如实时内存态、持久化日志和向量数据库,以及如何通过语义检索找到正确的记忆内容。此外,还探讨了AI智能体的反思与学习过程,以及不同类型的记忆(工作记忆、短期记忆、情景记忆、语义记忆和长期记忆)如何协同工作。最后,文章展望了AI智能体记忆技术的未来发展方向,并鼓励读者

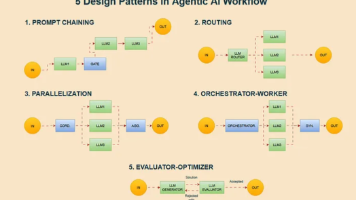

本文介绍了五种关键AI工作流模式:提示链、路由、并行化、指挥者-工作者以及评估器-优化器,这些模式帮助开发者有效编排LLM调用与工具,构建复杂、健壮的智能体系统。文章强调了模块化设计对系统维护、成本控制和扩展性的重要性,并推荐了如LangChain、CrewAI等现代框架,帮助开发者聚焦业务逻辑,快速搭建智能体应用原型。掌握这些模式对于设计出更智能、可扩展的AI系统至关重要。

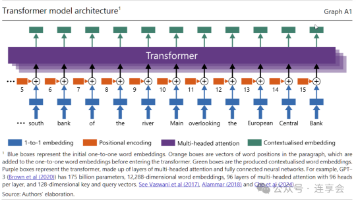

大语言模型是自然语言处理领域的重大突破,能将非结构化数据如文字转化为数学结构,广泛应用于情感分析、翻译等场景。本文为社会科学研究者提供了大语言模型的应用指南,涵盖模型选择、数据处理、主题建模和量化分析等方面。通过实例分析美国股价变化的驱动因素,展示了如何利用大语言模型进行科研工作。文章强调了资源规划、模块化流程和重复操作的重要性,并提醒研究者注意数据隐私保护。对于想要学习大模型技术的程序员来说,本

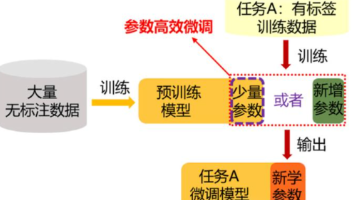

大模型训练的难点并非算力或模型复杂度,而是训练数据的收集与处理。本文指出,虽然开源模型提供了基础架构和算法,但如何获取、整理符合需求的大量数据是关键挑战。文章强调,对于使用开源模型进行训练的人来说,数据收集比模型调整更为重要,并以此类比于“造原子弹”需要关键原料。学习大模型技术对个人职业发展具有重要意义,相关岗位需求日益增加。

本文深入探讨了RAG应用中至关重要的文本分块技术,阐述了其如何通过提升检索相关性、优化效率、保障生成质量及适配长文档处理,全面影响RAG系统的性能。文章详细解析了Spring AI中的TokenTextSplitter和SentenceSplitter两种主流分块策略,并介绍了固定长度、递归分块、按结构及按标点等多种实用分块方法,为开发者提供了全面的文本分块实践指导,助力小白程序员快速入门并精通大

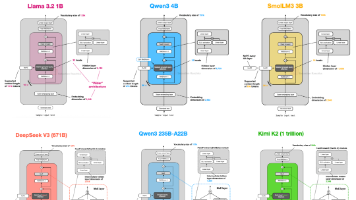

本文详细对比了 llama-3.2、Qwen3-4B、SmolLM3-3B、DeepSeek-V3、Qwen3-235B-A22B 和 Kimi-K2 等大型语言模型的架构,探讨了它们之间的区别和优势。文章重点关注架构设计,如 DeepSeek-V3 的多头潜在注意力 (MLA) 和专家混合 (MoE),OLMo 2 的归一化层位置和 QK-范数,Gemma 3 的滑动窗口注意力等。对于想深入了解

本文介绍了检索增强生成(RAG)的概念及其工作原理,旨在解决大型语言模型在处理专有、快速更新数据时的不足。文章详细阐述了如何使用LangChain、OpenAI语言模型和Weaviate矢量数据库实现RAG管道,通过检索外部知识源来增强LLM的生成能力,减少模型幻觉。此外,还讨论了学习大模型技术的重要性及其在多个领域的应用,鼓励读者抓住AI大模型的风口,提升自身竞争力。