简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

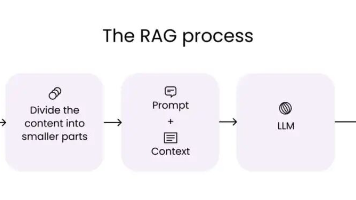

想象一下,你新招了一位天才员工,他博闻强识(预训练模型),但记忆力极差,且知识停留在去年(训练数据截止)。公司最新的产品手册、客户协议,他一概不知。RAG就像是给这位天才配了一个随身文件柜(知识库)和一个高效秘书(检索系统)。每当员工需要回答问题时,秘书会迅速从文件柜中找出相关文件,员工结合这些最新资料,给出准确答复。技术定义:RAG通过让大模型在生成答案前,检索并参考外部知识源,来优化其输出。它

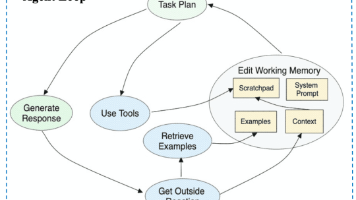

敏叔,我的Agent怎么老是干不好活?像个智障一样!这个问题我可太有感触了。一开始我也觉得,不就是给Agent配几个工具嘛,能有多难?结果用下来之后发现,Agent Skills(技能)这玩意儿,配置好了是智能助手,配置不好就真成“智障”助手了。今天我就把踩过的坑、总结的经验一次性倒出来,带你彻底搞懂Agent Skills到底该怎么玩,怎么让你的Agent真正“聪明”起来。说人话,Agent S

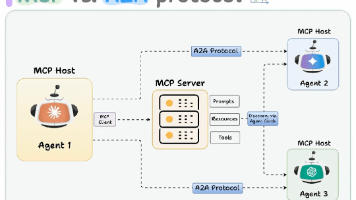

在2026年,MCP已成为Agent基础设施的基石,比如在电商Agent中调用支付API,或研究Agent查询数据库。没有MCP,早期的工具调用很乱(每个模型格式不同),现在统一后,开发效率提升3倍以上。它常与A2A结合:Agent间协作时,用MCP调用底层工具。这张是MCP最经典的架构分解图:图中左侧是运行了LLM应用的MCP Host,通过MCP Client发出标准化请求;中间是上下文管理器

几年前被公司裁掉之后,赖利蔡斯开始决定自己单干,于是他一边疯狂地学习,阅读了《百万富翁快车道》学会了如何通过产品或软件业务将时间和金钱分开,读了《Built to Sell》《The E-Myth Revisited》,学习了如何做生意,如何运营。哪怕他已经实现了财富自己,但还是会经常写Python代码。刚开始他开发、营销、销售和会计什么都做,后来拥有了几个专职人员,2020年开始招聘组建了整个公

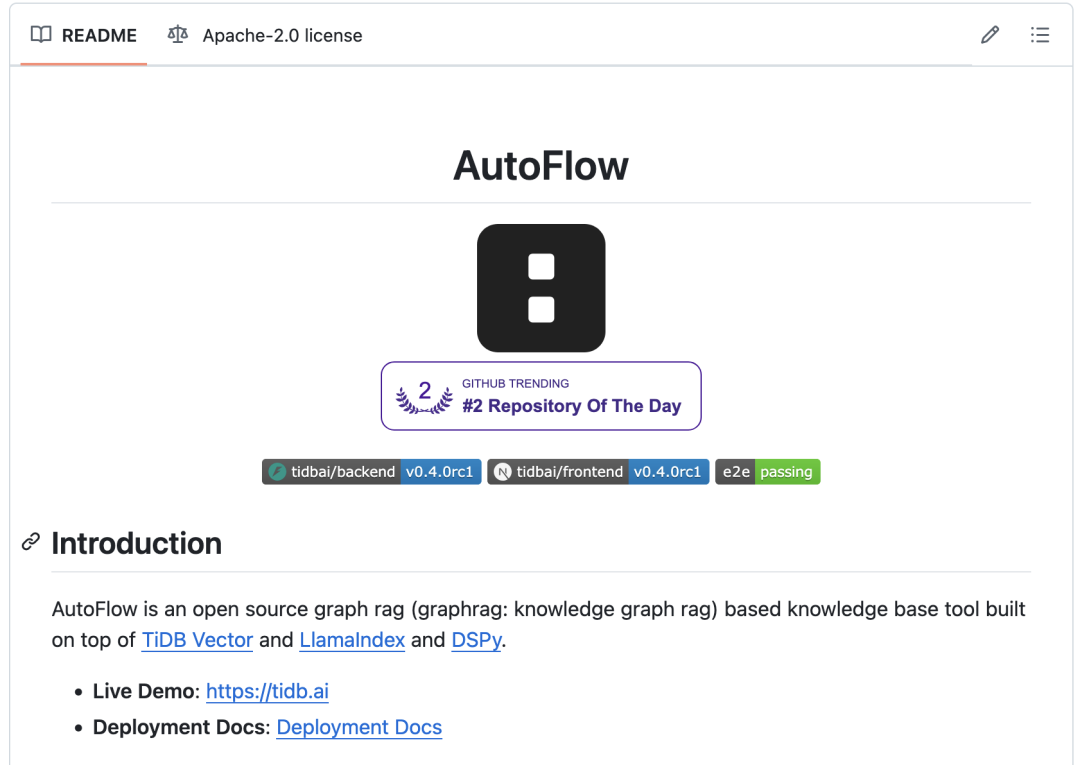

AutoFlow是 PingCAP 开源的一个基于LlamaIndex和DSPy构建的 Graph RAG 知识库工具,可以让开发者快速构建一个对话式知识库聊天助手,现已在 GitHub 正式开源。在AutoFlow的0.4.0版本中,。马建仓看到本次更新后也是迫不及待上手实践,最终实现了一行代码没写,快速搭建出了一个基于本地知识库的问答机器人,那么下面就和马建仓一起开始吧!

在本教程中,我们将详细探讨。

ModelScope是一个由阿里巴巴集团推出的开源模型即服务(MaaS)平台,旨在简化模型应用的过程,为AI开发者提供灵活、易用、低成本的一站式模型服务产品。该平台汇集了多种最先进的机器学习模型,涵盖自然语言处理、计算机视觉、语音识别等多个领域,并提供丰富的API接口和工具,使开发人员能够轻松地集成和使用这些模型。官方网站。

嘿,大家好!这里是一个专注于AI智能体的频道~DeepSeek刚刚又发补给了,补给4件套。包含2个配置项,不要设置system prompt + temperature 设置为0.6。还有大家比较期待的官网的,接入搜索的R1的prompt设计及最佳用法!以及如何缓解R1系列模型绕过思考的解决办法。在DeepSeek 官网版本,没有使用系统提示词,而是为文件上传和网络搜索设计了两个特定的提示词以获得

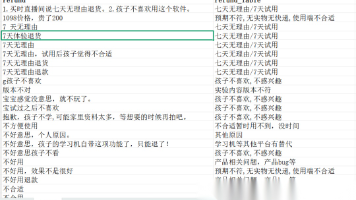

本文详细介绍了使用Dify平台调用DeepSeek-V3大语言模型,对电商退款原因进行智能分类的完整流程。包括创建知识库、构建应用工作流、配置提示词、测试发布及批量运行等步骤,展示了大语言模型在文本分类任务中的实际应用价值,为开发者提供了可复现的实战案例。在电商领域的数据分析中,经常需要对一些文本进行分类统计,比如对用户填写的各类原因进行归类。

随着 AI Agent(智能体)技术的爆发,未来我们也必将从“人与 AI 对话”的时代迈向“AI 与 AI 协作”的时代。然而,目前的 Agent 大多像是“独行侠”——它们各自拥有相关的专业能力,却很难跨越框架、跨越服务器进行协作。而Google 发布的为了解决这类问题。其作用未来或许可以和Anthropic 推出的— 1 什么是 A2A (Agent2Agent) 协议?准化 AI Agent