简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

💥💥💞💞❤️❤️💥💥博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。⛳️行百里者,半于九十。📋📋📋🎁🎁🎁。

近年来,随着能源短缺和环境问题的日益凸显,太阳能、风能等各种形式的清洁能源得到广泛应用,微网作为分布式电源接入电网的有效途径得到快速发展"。大量的新能源以及储能装置接入给微网带来能量调度复杂以及经济性低等问题。本文参考了模糊算法预测电价。基于模糊神经网络(Fuzzy Neural Network, FNN)算法预测电价是一种将模糊逻辑与神经网络相结合的方法,旨在提高预测模型的准确性和鲁棒性。

微电网系统可将多种类型的分布式发电单元组合在一起,有效发挥单一能源系统的优点,实现多种能源互补,提高整个微电网系统的效率、能源利用率和供电可靠性。根据其是否与常规电网相连接,微电网可以分为并网型微电网和独立型微电网[1]。微电网接入配电网并网运行,不仅可以充分利用微电网内部的绿色可再生能源,还可以提高整个电网的安全性,是中国建成智能电网的重要环节。同时,独立型微电网系统是解决偏远地区和海岛供电的有

虽然“十三五”期间要求大力发展配电自动力化水平,提高配电网的投资力度,但是配电网络结构日益复杂多变,工厂生产和居民用电上升尤其分布式发电技术的不断渗透,使配电系统发生故障、工厂居民停电的问题时有发生。(1)电网稳定性差:供电的稳定性受电网各个部分影响,因配电系统与负荷是直接相连的,生产生活中大部分的居民都是使用单电源供电,如果某段线路出现故障,因没有备用电源供电,则不能及时的转供电会导致停电时间变

山地环境的地形复杂性、动态障碍物和气象干扰显著增加路径规划难度:F=w1⋅长度成本+w2⋅碰撞风险+w3⋅高度惩罚其中权重 wk 平衡多目标。总成本函数设计为:权重 bk 依任务调整(如搜救任务侧重安全 b2↑) 。遗传算法通过多目标优化与全局搜索能力,成为复杂山地无人机路径规划的有效工具。其性能依赖精细的环境建模(DEM+动态威胁)、合理的约束整合(高度/转弯半径)及改进策略(精英保留+混合算

图像处理是计算机视觉和图像分析领域的一个重要组成部分,旨在改善图像质量、提取有用信息或进行特定的变换。

PSO(Particle Swarm Optimization,粒子群优化)无人机路径规划在3D城市环境中的应用,是一种利用粒子群优化算法进行无人机路径规划的方法。该方法结合了PSO算法的搜索和优化能力,以及无人机在三维城市环境中的路径规划需求,旨在找到一条从起点到终点的最优或满意路径,同时避开城市中的建筑物、地形障碍等,并考虑飞行时间、能源消耗等因素。

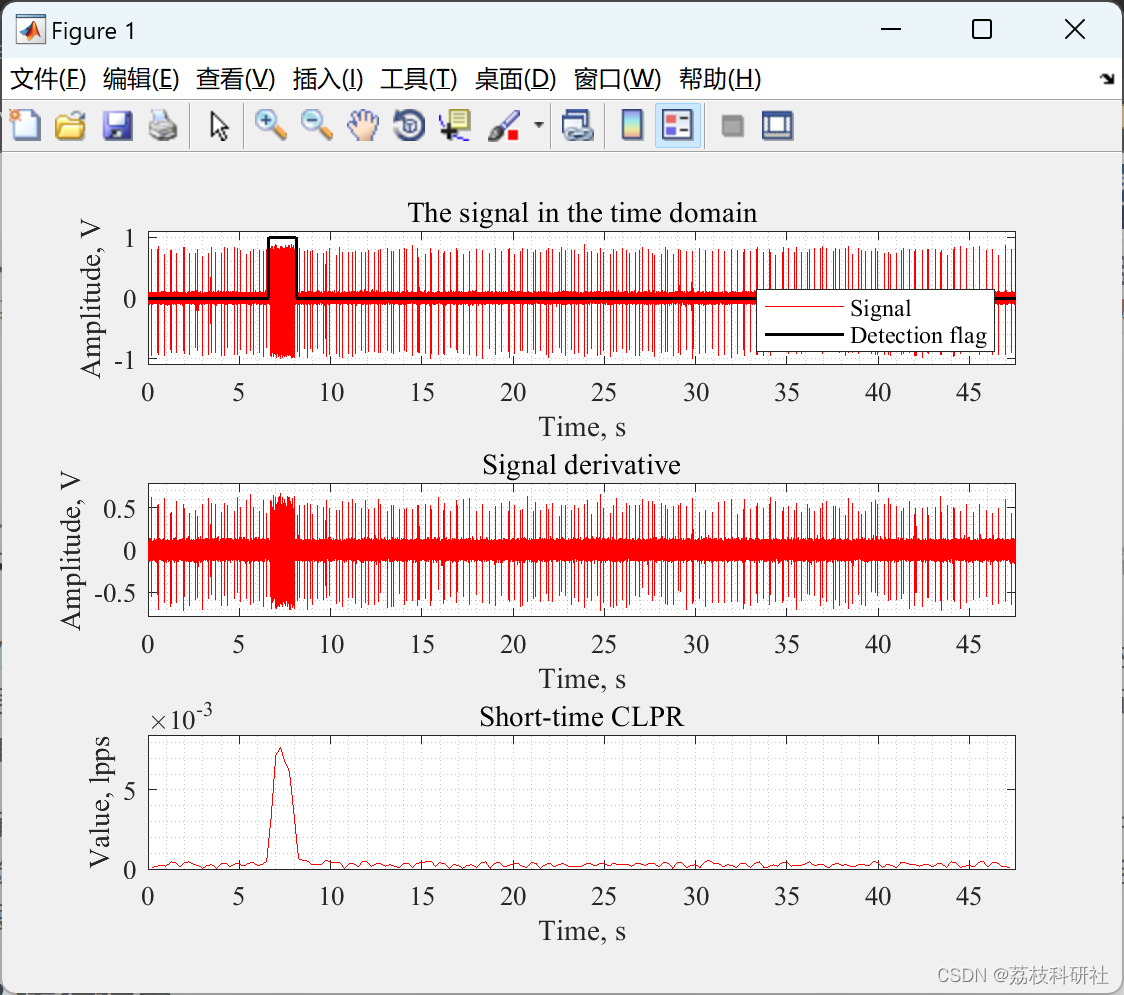

将该方法与基于短时能量、短时过零率和短时峰度的三种经典检测方法进行了性能比较,结果表明了该方法的优越性。Matlab®实现的可访问性允许实验的可重复性,并促进该方法的实际应用。本文使用逐帧方法和名为“条件局部峰值速率”(CLPR) 的新颖信号特征实现了一种新的基于时域的信号变化检测方法——本地信号峰值的速率高于其邻居的某个预定义阈值水平。这些例子表明,在大多数情况下,CLPR优于经典的变化检测方法

首先,需要明确无人机路径规划的具体目标,例如最短路径、最低能耗、最大覆盖区域或在有限时间内到达多个目标点等。同时,确定约束条件,包括飞行器的性能限制(如最大速度、加速度、转弯半径)、飞行空域的限制以及需要避免的静态或动态障碍物。

它将机器人周围的环境建模为一个势能场,并利用势能场的梯度来引导机器人朝向目标位置移动。机器人受到两种力的作用:一种是来自目标位置的引力,另一种是来自障碍物的斥力。根据机器人当前位置和目标位置以及环境中的障碍物位置,计算每个点的势能值。对于机器人当前位置,计算受到的总合力,即引力和斥力的合成。根据合力的方向和大小,更新机器人的位置。通常采用迭代的方式,多次更新机器人的位置,直到达到目标位置或达到最大