简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

接下来,定义大模型交互逻辑接口。首先需要明确,需要执行操作的过程是:大模型识别到用户的意图中需要调用工具,那么其停留的阶段一定是在 Action:xxxx : xxxx 阶段,其中第一个 xxx,就是调用的函数名称,第二个 xxxx,就是调用第一个 xxxx 函数时,需要传递的参数。就目前的AI Agent 现状而言,流行的代理框架都有内置的 ReAct 代理,比如Langchain、LlamaI

*在这一事件中,增量更新的是大模型输出的参数`arguments`,这个参数中的内容是用于执行外部函数的,而非对“北京现在的天气怎么样?正如我们在上节课中介绍的,使用.beta.threads.runs.submit_tool_outputs方法用于提交外部工具的输出,此方法也支持流媒体输出,如果在这个阶段需要开启流媒体传输,我们就需要使用 stream=True 参数来明确指定。为了使第二个`R

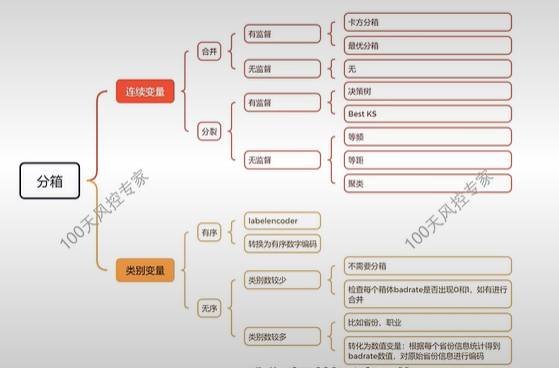

策略为主,模型为辅:重点在于分群,比如收入、多头分群,模型作为一个工具,不用追求可解释性,作用是继续扩大收益。规则面:规则上线,转正的规则内部对比看其坏客户有没有被其他规则覆盖,拒绝的客户能不能回捞,分类归纳。原则:分群后风险水平的差异、分群后客户数据维度的差别性、分群后的分布稳定性、分群的可解释性。规则越少越好,先设计一个MVP,摸清客群,再迭代,不确定的规则可以离线观测。6.制定策略:规则挖掘

其中,tools告知模型可以用哪些参数,tool_choice告知模型是否可以用tools,一般设置为auto。解决方法:autogpt项目:调用外部工具解决,由此衍生出ai agent:能接入外部工具的ai。model=\ glm-4\ ,# 填写需要调用的模型名称。两个研究方向:开发特定的agents/强化大模型在某个领域的能力,后一个的大致方法如下图。参数的写法如上图所示,需要三个变量。前面

Class_weight:输入{0:1,1:3}则代表1类样本的每条数据在计算损失函数时都会*3,当输入balanced,则调整为真实样本比例的反比,以达到平衡,但实际情况中不常用。#UI多迭代10的6次方次,tol是优化算法的收敛容忍度,c是正则化项参数。pl1.fit(x_train,y_train)#直接fit会报错,要改变求解器为saga。score_l1#打印发现degree=3是最优解

kaggle竞赛之捷信金融违约预测竞赛-part1-数据探索及baseline建立

Choice(finish_reason='stop', index=0, logprobs=None, message=ChatCompletionMessage(content='你好!\\n', role='assistant', function_call=None, tool_calls=None))在代码环境中,ollama则提供了openai API风格的大模型调用方法。{'role

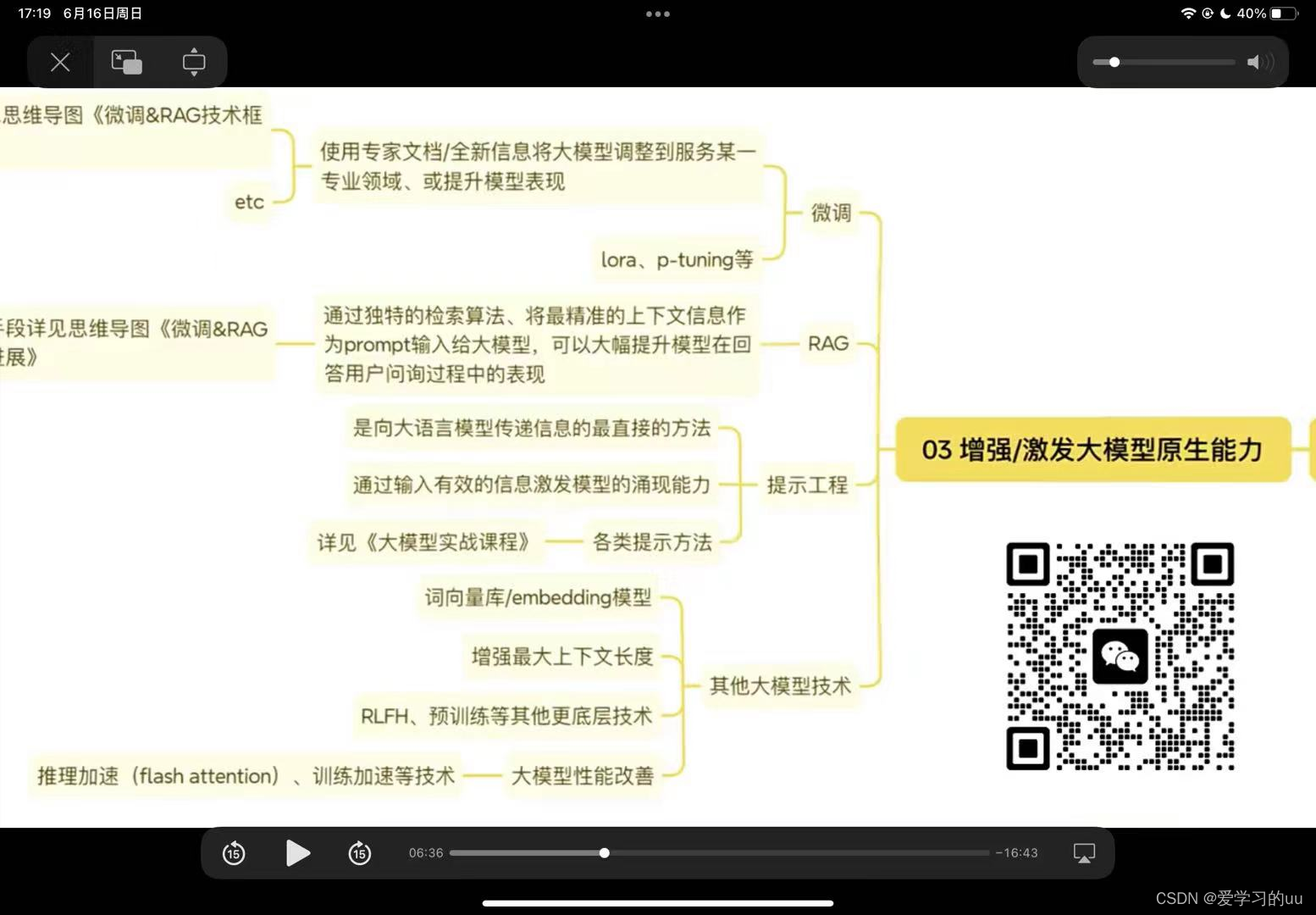

而大模型微调又分为全量微调和高效微调两种,所谓全量微调,指的是调整大模型的全部参数,而高效微调,则指的是调整大模型的部分参数,目前常用的高效微调方法包括LoRA、QLoRA、p-Tunning、Prefix-tunning等。这是模型保存和检查点创建的频率,允许你在训练过程中定期保存模型的状态,--model_name_or_path /mnt/workspace/.cache/modelscop

一.模型设计:需要考虑模型细分,样本选取(样本排除:观察期排除和表现期排除;观察期:产品(特殊产品如学生卡)/客群(VIP)/政策(年龄/无人行/欺诈等)/风险异常(如业务风险异常波动的时点,即某个月份坏账率较大的要排掉)评价标准:F检验(检验模型的整体显著性)/t检验(检验模型各个系数的显著性)/AIC/BIC(后两个均是衡量统计模型拟合优良性的一种标准)模型复杂度增大k增大,L也增大,AIC减

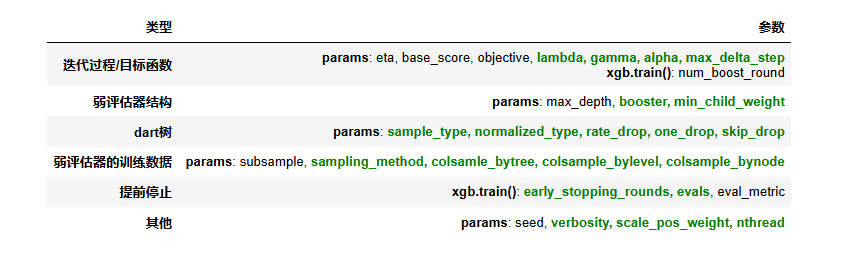

2.在GBDT中影响力巨大的max_features对标XGBoost中的colsample_by*系列参数,原则上来说影响力应该非常大,但由于三个参数共同作用,调参难度较高,在只有1个参数作用时效果略逊于max_features。对于取值可大可小,且原则上可取到无穷值的参数(num_boost_round,gamma、lambda、min_child_weight等),一般需要绘制学习曲线进行提