简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

围绕着数字化,华为在基础软件领域,已发布欧拉和鸿蒙操作系统、毕昇编译器、高斯数据库、昇思AI框架等,并将OpenEuler(欧拉)、OpenHarmony贡献给开放原子开源基金会,通过软件开源发展产业生态。孟晚舟表示,2026年全球数字化转型支出将达到3.4万亿美元,这是整个产业链的新蓝海,无论是正在进行数字化转型的企业,还是支撑数字化转型的企业,均面临巨大的市场空间和经济收益。孟晚舟表示,就任轮

2. 模型跟前作DiT比可能变化不大,但使用了几百倍的算力。这个模型基于的ViT,DALL·E,diffusionmethods,和VAE我们之前都讲过。等大家对缺失的技术有了一定探索了,我们再来讲一下这个工作。整理了Sora相关的32篇论文,以及沐神解读VIT,DALL·E,diffusion model等论文的逐行精读:https://datawhaler.feishu.cn/wiki/EEn

发言人的声明中如此表示:「我们认为,我们内部开发的加速器与市面上的 GPU 有很强的互补性,可以在 Meta 特定的工作负载上提供性能和效率的最佳组合。在开源 AI 大模型上的突飞猛进,加上算力等方面的积极动作,Meta 在科技圈的形象正在重塑。过去这段日子,Meta 在人工智能领域的表现毫不逊色:生成式人工智能大语言模型 Llama 可与 OpenAI 和谷歌的模型竞争,Meta 同时在寻求将人

华为在最底层构建了以鲲鹏和昇腾为基础的AI算力云平台,以及异构计算架构CANN、全场景AI框架昇思MindSpore,AI开发生产线ModelArts等,能为大模型开发和运行提供分布式并行加速,算子和编译优化、集群级通信优化等关键能力。在L0和L1大模型的基础上,华为云还提供了大模型行业开发套件,通过对自有数据二次训练,就可以拥有自己的专属行业大模型。同时,根据客户不同的数据安全与合规诉求,盘古大

因此,如果想要迈向下一步的突破,需要千倍甚至更多的算力支持。比如Bing上的图像大部分都有标签,是基本可以理解的,但对于些抽象的图片,如抠图和实时路面信息等,这些边缘Case在Bing上的图片库就无法支撑,因为它们仅包含原始图像,没有进行大量的抠图和其他标注,所以当前面临的问题是这些原始图像无法满足GPT模型的要求,准确率无法达到标准。B端是结合不同行业的应用场景,比如一些公司和客服机构需要处理大

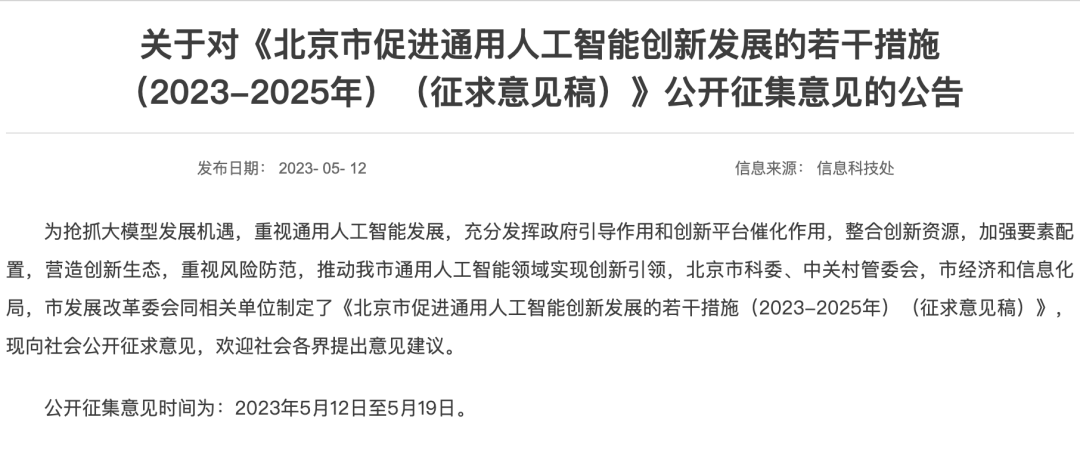

智东西5月16日消息,近日,《北京市促进通用人工智能创新发展的若干措施(2023-2025年)(征求意见稿)》(简称:“措施”)公布,从算力、数据、算法、应用、监管五大方向,对北京大模型发展提出了21项措施,于5月12日至5月19日面向公众征集意见。支持我市能源、材料、生物领域相关实验室设立科研合作专项,与我市相关科研机构和创新企业开展联合研发,充分挖掘材料、蛋白质和分子药物领域实验数据,研发科学

本资源收录了机器学习课程用到的相关术语,涉及机器学习基础、机器学习理论、Applied Math、SVM、Ensemble、DNN、Regularization、Matrix Factorization、Optimization、CNN、 Auto Encoder、RNN、Representation、Network Embedding、GAN、Adversarial Learning、Onlin

Ilya Sutskever是2012年开启深度学习时代的AlexNet作者之一,也是AlphaGo作者之一,此前已将AI对齐作为他的核心研究重点,总引用数超过40万。认同的学者表示:自然智能通过竞争的进化奖励产生,AI通过对齐人类利益的进化奖励产生,并期待未来的效果。为了在人类难以评估的任务上提供训练信号,需要利用AI来协助评估其他AI系统,称为“可扩展的监督”。通过故意训练不对齐的模型来测试整

本文为译文,原文地址:https://medium.com/@datamonsters/artificial-neural-networks-in-natural-language-processing-bcf62aa9151a由于人工神经网络可以对非线性过程进行建模,因此已经成为解决诸如分类,聚类,回归,模式识别,维度简化,结构化预测,机器翻译,异常检测,决策可视化,计算机视觉和其他许多