简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

官方文档:https://developer.download.nvidia.cn/compute/DCGM/docs/nvidia-smi-367.38.pdfNVIDIA-SMI系列命令总结

onnx 和 nvidia cuda, nvidia cudnn 之间对应关系。

官方文档:https://developer.download.nvidia.cn/compute/DCGM/docs/nvidia-smi-367.38.pdfNVIDIA-SMI系列命令总结

在集成过程中,需要修改package.json 和 Podfile,按文档中的内容,如果pod install过不了的话,先修改package.json,然后执行命名。再修改Podfile,执行命令。

需要安装官方nccl。

百度了一下,有推荐这么改的,速度还是慢,因为还是转到官网 pytorch.org。最终采用 其中的版本 2.3.1,可以看看 pip 源。默认安装,速度比较慢。

AWQ(激活感知权重量化),它是一种类似于GPTQ的量化方法。所以他们的论文提到了与GPTQ相比的可以由显著加速,同时保持了相似的,有时甚至更好的性能。GGUF(以前称为GGML)是一种量化方法,允许用户使用CPU来运行LLM,但也可以将其某些层加载到GPU以提高速度。虽然使用CPU进行推理通常比使用GPU慢,但对于那些在CPU或苹果设备上运行模型的人来说,这是一种非常好的格式。GPTQ是一种4位

【代码】React native RN 开发实例。

检查 onnxruntime和 cuda 和 cudnn 的版本对应关。检查安装的 onnx。

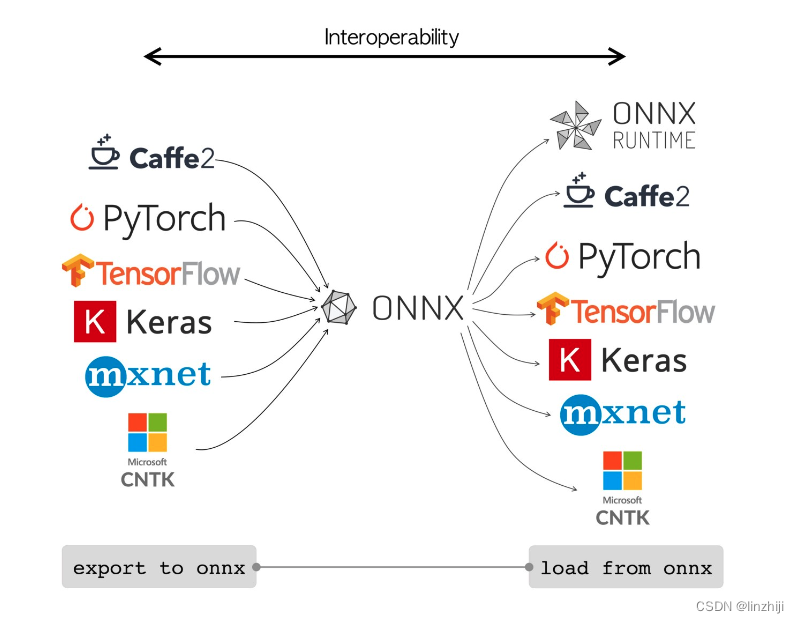

(和Java生成的中间文件可以在JVM上运行一样,onnx runtime引擎为生成的onnx模型文件提供推理功能)在训练模型时可以使用很多不同的框架,比如 Pytorch, TensorFLow, MXNet,以及深度学习最开始流行的 Caffe 等等,这样不同的训练框架就导致了产生不同的模型结果包,在模型进行部署推理时就需要不同的依赖库,而且同一个框架比如 tensorflow 不同的版本之间