简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

公司有多台AI服务器,最近几台服务器在执行nvidia-smi命令时,非常慢,要等5-6秒才能执行成功,翻了系统日志也没找到任何异常,最后发现,原来是显卡切换到了节能模式,只需关闭节能模式,切换到持久模式即可。系统重启后,大概率又会变成节能模式,只需要在系统引导时自动启用NVIDIA持久性模式即可。

导出视频仅1K,原因是我在目标识别过程中把图片宽高改成960x540,所以导出时也要保持一致!

【代码】使用阿里云的SpeechSynthesizer实现语音合成。

【代码】Failed to build scipy59.56 ERROR: Could not build wheels for scipy, which is required to install py。

那Top-1 Accuracy和Top-5 Accuracy是指什么呢?我们知道ImageNet有大概1000个分类,而模型预测某张图片时,会给出1000个按概率从高到低的类别排名,所谓的Top-1 Accuracy是指排名第一的类别与实际结果相符的准确率,而Top-5 Accuracy是指排名前五的类别包含实际结果的准确率。

【代码】api调用阿里云的千问大模型。

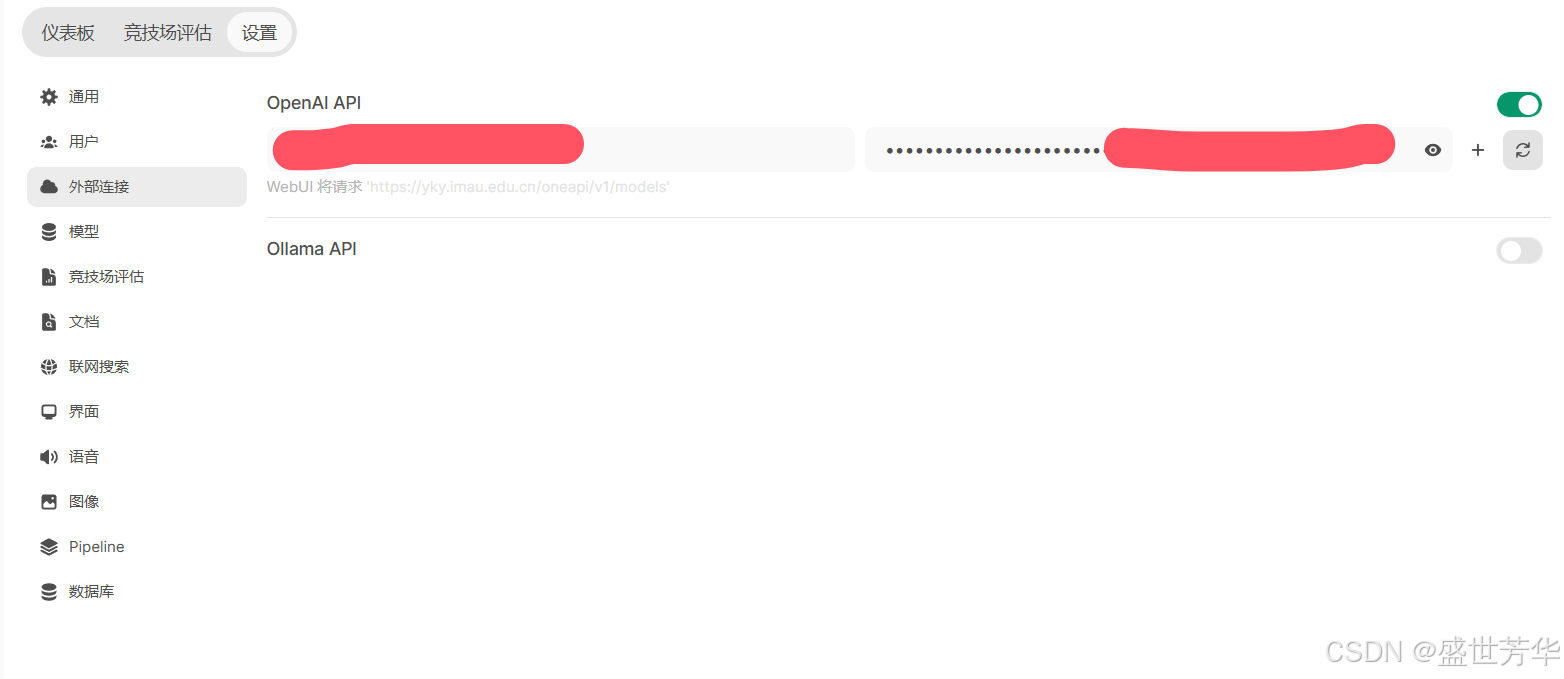

参考:【免费外语陪练】open-webui+oneapi连接在线大模型(通义等) - 哔哩哔哩

【代码】swift多卡微调提示Error: mkl-service + Intel(R) MKL: MKL_THREADING_LAYER=INTEL is incompatible with libgomp。

【代码】api调用阿里云的千问大模型。

最近公司多台AI服务器在训练过程中出现各自显卡报错,找不到原因,最后猜测是电源或功率太大造成的,用的是rtx3090,最后锁住功率,正常了!