简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模

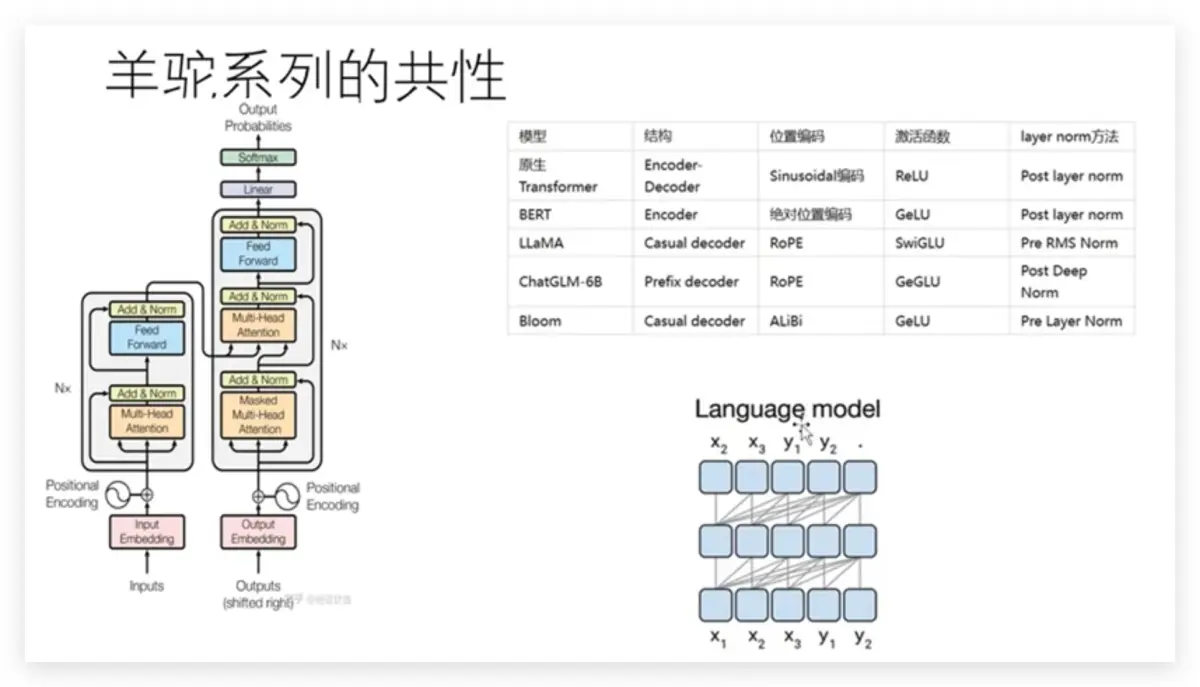

自2018年BERT发布以来,“预训练+微调”成为语言模型的通用范式。以ChatGPT为代表的大语言模型针对不同任务构造Prompt来训练,本质上仍然是预训练与微调的使用范式。千亿规模的参数微调需要大量算力,即使提供了预训练的基座模型,一般的研究机构也很难对其进行全量微调(即对所有参数进行微调)。为了应对这个问题,相关学者提出了PEFT(Parameter-Efficient Fine-Tunin

什么?炼个大模型还嫌贵?到底哪里贵了!??争先恐后训练大模型,搞得现在“算力慌”“一卡难求”,算力当然水涨船高了!“特供版”GPU又贵又缩水,大家自己愿意当“冤大头”囤卡,还好意思埋怨贵了?这么多年有没有认真工作?为什么这么多算力还依赖进口!自己为什么不能制造芯片?有没有在自主化上想想办法?数据需要存,接入AI模型需要网,部署AI模型需要终端。哪个不需要投入了!任何一个地方出现短板,就会出现木桶效

2023年,让整个人类最为振奋的AI技术就是ChatGPT。“大语言模型(Large Language Model)”这个词也随之映入人们的眼帘。ChatGPT让人觉得惊艳之处,能够结合上下文,像人一样有逻辑性地回答问题,就算生成超长的文本也不会跑偏。)是一种机器学习算法,它可以根据给定文本来预测下一个词语或字符的出现的概率,通过大量的文本数据来学习语言的统计特征,进而生成具有相似统计特征的新文本

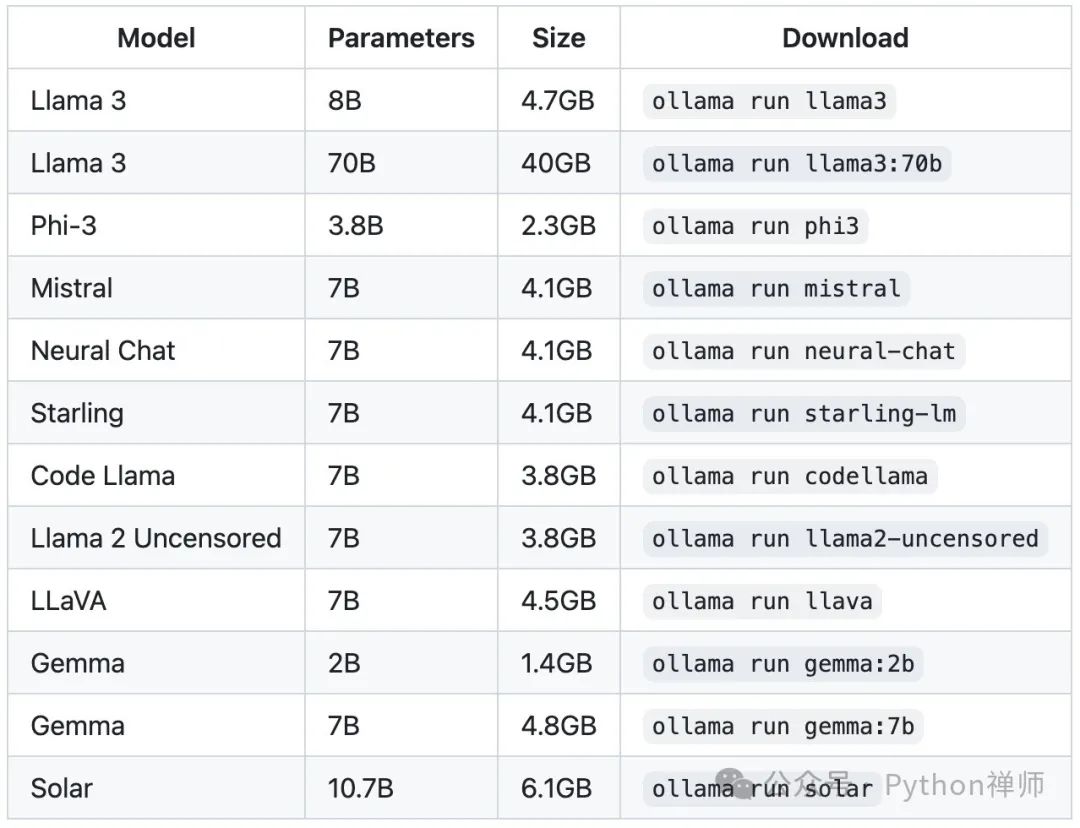

你可以根据特定的用例,通过微调大型语言模型的方式定制现有通用模型。为了更高效地微调模型,你可以考虑使用 LoRA 或模型分片(使用FSDP等框架)等技术。Modal的Llama和Mistral微调模板实现了许多这类的技术,能够帮助你快速启动分布式训练任务。你可以通过在 Modal 上微调 Llama 2 或Mistral 等开源模型获得一个定制的模型,这样不仅成本和延迟低于现有 API 服务,而且

等多个领域展现其强大的多模态能力。此外,智谱清言还具备语音交互功能,使得用户与AI的互动更加自然和高效。

AIGC(人工智能生成内容)结合JMeter实现接口自动化测试脚本生成的方法,主要涉及到通过流量收集工具和AIGC技术获取用户操作接口数据,并利用这些数据生成自动化测试脚本的过程。这种方法可以有效提高软件测试的效率和质量[1]。JMeter是一个开源的负载测试工具,能够模拟多种协议和应用程序的负载,包括HTTP、FTP、SMTP等[3][14]。它可以帮助快速构建测试用例,模拟多种场景,发现接口的