简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

基于 Rsbuild 的静态站点生成器,专为开发者打造的文档站工具!

模型本身是通用的,大家越发意识到沉淀的记忆才是 Agent 的核心资产,但这不止包括使用用户的记忆,还包括 Agent 自身的经验和偏好记忆。:从 DeepSeek 和 Manus 的爆火能发现,在 AI 越来越强大时,用户更渴望白盒化的体验,能看到其思考与决策的轨迹。这种 “先锁定高分目录、再精细探索内容” 的策略,不仅能找到语义最匹配的片段,更能理解信息所在的完整语境,从而提升检索的全局性与准

火山引擎 AICC 机密计算迎来新升级,发布支持 MCP 的可信方案——Trusted MCP,并正式开源该组件。开发者和企业可通过该功能实现 MCP 核心组件及组件间的通信数据安全,有效解决 MCP 应用过程中的数据泄露和身份验证等风险。

3 月 22 日,以《云原生 × AI 时代的微服务架构与技术实践》为主题的 CloudWeGo 技术沙龙将在深圳科技园希尔顿惠庭酒店正式启幕。本次活动汇聚了多位来自字节跳动、火山引擎、智谱 AI 的技术大咖,共同探讨云原生与 AI 技术融合趋势下,微服务架构的演进方向与最佳实践。

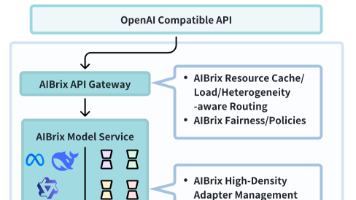

本文详细介绍了如何通过 AIBrix 分布式推理平台实现 DeepSeek-R1 671B 的多节点部署。

2025年2月21日,vLLM通过官方博客宣布了由字节跳动开发的AIBrix大模型推理系统开源,为vLLM推理引擎提供可扩展且高性价比的控制面。开源72 小时内,AIBrix 收获的GitHub Star 数已超 1000, 96 小时突破2000, 截止本文发布保持着榜第一的位置。

AIO Sandbox 通过一个 Docker 镜像整合所有能力,提供统一文件系统与鉴权,并支持镜像定制,提升了 Agent 任务执行与交付效率。

今日,我们正式发布 AIBrix v0.5.0。此版本引入与 OpenAI 兼容的批处理 API,专为处理高吞吐、时延不敏感的离线推理与评估任务设计,有效避免对实时端点造成干扰。同时,新版本集成了全新的 KVCache 连接器(AIBrixOffloadingConnectorV1Type3),借助其流水线式预取与分层卸载机制,显著提升 KVCache 卸载与复用的效率。

字节跳动豆包大模型团队与 M-A-P 社区于近日提出 AutoKaggle ,为数据科学家提供了一个端到端的数据处理解决方案,帮助简化和优化日常数据科学工作流程的同时,极大降低数据科学的门槛,可帮助更多没有相关背景的使用者进行有价值的探索。最后,我们统计了不同错误类型及出现次数,可以看到,每个子任务阶段都有可能发生错误。未来,团队成员还将继续探索智数据科学课题及相关开源工作,并关注 Kaggle

通过和几位 committer 的沟通,我们发现他们对于想参与社区的同学给出了几乎类似的建议。兴趣驱动和业务驱动是两个主要方面,但是只有先用起来,才会发现问题,并通过在社区上寻求帮助或反馈问题逐渐加入社区。同时也非常欢迎大家把使用或者迁移经验分享到社区,并通过丰富社区生态,让 ByConity 社区逐渐壮大。–END–