简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章介绍Google的Antigravity AI IDE支持的Agent Skills功能,Skills是通过编写SKILL.md文档指导AI完成特定任务的标准化方法。文章展示了Skills的两种类型(项目级和全局级),并通过测试表明不同平台对Skills的支持已趋于一致。Skills的价值在于实现一次编写全平台通用、降低创作门槛、启动生态效应,可能开启AI应用开发的新时代。昨天,Google

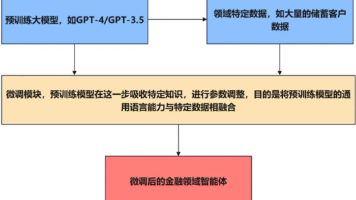

本文详细探讨了基于大语言模型的智能体系统架构与实现方法。从LLM的核心能力出发,解析了智能体的三层结构(感知、决策、执行)及上下文管理机制,并介绍了如何集成API与向量数据库增强智能体功能。文章还介绍了ReAct、Hugging Face和LangChain等主流框架在智能体开发中的应用,为构建高效、灵活的智能体系统提供了全面的技术指导与实践案例。大语言模型(LLM)作为智能体的核心引擎之一,为智

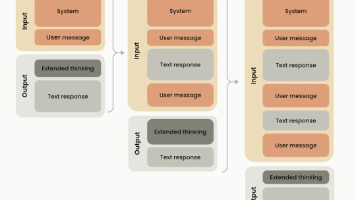

目前 claude 4 sonnet、gemini 3 在 Agent 工具调用的场景下,都强制要求带工具调用的思考内容和签名,这个链路正常是能很大程度提升整体的推理执行效果,是 Agent 多步骤推理的必需品。但目前 Agent 模型的稳定性还是个问题,例如在某些场景下,业务逻辑明确需要下一步应该调工具 A,但模型思考后可能就是会概率性的调工具B,在以前是可以直接 hack 替换调工具调用,或手

文章详细介绍了截至2025年8月全球主流大模型(GPT、Claude、Gemini、LLaMA、ChatGLM等)在不同规模和场景下的硬件需求配置。按模型参数量分类(超小、小型、中型、大型、超大型),分析了各模型在推理、微调等场景下的GPU显存、CPU、内存和存储需求,为个人用户和企业级应用提供了精准配置建议,帮助读者根据需求选择合适硬件。在人工智能飞速发展的当下,大模型应用日益广泛。无论是个人开

课程将介绍多种模型的整合与应用,其中包括支持超过20种整合的LLMs(大语言模型)、聊天模型以及支持10余种整合的文本嵌入模型。这些模型为实现不同任务提供了基础支持,帮助学生深入理解模型的能力和适用场景。重点学习提示的设计和优化,包括提示模板的创建和使用。课程还将涵盖输出解析器的实现(超过5种),并特别介绍如何通过重试和逻辑修复来改进解析。此外,还会探索示例选择器的多种实现,帮助学员掌握提示与任务

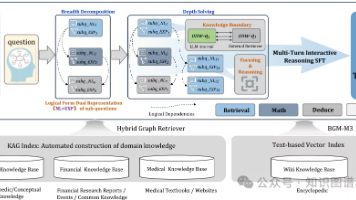

摘要本文介绍了KAG-Thinker,它将知识增强生成(KAG)升级为一个由专用轻量级大型语言模型(LLM)驱动的多轮互动式思考和深度推理框架。我们的方法构建了一个结构化的思考过程,用于解决复杂问题,增强了在特定领域知识库(KBs)上的问答(Q&A)任务中推理过程的逻辑连贯性和上下文一致性。遵循KAG的逻辑形式引导检索和推理技术路线,该框架首先通过广度分解将复杂问题分解为可独立解决的子问题(也称为

一句话来说,Milvus Analyzer 是 Milvus 提供的文本预处理与分词工具,用来将原始文本拆解为 token,并对其进行标准化和清洗,从而更好地支持全文检索和 text match。下面这张架构图展示了 Milvus Analyzer 的整体结构:从图中可以看出,Milvus Analyzer 的整体处理流程可以总结为:原始文本 → Tokenizer → Filter → Toke

本文首先分析了现有基于LLM的模型在如何有效地为LLM提供全面的高阶历史信息方面的不足和挑战。然后本文指出,仅依靠LLM的推理能力进行TKG预测仍然是有限的。为了解决这些问题,本文提出了CoH推理,该推理实现了LLM对高阶历史的有效利用。本文将CoH设计为即插即用,以补充和增强基于图的模型的性能。大量的实验结果证明了CoH的优越性,以及它在提高基于图的TKG预测模型性能方面的有效性。

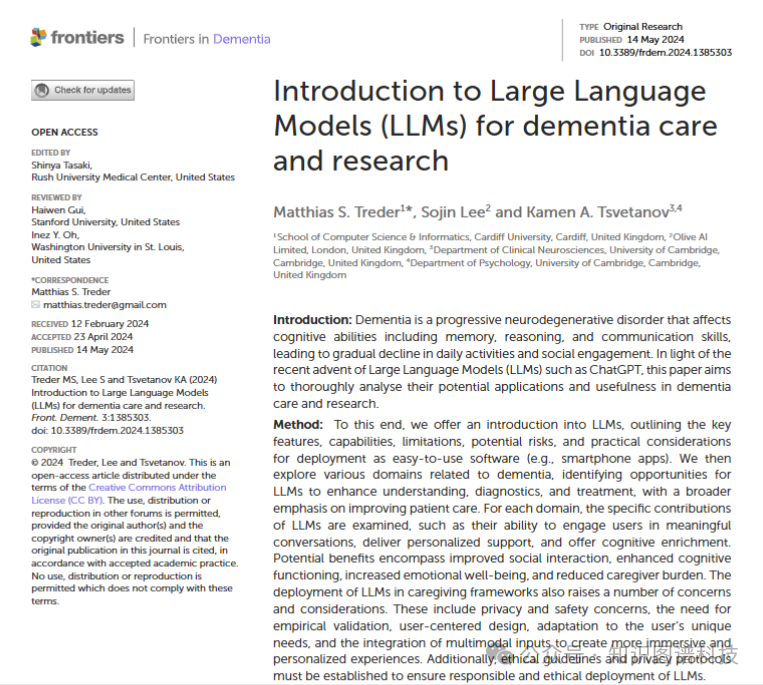

痴呆是一种进行性的神经退行性疾病,影响认知能力,包括记忆力、推理和沟通技能,导致日常活动和社会参与逐渐下降。鉴于近期大型语言模型(LLMs)如ChatGPT的出现,本文旨在全面分析它们在痴呆护理和研究中的潜在应用和用途。:为此,我们介绍了LLMs,概述了它们的关键特征、能力、局限性、潜在风险以及作为易于使用的软件(例如智能手机应用程序)部署的实际考虑因素。然后,我们探讨了与痴呆相关的各个领域,识别

一、前言说实话,当我看到使用 MCP 服务还需要手动复制粘贴 JSON 的时候,包括现在很多 MCP 服务只有工具,没有资源和提示时,我认为 MCP 还不太成熟。随着今年“智能体”的大爆发,使用工具的诉求越来越强烈。随着 MCP 服务市场、MCP 自动配置功能的出现,MCP 的使用门槛正在降低,越来越多的服务宣布支持 MCP 协议,开始要爆发的趋势。