简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

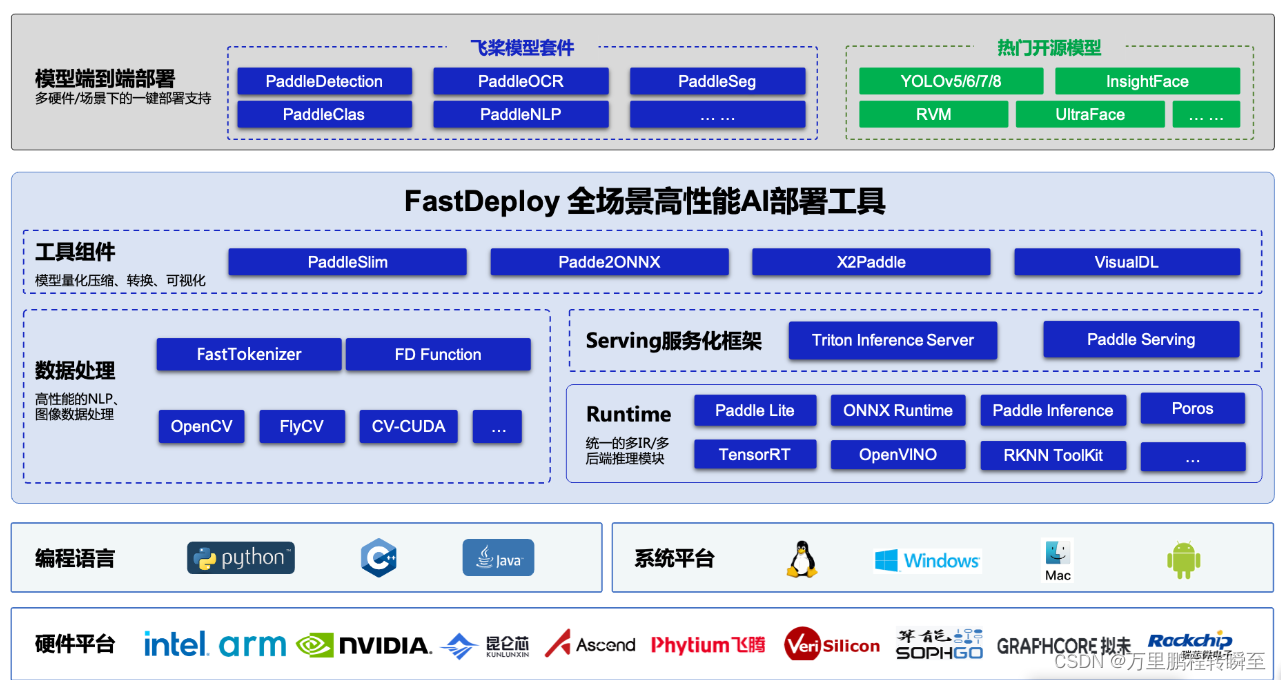

FastDeploy是一款全场景、易用灵活、极致高效的AI推理部署工具, 支持云边端部署。提供超过 🔥160+ Text,Vision, Speech和跨模态模型📦开箱即用的部署体验,并实现🔚端到端的推理性能优化。包括 物体检测、字符识别(OCR)、人脸、人像扣图、多目标跟踪系统、NLP、Stable Diffusion文图生成、TTS 等几十种任务场景,满足开发者多场景、多硬件、多平台的产

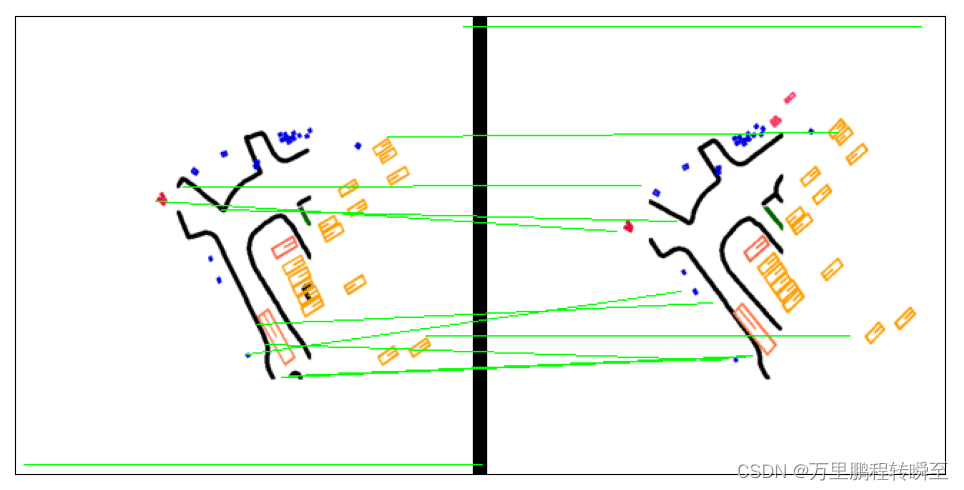

项目地址:https://github.com/Kolkir/Coarse_LoFTR_TRT创建时间:2022年相关训练数据:BlendedMVSLoFTR [19]是一种有效的深度学习方法,可以在图像对上寻找合适的局部特征匹配。本文报道了该方法在低计算性能和有限内存条件下的设备上的优化工作。原来的LoFTR方法是基于一个ResNet [6]backbone和两个基于线性transformer[

发表日期:2023年6月23日LightGlue是一个在精度上媲美Superglue,但在速度上比Superglue快一倍的模型。通过博主实测,LightGlue的配准效果比Superglue好,LightGlue配准后的结果错误点更少,同时提取的重叠区域更精准。基于Superpoint+Superglue 提取重叠区域的代码可以参考。

基于官方团队发布的预训练模型,使用SuperPoint与SuperGlue实现图像配准,可以参考基于官方团队发布的代码训练自己的模型,可以参考进行实现,训练出的模型不能直接参考上述博客进行部署,为此发布使用代码。本博文实现基于进行改进。

项目地址:https://github.com/Linaom1214/TensorRT-For-YOLO-Series/tree/cuda-python算法支持状态:2024.6.16 Support YOLOv9, YOLOv10, changing the TensorRT version to 10.02023.8.15 Support cuda-python2023.5.12 Update

步骤二:将·/usr/local/cuda/targets/x86_64-linux/lib/添加到系统环境变量中。这个可以在/etc/profile文件中增加环境变量,将/usr/local/cuda/bin添加到path中,具体操作如下所示。在使用nvcc命令时,可能也会存在报错。,找到其路径为·/usr/local/cuda/targets/x86_64-linux/lib/

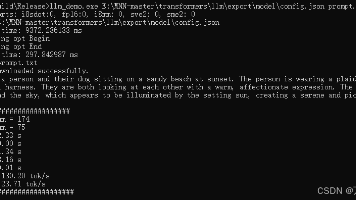

MNN(Mobile Neural Network)是阿里巴巴集团开源的轻量级深度学习推理框架,为移动端、服务器、个人电脑、嵌入式设备等多种设备提供高效的模型部署能力。MNN支持TensorFlow、Caffe、ONNX等主流模型格式,兼容CNN、RNN、GAN等多种网络结构。MNN具备轻量性、通用性、高性能和易用性特点,能在不依赖特定硬件NPU的情况下运行大型模型,支持模型量化和内存优化技术,能

前置要求:conda环境搭建好,已经按照torch-cuda运行环境。

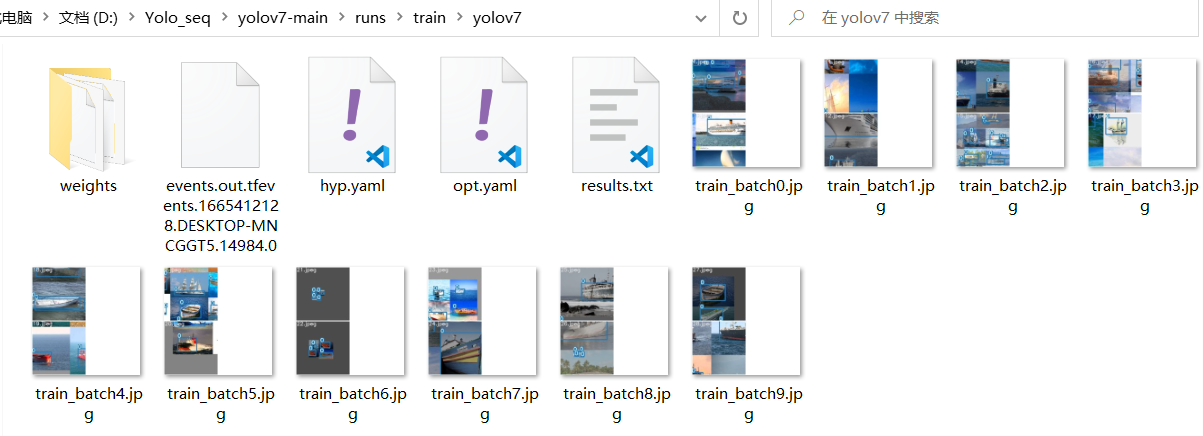

训练前必须先将yolov7.pt存储到yolov7的根目录下,下载链接:https://github.com/WongKinYiu/yolov7/releases/download/v0.1/yolov7.pt。数据下载链接:https://gitcode.net/a486259/data/-/blob/master/shipdata_yolo.zip。这里train就是设置训练集的路径,val是

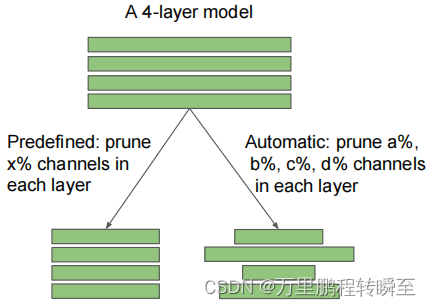

过度参数化是深度神经网络中一个被广泛存在的情况,这导致了高计算成本和高推理内存占用。在低资源环境下,网络剪枝被广泛用于降低深度模型的推理成本。典型的网络剪枝过程包括三个阶段: 1)训练一个大型的、过参数化的模型(有时有预训练后的模型),2)根据一定的标准对训练后的大型模型进行剪枝,3)对剪枝后的模型进行微调,以恢复失去的性能。网络剪枝方法的一个主要分支是个体权重剪枝(非结构化剪枝),该方法基于权重