简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

使用下面这个文件,在8*H100的机器上训练了Qwen2.5-32B模型。上下文窗口8K,batch_size = 8(num_gpu)*2(per_gpu_batch_size)*8(gradient_accumulation_steps) =128,deepspeed采用zero3,显存占用约65G,内存占用约653G(还有数据占的显存,数据量为0.06B tokens),训练时长2 hour

整个管线极度依赖高质量数据工程(olmOCR、合成数据、微退火筛选)。将训练拆解为 Pretrain -> Midtrain -> LongContext -> SFT -> DPO -> RL,每个阶段都有明确的目标和特定的数据配比。大规模应用基于规则验证(如代码执行、数学答案匹配)的强化学习(RLVR),这是提升推理能力的关键。提供了复现上述所有步骤所需的工具链(Olmo-core, Olmo

【代码】自动驾驶强化学习Reward设计代表方法和示例demo。

Constrained Multiobjective Optimization Problems标题发表时间同时带有决策和目标约束的多目标优化问题2019嵌入于MOEA/D的一个自适应约束处理方法2012一种使用可行性引导的改进目标函数的方法2014多目标优化中的约束处理2009.........

解释:如下图,相比fp32,bf16的表示范围不变(还是e8),但精度从m23降到了m7,但在大模型训练时,这种精度损失是可接受的。需要注意,有些老的gpu不支持这个操作。一些新一点的4090,A100,H100等均支持。解释:python的gcc编译优化(优化代码底层执行指令,主要优化了代码中对gpu的读写操作,不影响任何性能),在训练前会花费时间进行编译,但大大加快训练时速度。需要注意,win

Towards artificial general intelligence with hybrid Tianjic chip architecture1.摘要开发AGI(人工通用智能,也叫强人工智能)有两个通用的方法为导向:①计算机科学②神经科学。然而由于它们的公式和编码不一样,这是两个完全不兼容的平台,这也阻碍了AGI的发展。所以一个可以支持流行的基于计算机科学的人工神经网络以及受神经科学启

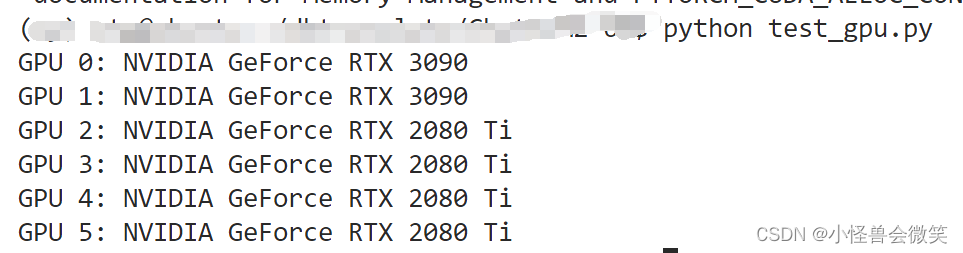

【代码】怎么用python代码查看可用的gpu,然后指定可用的gpu运行。

下载地址,安装方法

FPmax算法Python实现例子import copyimport pandas as pdfrom mlxtend.frequent_patterns import fpmaxfrom mlxtend.preprocessing import TransactionEncoder# 传入模型的数据需要满足特定的格式,可以用这种方法来转换为bool值,也可以用函数转换为0、1def FPmax_

python画带颜色的盒图代码画好后效果图实现代码如下import numpy as npimport matplotlib.pyplot as pltimport pandas as pdif __name__ == '__main__':AA=[5,6,7,8,9,10,3]BB=[9,14,10,13,12,11,10]AA = {'A': AA}BB = {'B': BB}df1 = pd