简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

因疫情带动了口罩识别等项目特殊需求,组织在家工作的多位平时从事非技术工作的同事参加口罩图片数据的收集和标注,大家在家用的多是自己的本子,安装的操作系统自然就是既有Windows也有Mac,不同操作系统的本子上安装过程中遇到多个不同的问题,对于解决办法予以记录一下便于以后再次遇到时快速解决。Windows专业版和Ubuntu系统安装的过程按照https://github.com...

好久以前就体验了,没时间作记录,现在补上。 MNIST(Mixed National Institute of Standards and Technology)是一个手写数字图形数据库,由Yann LeCun(在深度学习的各种书中经常会被提到的大神之一,CNN的提出者) N年前整理出来的,训练数据集有60000个样本,测试数据集有10000个样本,每张图都已进行了尺..

由于pytorch自1.11版开始发生了很大变化,原来基于C实现的THC封装实现的调用cuda、cudnn和cublas的API(只能用NVIDIA的GPU)被基于C++实现的ATen和c10里的API代替(ATen通过vulkan实现支持NVIDIA以外的GPU, ATen代码在https://github.com/pytorch/pytorch/tree/main/aten/src/ATen)

前面说过如何用自己的UCF101数据集训练3D识别模型video-caffe,那么怎么制作自己的UCF101数据集呢?这个稍微有点复杂。UCF101数据集其实是按101个动作类别分类了的短视频的集合,每类动作对应一个目录,每个目录下有很多avi格式的视频文件,我们需要制作自己的项目应用领域的UCF101格式的数据集时,可以像这样把项目应用的视频数据按动作分类这样分目录存放,一个目录对应一个动作,实

【代码】基于Transformer的模型训练过程中经常出现grad_norm值为Nan或Inf的解决办法。

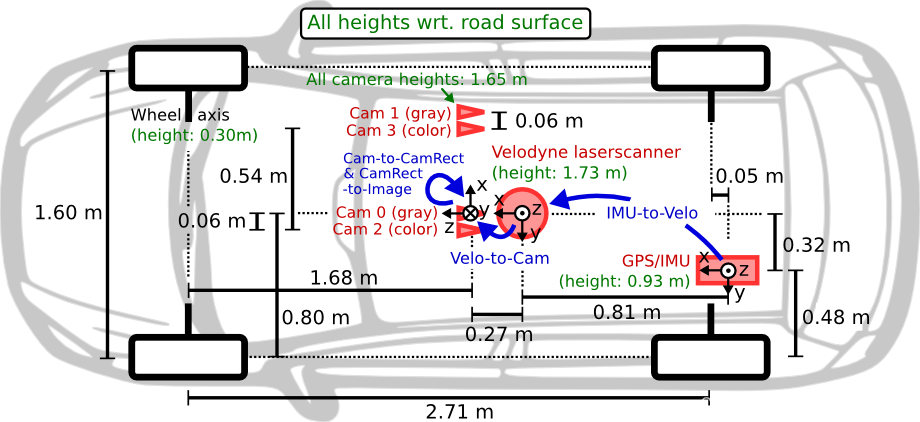

做3D目标检测,首先要了解雷达坐标系和相机坐标系这两个坐标系和数据标注等方面的基础,下面结合kitti3D数据集来讲解。kitti数据集在3D目标检测领域有点类似PASCAL VOC和COCO在2D目标检测和分割领域的经典地位,数据量不算很大,各类别数量很不均衡,但是很多模型要刷榜和发论文都用这个数据集,它里面同时提供了2d和3d目标标注,还有分割和跟踪等数据挺全的,所以用于模型实验和验证以及准

摘要:在多模态模型工程化部署过程中,遇到TensorRT推理输出NaN的问题。经排查发现,问题根源在于averagepool和sigmoid算子导致的数值溢出。通过采用clamp限制数值范围、用HardSigmoid替代Sigmoid等方法进行优化后,模型成功转换为TensorRT引擎并输出正常结果。该案例揭示了多模态模型特征融合模块中数值稳定性对部署的重要性,提供了针对浮点溢出的有效解决方案。

这里的错误导致分配CUDA内存的大小不对,导致后面给这块CUDA内存拷贝赋值时发生了越界访问从而把CUDA内存搞脏了,然后错误就发生在前面那个核函数调用的地方。CUDA内存弄脏后再访问CUDA内存会出错,但是报的错一般是让你根本无法看出准确原因的,出现莫名其妙的错误时,可能需要整个排查而不是只盯着出错处查,否则可能折腾很久浪费时间还是不知道原因在哪里。有时忘了这个经验浪费不少时间,记录一下备忘。

在一个复杂的机器人后端控制平台系统开发完成以前,往往需要对你的机器人产品进行简单的软件架构设计验证或进行控制测试,这时,如果能花比较少的时间快速做一个web页面或者一个Android app来作此用途的话能节省不少人力,本人花比较少的时间做了一个web demo和几个安卓app用于不同机器人的通讯和控制的验证和测试,先只说怎么做web demo,实现安卓app的思路跟基于Java EE开...

一般来说,使用NVIDIA官网上下载的sdk image烧写入SD卡或者使用sdk manager/jet package连到板子安装全部软件后,里面什么都有了,包括docker和nvidia docker里面都有了,使用nvidia docker可以把GPU用起来,但是如果误删或者不小心弄坏了docker,或者为了减少发布系统的image的大小,尽量减少不需要安装的软件包,比如想从最基本的Bas