简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

faiss-gpu版本需要与python版本相对应,而且python3.9以上版本大概率用不了faiss-gpu,如果自己的python版本过高请降低python版本试试。

Linux新环境安装cuda和对应版本的cudnn

faiss-gpu版本需要与python版本相对应,而且python3.9以上版本大概率用不了faiss-gpu,如果自己的python版本过高请降低python版本试试。

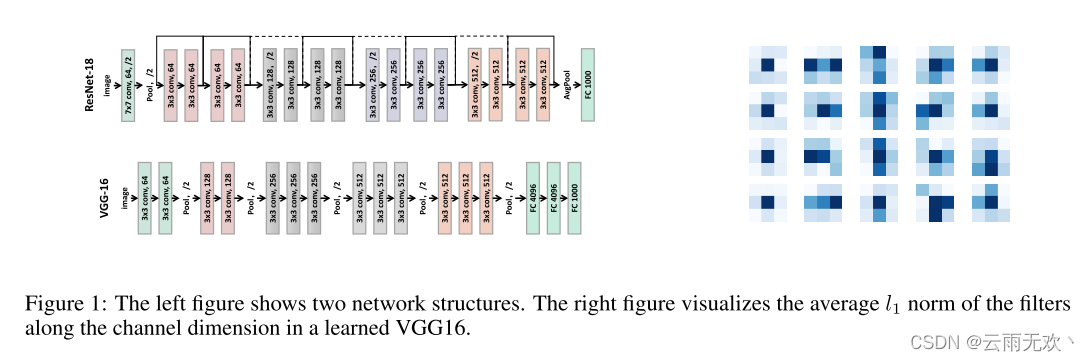

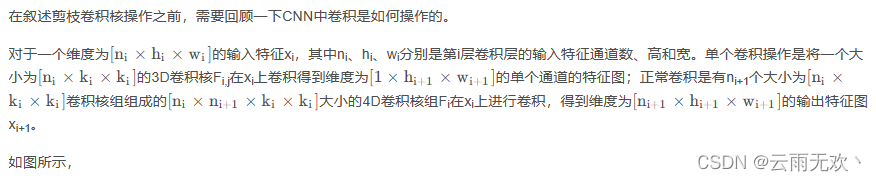

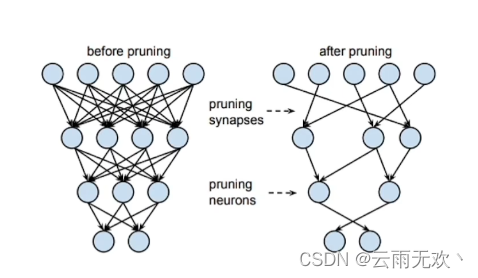

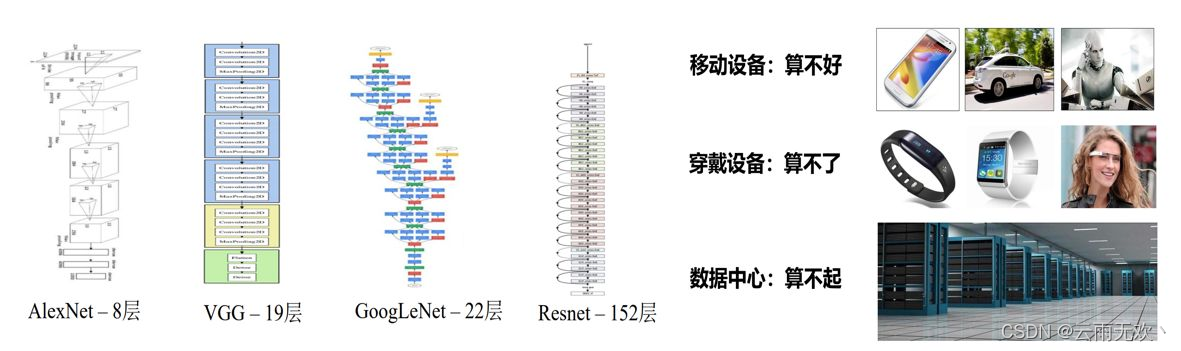

cnn在各种应用中的成功伴随着计算和参数存储成本的显著增加。最近为减少这些开销所做的努力包括在不损害原始准确性的情况下修剪和压缩各个层的权重。然而,基于幅度的权值剪枝会从全连通层中减少大量的参数,由于剪枝网络的不规则稀疏性,可能不能充分降低卷积层的计算成本。我们提出了一种针对cnn的加速方法,在这种方法中,我们从被识别为对输出精度有小影响的cnn中删除滤波器。通过去除网络中的整个滤波器及其连接特征

在介绍剪枝之前,首先来过参数化这个概念,过参数化主要是指在训练阶段,在数学上需要进行大量的微分求解,去捕捉数据中微小的变化信息,一旦完成迭代式的训练之后,网络模型在推理的时候就不需要这么多参数。而剪枝算法正是基于过参数化的理论基础提出来的。剪枝算法的核心思想就是减少网络模型中参数量和计算量,同时尽量保证模型的性能不受影响。

从轻量化网络结构定义来看,我们可以将轻量化网络分为轻量化网络结构设计和模型压缩两大类,其中模型压缩又可细分为知识蒸馏、剪枝、量化、低秩分解四个小类别。

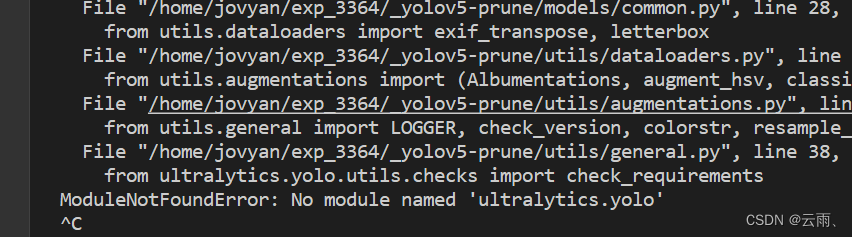

【代码】【yolov5报错解决】ModuleNotFoundError: No module named‘ultralytics.yolo‘

深度神经网络(DNN)在许多领域取得了显着进展,包括语音识别[1],计算机视觉[2,3],自然语言处理[4]等。然而,由于DNN中的大量参数,模型部署有时是昂贵的。为了缓解这样的问题,已经提出了许多方法来压缩DNN并减少计算量。这些方法可分为两大类:权重修剪(WP)和滤波器(信道)修剪(FP)。WP是细粒度修剪方法,其修剪各个权重,例如,其值接近0,在网络[5,6]内,导致稀疏网络而不牺牲预测性能