简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这里通过一些主流的面试题目与网上搜索到的题目进行一个汇总与讲解,无论是学习还是面试都是有益的。我还是坚持以往的讲解方式吧,我们不仅要知道是什么,还要知道为什么,更要知道最底层原因

当前的基座模型其实已经足够聪明。它们在预训练阶段就吞噬了人类几乎所有的知识。强化学习(RLHF)及其变体,本质上并不是在教大模型‘学习新知识’,而是像一个极其高明的采访者,把模型脑子里本来就有的东西,以人类最喜欢的格式、最严密的逻辑‘引诱’出来。因此,在很多场景下,我们并不总是需要盲目追求更大参数的模型。参数少不等于性能弱!一个参数量适中、但经过极高标准优化(如 KTO、PRM 或极致的规则驱动

很多同学在学习 PPO(Proximal Policy Optimization)时,往往止步于复杂的数学公式。理论看懂了,真要动手写代码时却无从下手。本文不谈晦涩的公式推导,而是聚焦于工程实现。我们将基于 PyTorch,从环境搭建、网络设计(Actor-Critic)、到核心的优势函数计算与 Clip 更新,一步步手写代码,最终训练出一个能完美降落的 LunarLander 智能体。如果你也想

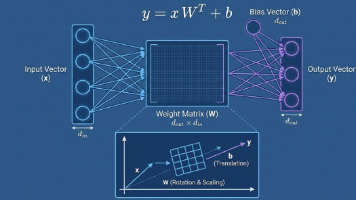

需要手写训练所需的组件,而不是直接调用库函数:Cross-Entropy Loss: 手写交叉熵损失函数,注意处理 LogSumExp 的数值稳定性 。AdamW 优化器: 手写 AdamW 优化算法,包括动量更新和权重衰减逻辑。学习率调度:实现 Cosine Annealing(余弦退火)学习率调度器,带 Warmup 阶段 。Checkpointing:实现模型和优化器状态的保存与加载 。Da

这一章节会非常长,我们不仅要会写代码,还要把所有知识点吃透,不满足简单的定理,以及我会问一些及其深刻的问题,作为一个小点收尾,我敢打包票的事,你用一周或者两周时间吃透这篇博客,你的能力会有质的飞跃。

四元数是复数(Complex Numbers)在四维空间的扩展。一个四元数由一个实部(Scalar,)和三个虚部(Vector,)组成:或者写成向量形式:在具身智能的工程实践中,为了描述旋转,我们只使用单位四元数 (Unit Quaternion)

四元数是复数(Complex Numbers)在四维空间的扩展。一个四元数由一个实部(Scalar,)和三个虚部(Vector,)组成:或者写成向量形式:在具身智能的工程实践中,为了描述旋转,我们只使用单位四元数 (Unit Quaternion)

1.在 20 分钟的通信闭环里,你发出的指令是基于“过去”的状态(10分钟前),执行的动作将发生在“未来”(10分钟后)。因为仿真器里的物理引擎(Physics Engine)是基于简化公式的,它无法完美模拟现实世界中复杂的空气动力学、软体形变、温度对电路的影响,以及延迟和随机噪声。我们在仿真器(Simulation)里训练机器人时,就像在一个没有延迟、没有噪声的完美真空中。你看到敌人,开枪,但什

1.在 20 分钟的通信闭环里,你发出的指令是基于“过去”的状态(10分钟前),执行的动作将发生在“未来”(10分钟后)。因为仿真器里的物理引擎(Physics Engine)是基于简化公式的,它无法完美模拟现实世界中复杂的空气动力学、软体形变、温度对电路的影响,以及延迟和随机噪声。我们在仿真器(Simulation)里训练机器人时,就像在一个没有延迟、没有噪声的完美真空中。你看到敌人,开枪,但什

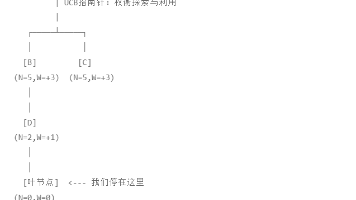

网上关于 MCTS(蒙特卡洛树搜索)的原理讲解很多,但能从直觉到公式,再到代码落地讲透的却很少。本文将分 10 个章节,像剥洋葱一样拆解 MCTS。我们要抛弃复杂的深度学习框架,仅用纯 Python,从最基础的“多臂老虎机”原理讲起,推导 UCB 公式,直到手写出一个完整的、能玩井字棋的 AI。无论你是 DRL 初学者还是想探究 AlphaGo 原理的开发者,这篇文章都能带你彻底通关。