简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

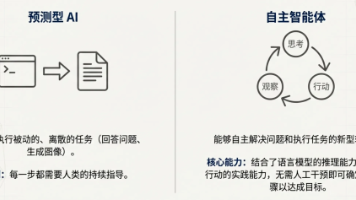

*AI Agent:**是一种由大语言模型、工具、编排层和运行时服务所构成的程序。他通过循环调用大语言模型来达成最终的目标。大模型是一个行动无能的天才,而Agent则是通过软件开发的方式,将大模型封装成一个可以自行处理某项任务的软件。**Tips:**这里与我们之前编写的软件还不一样,我们先前编写的软件是一套固定的规则流程,他接受固定的输入,会流经固定的路径,产生固定的输出;而Agent则更“智能

Anthropic推出的Agent Skills标准是一套可复用指令集,让AI Agent按需挂载特定场景能力,解决了传统提示词重复撰写和占用上下文的痛点。相比MCP,Skills门槛更低、通用性更强,已被OpenAI、VS Code等主流工具兼容。国内特赞团队推出的skill0平台已聚合423个通用Skills,支持多款工具直接装配。2026年可能成为Skills规模化落地的元年,国内团队在这场

AI时代不跟风,抓牢大模型这个“硬核底座”就赢了!它是“概率猜题大师”,能帮你提效开挂,但也有短板——懂它的功能、避它的坑,不用硬啃技术,按需用就够香~

Agent Skills是将专业知识、工作流规范固化为可复用资产的核心工具,它不是工具本身,而是行为规范、专业知识和使用时机的组合。一个Skill就是一个文件夹,包含SKILL.md文件和可选资源文件,通过渐进式披露(三层加载)为AI提供操作指导。Skills相当于给AI代理发放专业手册,使AI能够根据任务自动调用知识,实现更高效、可靠的AI应用。Agent 是智能体,Skills 是技能的意思,

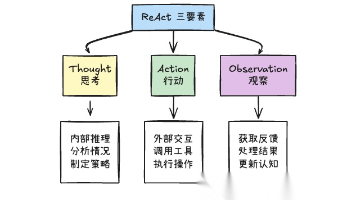

ReAct = Reasoning(推理)+ Acting(行动)这是一种让大语言模型能够交替进行推理和行动的架构模式,通过与外部工具交互来解决复杂问题。ReAct 是一种认知架构模式• ✅ 交替进行内部推理和外部行动• ✅ 通过工具调用获取实时信息• ✅ 根据观察结果动态调整策略• ✅ 形成闭环反馈系统模型如何决定使用哪个工具?ReAct 本质:Thought(思考)→ Action(行动)→

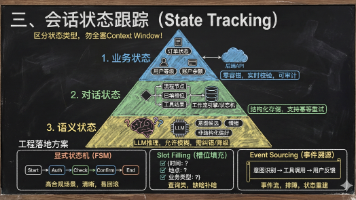

文章介绍智能客服Agent的设计哲学与实现方法,强调"拒绝闲聊,追求收敛"的核心理念。详细阐述风险分层架构设计、三层状态管理模型(业务状态、对话状态、语义状态)、模糊意图处理策略,以及工程化交付标准。指出优秀的客服Agent是严谨的业务工作流AI智能体系统,而非简单聊天机器人,需通过可观测性、兜底机制和SLA保障确保系统稳定性。

文章介绍智能客服Agent的设计哲学与实现方法,强调"拒绝闲聊,追求收敛"的核心理念。详细阐述风险分层架构设计、三层状态管理模型(业务状态、对话状态、语义状态)、模糊意图处理策略,以及工程化交付标准。指出优秀的客服Agent是严谨的业务工作流AI智能体系统,而非简单聊天机器人,需通过可观测性、兜底机制和SLA保障确保系统稳定性。

Agentic RAG技术引入智能代理概念,实现自主决策、工具选择和答案验证,显著提升客服系统智能化水平。该技术降低了智能客服门槛,让小微商家和个人创业者也能拥有媲美大企业的"超级客服"。文章详细介绍了其在电商、客服等领域的应用场景、三大落地方式及低成本实现路径,帮助普通人将复杂智能客服变得触手可及,提升客户体验和业务效率。“预测未来的最好方法,就是去创造未来。”——彼得·德鲁克在过去几年里,人工

就在昨天,马斯克的Grok4终于正式发布了。Grok3.5跳票。老马的直播还迟到1h也是没谁了,全世界都被耍猴。最贵版本,300美刀,可以思考大几十分钟,一般人也用不上。直播表示,Grok-4“能够进行超人级别的推理”(It can reason at a superhuman level!),并且在多项高难度基准测试上实现了对现有顶尖模型的碾压。Artificial Analysis 获得早期访

回溯到 2024 年 4 月,Jina Reader 作为首个面向 LLM 的 Markdown API 横空出世,它引领了新的技术趋势,赢得了广泛的社区认可。更重要的是,它激励我们去构建用于数据清理和提取的小型语言模型。更好的长文本处理能力、对输入指令的支持,以及将特定网页内容提取为 Markdown 格式的能力。我们再次证明,通过精心的训练和调优,小型语言模型同样可以达到甚至超越大型模型的先进