简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

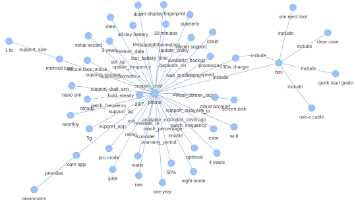

本文介绍了一个基于知识图谱和大语言模型(Gemma3-4b)构建的简易问答系统。系统通过从用户问题中抽取实体和关系,在知识图谱中查找相关路径和关系,然后将这些信息与原始问题一起提供给LLM生成答案。作者提供了完整的代码实现,展示了如何从FAQ文档构建知识图谱并构建问答系统,同时也讨论了系统的局限性及可能的改进方向。

通义千问系列即将完成从多模态到超强推理的进化闭环阿里云CTO周靖人团队近日向业界投下重磅炸弹——。在DeepSeek-R1掀起行业震荡后,这个被内部称为「推理革命」的战略级产品,正在重塑中国大模型产业的竞争格局。从Qwen2.5全球前十的惊艳亮相,到如今剑指推理巅峰的技术跃进,阿里云用18个月时间完成了其他厂商需要3年走完的技术长征。推理能力成核心战场据知情人士透露,。研发团队在强化学习框架中引入

本文对比了三大主流大模型推理框架vLLM、SGLang和TensorRT-LLM的技术特点。vLLM通过PagedAttention和Continuous Batching技术显著提升显存利用率至95%,适合高并发企业应用;SGLang采用RadixAttention实现多轮对话KV缓存复用,吞吐量比vLLM高5倍,是Agent场景的理想选择;TensorRT-LLM通过预编译和极致量化实现最低延

学习大模型需要打好数学与编程基础。数学方面需掌握线性代数(矩阵、向量等)、微积分(导数、积分)和概率统计(概率分布、贝叶斯定理),推荐Khan Academy和MIT的公开课。编程方面需熟练使用Python,并掌握数据结构(数组、链表等)和算法(排序、搜索等),可通过Codecademy和Coursera课程学习,配合LeetCode练习。扎实的基础知识是深入大模型领域的关键。

国家数据局部署2026年重点工作提出,**强化数据赋能人工智能发展**,进一步落实高质量数据集建设行动计划,深入实施强基扩容、应用赋能、提质增效、管理服务、价值释放等6大专项行动。那么到底什么样的数据能够直接给到智能体应用,中间有哪些转换过程,为什么人工智能发展到现在,数据治理被认为是核心卡点。本文以法人数据为例,讲解从传统数据平台上存储的数据,经过怎样的转换,才可以让智能体准确的使用。

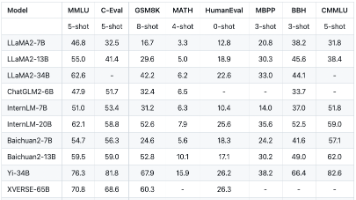

本文系统探讨了大语言模型的评测方法,指出当前评测体系包含MMLU、C-Eval等核心数据集,覆盖自然语言理解、知识推理等关键维度。文章揭示了厂商"刷榜"现象,建议应关注模型实际能力而非榜单排名。同时详细介绍了少样本/零样本测试方法及SOTA概念,强调评测应以应用效果为导向。作者认为,当前大模型评测存在过度优化指标的问题,需警惕为追求榜单排名导致模型能力失衡的风险。

摘要:RAG(检索增强生成)和模型微调是优化大语言模型的两大主流方法。RAG通过连接外部知识库实时检索信息生成答案,适合知识更新频繁的场景,但依赖检索质量且实现复杂。模型微调则通过特定数据训练调整模型参数,适用于专业化任务,但成本高且知识静态。核心区别在于RAG动态获取外部信息,微调则优化模型内部参数。实际应用中,建议从简单方案开始,根据数据质量和需求灵活选择或组合两种方法。随着AI应用层需求激增

自 ChatGPT 发布以来,大型语言模型(LLM)已经成为推动人工智能发展的关键技术。近期,机器学习和 AI 研究员、畅销书《Python 机器学习》作者 Sebastian Raschka 又写了一本新书 ——《Build a Large Language Model (From Scratch)》,旨在讲解从头开始构建大型语言模型的整个过程,包括如何创建、训练和调整大型语言模型。对GPT大模

时间序列预测是一个至关重要的任务,它为经济规划、供应链管理和医学诊断等各个领域的决策提供了关键信息。过去,传统统计方法和机器学习曾被广泛应用于时间序列预测问题,然而,随着多种基础的深度学习架构如多层感知机(MLP)、卷积神经网络(CNN)、递归神经网络(RNN)和图神经网络(GNN)的发展,这些架构被逐步应用于时间序列预测问题的解决。然而,由于每种深度学习架构的归纳偏置所带来的结构性限制,它们的性

今天到了两块新的3090卡,用nvidia-smi看下部署情况。我们使用Qwen2.5-7B简单做了下推理测试。3090卡的基本配置信息如下图所示,使用两块卡做成GPU集群,显存有48G,内存带宽936.2 GB/s, 基本上可以应对一些常见的大模型推理服务以及模型的微调,甚至用QLora能支持650亿参数模型的微调【1】。在上次文章中我们介绍了如何预估模型占用GPU的资源《大模型显存资源计算以及