简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

堆和栈是操作系统内存概念,cc++直接用系统堆栈,javago通过内存逃逸分析来确定哪些放到堆栈,python直接用堆,这句话对吗?说说你的理解

非交互式修改密码echo 123456 | passwd --stdin user002echo "user003:123456" | chpasswd详解:https://www.cnblogs.com/diantong/p/9889034.html(1).命令passwdpasswd [-k] [-l] [-u [-f]] [-d] [-e] [-n mindays] [-x maxdays]

Linux 系统日常巡检脚本,巡检内容包含了,磁盘,内存 cpu 进程 文件更改 用户登录等一系列的操作 直接用就行了。报告以邮件发送到邮箱 在log下生成巡检报告。可以直接发送至邮箱。注释:本人并非原作者,请保留原作者的注释信息。

因为springboot3不再支持java8,最近开始转java17,具体要求如下Spring Boot 3要求使用Java 17或更高版本,不支持Java 8。 Spring Boot 3.0 正式版已经发布,并且明确要求最低支持Java 1712。Spring Boot 3.0 正式版发布后,官方明确表示不再支持 Java 8。Spring Boot 3.0 M1 发布时,就已经正式弃用

1 restful架构详解:https://www.cnblogs.com/yanggb/p/10597443.html2 Restful、SOAP、RPC、SOA、微服务之间的区别原文:https://blog.csdn.net/liuhuiteng/article/details/89398240一、介绍Restful、SOAP、RPC、SOA以及微服务1.1、什么是Restful?Restf

本文详细介绍了Windows 10 WSL Ubuntu子系统的离线安装与基础配置方法。主要内容包括:1)WSL功能启用与Ubuntu离线安装;2)系统初始化、常用工具安装及阿里云镜像源配置;3)SSH服务安装与自启动配置;4)主机名修改方法;5)Docker安装及解决iptables冲突的方案;6)网络配置优化与常用操作脚本。文中提供了完整的命令和配置文件示例,特别针对WSL环境下的特殊配置需求

摘要:Win10默认生成的OpenSSH格式私钥可能导致Xshell导入失败。解决方案:1) 用ssh-keygen -p -m PEM -f id_rsa转换为PEM格式;2) 在Xshell中导入转换后的密钥。备选方案:直接在Xshell生成新密钥并配置到服务器。MAC用户可能也存在类似问题,需进一步排查。建议优先尝试格式转换,避免重新配置服务器公钥。(150字)

1、/var/log/secure 记录登录系统存取数据的文件(例如:pop3,ssh,telnet,ftp等都会记录在此);2、/ar/log/btmp 记录登录信息记录,被编码过,所以必须以lastb解析;lastb | awk ‘{ print $3}’ | sort | uniq -c | sort -nr | moreCopy3、/var/log/message 几乎所有的开机系统发生的

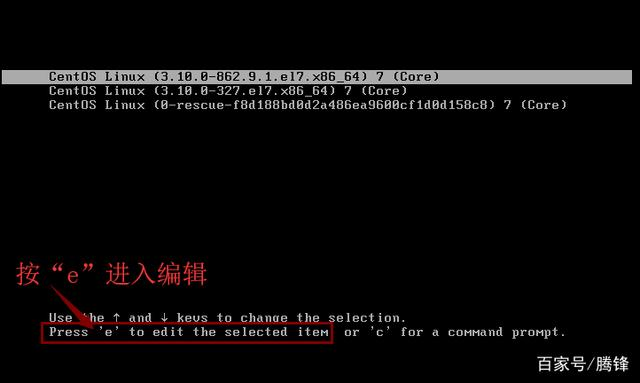

如果你在安装liunx centos 7系统安装时未设置用户密码或者管理员密码忘记,请执行以下操作步骤首先,打开centos7,在选择进入系统的界面按“e”进入编辑页面。然后按向下键,找到以“Linux16”开头的行,在该行的最后面输入“init=/bin/sh”接下来按“ctrl+X”组合键进入单用户模式然后输入“ls”查询当前位置(也可以省略),回车接下来再输入“mount -o remoun

本文介绍了在腾讯云CVM上部署最新版GitLab 18的完整方案。针对国内用户访问官方镜像困难的问题,采用腾讯云官方镜像仓库同步的GitLab镜像。部署过程包括目录准备、镜像拉取、容器启动(映射8008/8443/8222端口)和版本验证。重点说明初始密码设置方法,并提供常用维护命令。分析了该方案的优劣势:优势在于网络稳定、版本同步、数据自主;劣势是需要自行维护和较高资源需求。适用中小企业开发测试