简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

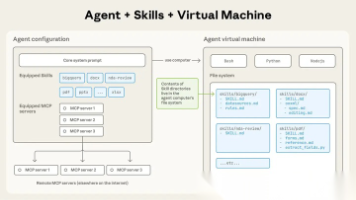

Agent Skills是Claude发布的跨平台可移植性开放标准,本质是将个人或团队的SOP变成Agent可长期复用的"技能包"。通过发现、激活、执行三步工作,Skills实现"经验→自动化→复用",比临时性Prompt和连接型MCP更具优势。文章介绍了多个Agent Skills平台资源,并以Cursor为例演示了安装使用方法,帮助读者快速掌握这一热门AI技能。

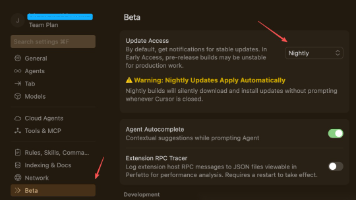

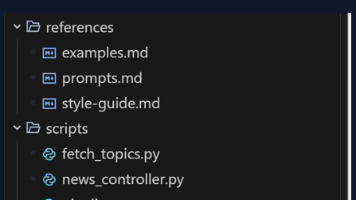

文章介绍了Cursor编辑器中Agent Skills功能的实战教程,包括升级Cursor、创建Skill文档、自动创建项目目录和使用技能等。Skills本质上是统一规范的需求文档集合,能帮助AI编程工具更全面实现业务逻辑,减少后期改动。通过标准化技能文档,AI能从一开始就按照统一标准尽可能覆盖所有需要实现的逻辑,提高开发质量和效率。

文章介绍了Google AI IDE "Antigravity" 正式支持 Agent Skills。Skills 本质是指导AI执行任务的 Markdown 文档(SOP),实现了“一次编写,全平台通用”。经测试,Claude、Codex、Gemini 等主流平台对 Skills 的兼容性极佳。这标志着大模型开发门槛大幅降低,Agent 生态或将迎来类似 App Store 的爆发时刻。

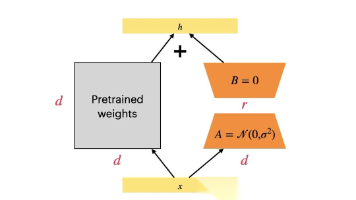

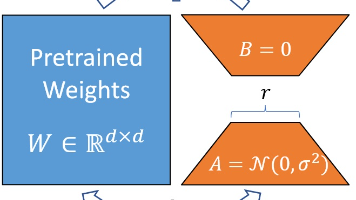

LoRA是参数高效微调技术,通过冻结原始参数并插入低秩旁路来训练少量参数。它解决了大模型微调的高计算成本问题,大幅降低显存需求(从TB到GB),可训练参数不到1%,性能与全参数微调相当。LoRA已成为大模型平民化的关键技术,使中小企业和个人开发者也能基于大模型开发垂直应用。

文章详解三种大模型参数高效微调技术:LoRA通过低秩矩阵分解减少可训练参数;QLoRA引入4位量化技术进一步降低内存需求;AdaLoRA动态调整低秩矩阵秩以适应不同任务。这些方法显著降低资源消耗,同时保持模型性能,使个人开发者在有限硬件条件下高效微调大模型。

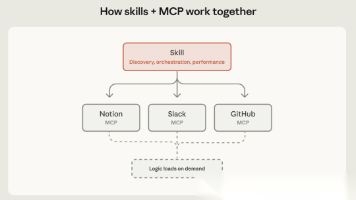

本文深入探讨了Anthropic的Skills与MCP如何协同工作构建智能代理。MCP提供外部工具连接性,Skills提供工作流程逻辑和专业知识,两者结合可创建遵循特定流程、产生一致输出的智能系统。文章通过金融分析、会议准备等案例展示了实际应用,并提供了何时使用Skills与MCP的指导原则,帮助开发者构建更高效、更标准化的AI工作流程。

RAG(检索增强生成)是为AI配备专属知识库和搜索引擎的技术,避免AI瞎编,提高答案准确性、时效性和可追溯性。RAG有三大核心形态:传统RAG(检索重排序后生成)、Graph RAG(基于知识图谱理解信息逻辑)和Agentic RAG(具有自主智能体,能拆解问题、调用工具)。落地RAG的关键在于匹配业务场景,建设高质量知识库,并规避测试和应用局限。

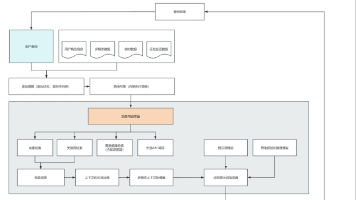

本文详细介绍了LangGraph多智能体系统的两种核心架构模式:主管架构通过中央主管智能体管理多个专业智能体,适合结构化任务;分层架构引入团队层级概念,由顶层主管协调团队主管,有效解决了主管架构的扩展性问题。文章通过代码实例展示了两种架构的实现方式,帮助开发者构建更灵活、强大的多智能体应用,以应对复杂业务场景。

文章详细解析了Open Deep Research项目中用户澄清阶段的实现机制。通过分析clarify_with_user函数,解释了配置检查、模型准备、澄清分析和流程路由四个步骤的工作原理,以及State中messages字段的流转和更新过程。同时介绍了结构化输出模型和提示词设计,帮助读者理解AI Agent如何智能处理用户输入,确保研究方向的准确性。

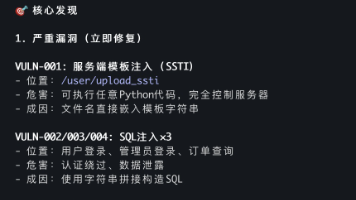

作者利用两天时间,通过CodeBuddy创建了一套代码审计Skill,结合Claude LSP技术实现了AI自动安全审计。该方案包含12个模块、5个阶段,支持从HTTP入口开始的双向追踪漏洞分析,可生成完整调用链和PoC。与传统工具相比,此方案能发现技术漏洞和业务逻辑漏洞,误报率更低,支持攻击链分析。文章详细分享了从概念理解到实现的全过程,展示了"训练AI写代码"的创新方法。